Podczas zeszłotygodniowego seminarium SEOmoz.org Ben Hendrickson zaprezentował unikalną technikę pozycjonerską. Prezentacja została przyjęta więcej niż entuzjastycznie – nigdy wcześniej nie byłem świadkiem branżowego spotkania, które byłoby kilkukrotnie przerywane gromkimi oklaskami.

Wątpię, by udało mi się odtworzyć tamtą ekscytację, podzielaną spontanicznie przez 320 uczestników seminarium, za pomocą artykułu; za cel przyjmuję wyjaśnienie konceptu modelowania tematycznego (oryg. „topic modeling”), modelu przestrzeni wektorowej (oryg. „vector space model”), ich związku z wyszukiwaniem i przybliżenie naszych prac nad wykorzystaniem LDA (rozkład Dirichleta z ukrytymi zmiennymi, oryg. Latent Dirichlet Allocation). Spróbuję także wyjaśnić związki tych teoretycznych narzędzi z SEO i ich praktyczne w pozycjonowaniu zastosowania.

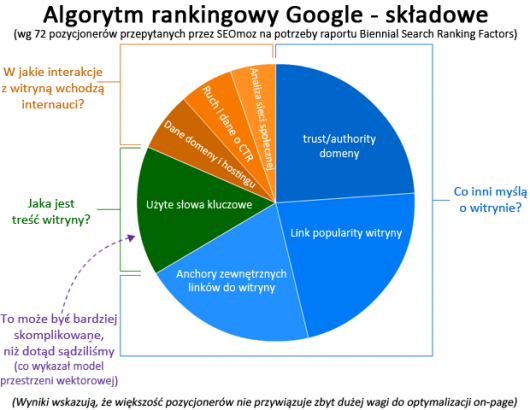

Jakie czynniki decydują o rankingu – wykres

Wielu z was słyszało pewnie o badaniu ankietowym dotyczącym czynników rankingowych, jakie co dwa lata przeprowadza SEOmoz (już za rok kolejna fala tego badania; spodziewam się wyjątkowo ciekawych wyników!). W SEOmoz zdajemy sobie oczywiście sprawę, że metoda oparta o uśrednianie opinii pozycjonerów nie jest doskonała, niektórych czynników może brakować, inne mogą zostać przecenione lub niedocenione.

Poniżej znajduje się wykres, który stworzyłem na potrzeby niedawnej prezentacji. Wykres podsumowuje badanie, pokazując najważniejsze grupy czynników rankingowych:

Na podstawie wszystkich pomiarów, testów i obserwacji SERP-ów sam często odnoszę wrażenie, że waga czynników on-page, takich jak częstość słów czy TF*IDF (skrót wyjaśniony poniżej), jest dość mała. Nawet dla mało konkurencyjnych słów kluczowych nie widuje się SERP-ów, którymi można by zamieszać dodając do treści jednej z witryn więcej słów kluczowych, synonimów lub słów powiązanych tematycznie. Takie a nie inne doświadczenia, podzielane także przez licznych spośród moich rozmówców, skłoniły mnie do przyjęcia założenia, że o pozycji w wynikach wyszukiwania decydują przede wszystkim linki.

Ale ja bardzo lubię się mylić.

Nasze doświadczenia z modelowaniem tematycznym (topic modeling), szczególnie te przeprowadzone z użyciem procesu zwanego LDA, wykazały jego zadziwiającą skuteczność. Wytworzyło to we mnie (i – jak sądzę – u większości słuchaczy zeszłowtorkowej prezentacji Bena) wątpliwości, czy nasze dotychczasowe rozumienie czynników „on-page” nie było zbyt uproszczone i czy nie spaczyło naszego nastawienia.

Do czego wyszukiwarki potrzebują modelowania tematycznego?

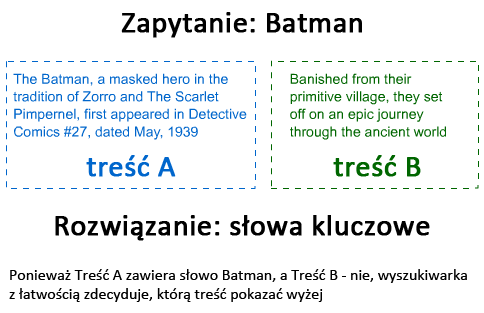

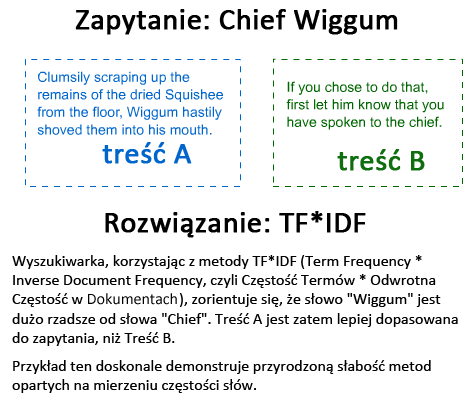

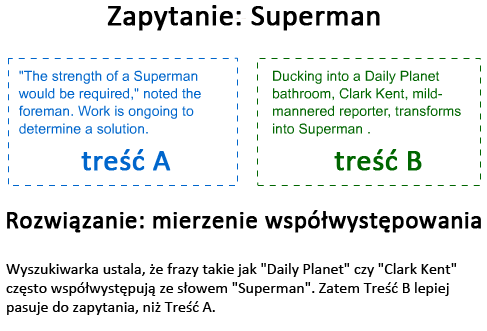

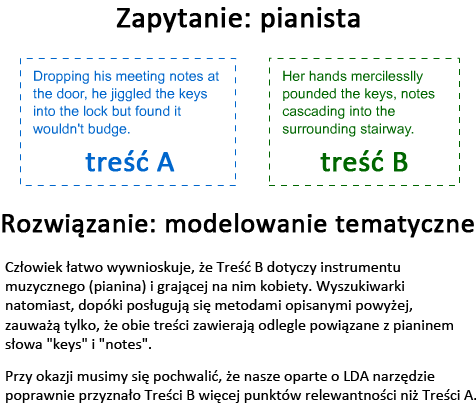

Niektóre zapytania są naprawdę proste – np. zapytanie o „wikipedię” jest jednoznaczne, a relewantne wyniki dla niego zwrócić potrafi nawet bardzo prymitywna wyszukiwarka. Są jednak trudniejsze zapytania. Spójrzmy teraz na metody, jakimi wyszukiwarki ustalają kolejność dwóch wyników – problem niby prosty, mogący jednak w określonych sytuacjach zdecydowanie przybrać na złożoności.

Wyszukiwarki muszą umieć rozpoznawać intencje każdej pojedynczej podstrony. Jest to szczególnie istotne gdy zapytanie jest złożone lub gdy jest dla niego bardzo wiele treściowo relewantnych wyników. To oczywiste, że cztero- czy nawet pięciokrotne użycie słowa kluczowego, choćby w kluczowych miejscach strony, a nawet dodatkowe wystąpienia jego synonimów/słów powiązanych tematycznie, nie musi koniecznie oznaczać, że strona naprawdę odpowiada zapytaniu internauty.

Modelowanie tematyczne, w tym LDA, to nie żadna nowość, a nasze działania to nie rewolucja. Są to pojęcia znane od lat, także w branży SEO; wielu pozycjonerów włożyło sporo pracy w próby ich praktycznego zastosowania. Jednak, zgodnie z naszą wiedzą, nikt dotąd nie udostępnił publicznie narzędzia do modelowania tematycznego, ani nie porównał wyników analizy tą metodą z wynikami wyszukiwania w Google (np. żeby przekonać się jak ważna dla Google jest treść on-page). Najciekawszą częścią prezentacji Bena (w mojej opinii) są właśnie przedstawione przez niego liczby.

Przestrzeń wektorowa termów i modelowanie tematyczne

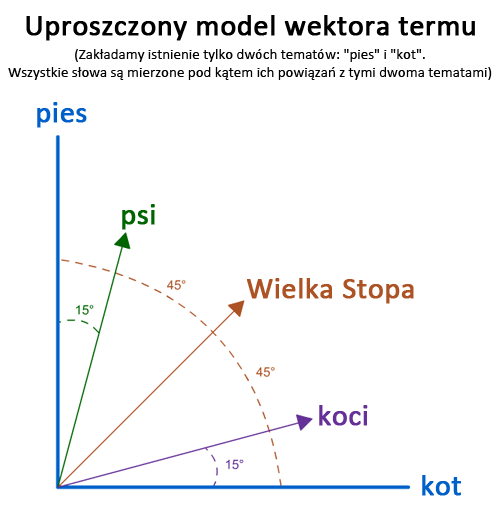

Przestrzeń wektorowa termów, modelowanie tematyczne i podobieństwo cosinusów (oryg. „cosine similarity”) wyglądają na trudne pojęcia i kiedy Ben pierwszy raz wspomniał o nich na prezentacji, wielu spośród słuchaczy (w tym ja sam) poczuło się zagubionych. Na szczęście Ben (z pomocą absolwenta matematyki na Cambridge, Willa Critchlowa) wyjaśnił wszystko całkiem klarownie. Ja natomiast spróbuję teraz powtórzyć to co usłyszałem najwierniej jak potrafię.

W powyższym przykładzie zakładamy, że każde angielskie słowo jest powiązane albo z tematem „kot” albo z tematem „pies”, a żadne inne tematy nie istnieją. Żeby zmierzyć powiązanie danego słowa z „psem”, używamy modelu przestrzeni wektorowej, który matematycznie oblicza nam ten związek. Powyższy wykres klarowanie pokazuje nasze założenia. Frazy takie jak „Wielka Stopa” znajdują się idealnie pośrodku między „kotem” i „psem”. Natomiast słowa takie jak „koci” czy „psi” są w oczywisty sposób bliższe któremuś z tematów bardziej niż drugiemu, a natężenie tego związku wyraża kąt wektora (mamy więc wartość, którą można wykorzystać do dalszych obliczeń).

Przy okazji – w modelu przestrzeni wektorowej LDA tematy nie mają swoich etykiet takich jak „pies” czy „kot”, a zamiast nich używa się raczej określeń typu „wektor związany z tematyką psią”.

Niestety, nie jestem w stanie przedstawić graficznie bardziej złożonych przypadków. Wzrost złożoności polegałby tutaj na przeskalowaniu tego prostego modelu do tysięcy lub milionów tematów, z których każdy miałby swój własny wymiar (a każdy kto próbował, zdaje sobie sprawę, że rysowanie w blogonotce więcej niż 3 wymiarów jest raczej trudne). Przy użyciu tego modelu możemy obliczyć podobieństwo między dowolnymi słowami lub grupami słów i wybraną tematyką. Więcej na ten temat możesz dowiedzieć się z artykułu opublikowanego przez Uniwersytet Stanforda (Introduction to Information Retrieval), którego częścią jest sekcja Vector Space Models.

Korelacja wyników zwracanych przez LDA i przez Google.com

10 miesięcy temu Ben (we współpracy z pozostałymi członkami zespołu SEOmoz) stworzył system modelowania tematycznego oparty na uproszczonej wersji LDA. Było to bardzo trudne zadanie, powątpiewamy jednak byśmy zrobili to jako pierwsi w branży SEO (chociaż chyba jako pierwsi udostępniliśmy takie narzędzie publicznie).

Kiedy zaczynaliśmy się przyglądać tematowi LDA, nie wiedzieliśmy jakich danych wejściowych mogą używać modele LDA używane w wyszukiwarkach. Tym bardziej jesteśmy pod wrażeniem wyników badań korelacji:

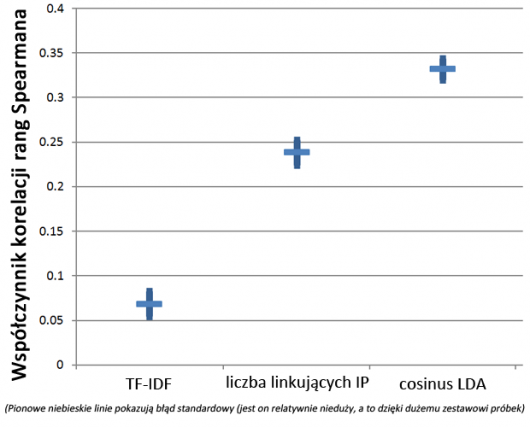

Używając tej samej metody, którą wykorzystaliśmy w naszym raporcie o korelacji między wynikami zwracanymi przez Google i Binga, publikowanego na SMX Advanced (tutaj więcej szczegółów na jego temat), prezentujemy współczynniki korelacji rang Spearmana dla miar znanych pozycjonerom (TF*IDF, liczba linkujących IP) i dla wyników LDA.

- TF*IDF – klasyczna metoda ważenia termów, mierzy użycie słów kluczowych dokładniej niż bardziej prymitywna metoda oparta o pomiar gęstości słów kluczowych. Do obliczenia współczynnika korelacji rang Spearmana wzięliśmy wynik TF*IDF dla treści strony, która pojawiła się w rankingu Google’a.

- liczba linkujących IP – to najwyżej skorelowana z wynikami Google.com samodzielna miara oparta na linkach. Pokazuje liczbę unikalnych numerów IP hostujących witryny zawierające linki do naszego URL-a. Jak już kiedyś pisaliśmy, jeśli uzupełnić ją o miarę taką jak Page Authority (która przy zastosowaniu technik uczenia maszynowego buduje bardziej złożone modele rankingowe), osiągamy nawet wyższe współczynniki korelacji, ale na potrzeby tego porównania zostajemy przy suchych danych o liczbie linków.

- Cosinus LDA (oryg. „LDA cosine”) – to wynik działania naszego testowego narzędzia LDA. Narzędzie mierzy tematyczne „podobieństwo cosinusów” (oryg. „cosine similarity”) między daną podstroną lub fragmentem treści a zapytaniem.

Korelacja między wynikami LDA i rankingami Google’a jest niesamowicie wysoka. Oczywiście nie jest to korelacja zupełna, ale biorąc pod uwagę złożoność algorytmu Google’a i liczbę wpływających nań czynników, nie należało się jej spodziewać. Oczywiście wysoka korelacja między wynikami LDA i rankingami Google’a nie musi oznaczać, że treść on-page mocno wpływa na ranking (mamy zamiar przeprowadzić więcej testów, które pomogą ustalić obecność/nieobecność związku przyczynowego). Być może dobre linki mają tendencję prowadzić akurat do witryn „relewantnych” w rozumieniu narzędzia LDA, być może działa tu jakiś inny, nieznany nam jeszcze aspekt algorytmu Google.

Ponieważ jednak korelacja wyników Google’a z innymi „dobrymi praktykami SEO” (np. słowa kluczowe w [title], statyczne URL-e itd.) jest zdecydowanie niższa, niż dla LDA, a problemy z udowodnieniem związku przyczynowego są równie duże, sądzimy, że wielu dla wielu pozycjonerów ta technika będzie bardzo interesująca.

Testowe narzędzie LDA – jak go używać?

Właśnie udostępniliśmy nasze testowe narzędzie LDA. Wpisz w nie słowo, frazę, fragment tekstu lub całą treść podstrony (podając jej URL), wpisz też zapytanie (słowo kluczowe/frazę, na którą chcesz się pozycjonować), a narzędzie zwróci procentowy wynik określający podobieństwo cosinusowe (100% – pełna zgodność, 0% – żadnego związku).

Używając narzędzia pamiętaj, że:

- narzędzie działa tylko dla języka angielskiego – narzędzie opiera się o anglojęzyczny korpus, wyniki będą zatem sensowne tylko dla fraz i stron anglojęzycznych [od Redakcji: dopóki nie powstanie narzędzie opierające się na polskojęzycznym korpusie, warto zwrócić uwagę na powiązania między wyrazami, które sam Google udostępnia w postaci znajdującej się poniżej wyników wyszukiwania listy „wyszukiwania podobne do” i w postaci „koła informacji” (wonder wheel), choć nie można przeceniać tej techniki, o czym poniżej],

- synonimy, „wyszukiwania podobne do” i koło informacji to może być za mało – modele wektorów termu są bardzo złożonymi reprezentacjami „tematów” i choć wielu pozycjonerów rekomenduje używanie synonimów i „wyszukań podobnych do” w charakterze słów kluczowych na stronie, a kolejni sugerują dużą wagę „treści powiązanej tematycznie”, to jednak nie opracowano żadnych metod mierzenia ich relewancji i badania ich korelacji z SERP-ami. Wyniki podane przez nasze narzędzie oparte są o dużo lepiej zniuansowaną interpretację powiązań między słowami, niż zakłada to klasyczne podejście,

- każde uruchomienie narzędzia daje nieco inne wyniki – żeby zorientować się w poglądach wyborców w danym mieście, ankieter nie przepytuje każdego z osobna, ale wybiera losowo np. 100 osób. Podobnie nasze narzędzie analizuje tylko losową próbkę materiału (analiza całości zajęłaby za dużo czasu). Musisz zatem liczyć się z 1-5% różnicami w wynikach dla tych samych kombinacji treści i zapytania,

- LDA nie daje pełnego obrazu – pamiętaj, że choć korelacja wyników LDA z SERP-ami jest relatywnie wysoka, to wynosi 0,33, nie powinieneś zatem oczekiwać, że wiernie odwzoruje SERP-y (aby tak było, korelacja musiałaby sięgnąć 1,0),

- wyniki są względne – nie zakładaj, że 15% lub 20% to zawsze zły wynik. Jeśli twoi konkurenci z TOP10 w SERP-ach też mają wyniki LDA z przedziału 10-20%, to prawdopodobnie robisz dobrą robotę. Niektóre zapytania po prostu nie zostaną przez algorytm uznane za powiązane z tematem (co może być efektem słabości naszego algorytmu albo nietypowości samego zapytania),

- nasz model tematów nie uwzględnia na razie fraz – póki co nasze narzędzie potrafi obsługiwać tematy będące pojedynczym słowem. Przypuszczamy, że modele używane w wyszukiwarkach przekroczyły już to ograniczenie i obsługują frazy składające się z wielu słów; mamy nadzieję uwzględnić taką możliwość także w naszym narzędziu,

- spamowanie słowami kluczowymi może poprawić twój wynik LDA, ale raczej nie twoją pozycję – próby nadużywania jednego konceptu zwykle dają w SEO opłakane skutki. Choćby nasze narzędzie idealnie odwzorowywało używaną przez Google metodę mierzenia relewancji słowa i tematu, próba upakowania na stronie 50 słów tylko po to, by podwyższyć jej wynik LDA byłaby niemądrym pomysłem. Celem pozycjonera jest dostarczenie ludziom poszukiwanej przez nich, dobrej jakościowo treści, a Google jest wystarczająco mądry, by odróżnić od niej treść śmieciową, napisaną „pod LDA” (nasze narzędzie może tego nie potrafić),

Zalecam, by nie koncentrować się wyłącznie na LDA, a raczej stworzyć tabelkę podobną do poniższej:

(analiza SERP-ów z Google.com dla zapytania „SEO”, z uwzględnieniem wyników z Linkscape i LDA)

Jak wypełnić tę tabelę danymi? Na początku odpal narzędzie Keyword Diffuculty, wyeksportuj uzyskane tam wyniki, a następnie ręcznie dodaj brakujące dane (w przyszłości zamierzamy wbudować tego rodzaju analizę bezpośrednio w narzędzie web app beta).

Kiedy przygotujesz już tabelę i wypełnisz ją danymi, będziesz lepiej wiedział, co decyduje o wysokich pozycjach twoich konkurentów – anchor text, domain authority, a może właśnie coś powiązanego z modelowaniem tematycznym (przy określaniu czego przydatny może być wynik LDA).

Google stosuje bardziej zaawansowane techniki

Chociaż korelacja jest wysoka, a ekscytacja wokół narzędzia w szeregach zespołu SEOmoz.org i członków jego społeczności jest równie wysoka, trzeba powiedzieć, że to nie jest „reverse engineering” algorytmu Google. Prawdopodobnie udało nam się zbudować świetne narzędzie, dzięki któremu będziesz mógł poprawić relewantność swoich stron, a także możliwe będzie ustalenie, czy modelowanie tematyczne jest istotnym czynnikiem rankingowym. Czy rzeczywiście narzędzie potrafi zrobić to wszystko, o tym dopiero się przekonamy.

Jesteśmy podekscytowani nowym narzędziem nie dlatego, że wykorzystuje ono jakąś tajemną formułę (zarówno LDA jak i modele przestrzeni wektorowej zostały wymyślone wieledziesiąt lat temu), ale dlatego, że daje ono możliwość mierzenia parametrów SEO, których wcześniej prawie nie potrafiliśmy mierzyć.

Przy okazji – dziękuję Michaelowi Cottamowi, który zasugerował by przyjrzeć się badaniom nad pLDA robionym przez pracowników Google. Artykułów naukowych autorstwa pracowników zarówno Google jak i Microsoftu (Binga), dotyczących LDA jest zresztą dużo więcej. Wystarczy je przejrzeć, by przekonać się, że korzystanie przez wyszukiwarki z zaawansowanych modeli podobnych do LDA jest rzeczą niemal pewną. Wysoka korelacja i przeprowadzone na narzędziu testy wskazują, że nawet dosyć uproszczona implementacja może wciąż przynosić wartościowe efekty i pomagać w optymalizacji witryn.

Tym, którzy chcieliby wejść w temat bardziej szczegółowo, udostępniamy surowe dane w XLS. Jeśli jesteś zainteresowany tematem, napisz do Bena (Ben małpa SEOmoz kropka org).

Jak wyjaśnić to szefowi/klientowi?

Najprościej będzie posłużyć się analogią taką jak ta:

Jeśli chcemy pozycjonować się na frazę „the rolling stones”, to powinniśmy używać fraz takich jak „Mick Jagger”, „Keith Richards” i „daty koncertów”. Nie jest za to najlepszym pomysłem używanie słów takich jak „rubiny”, „szmaragdy”, „kamienie szlachetne”, bo w połączeniu z dosłownym znaczeniem nazwy grupy „toczące się kamienie” mogłoby to sugerować wyszukiwarce (i internautom), że strona dotyczy kamieni szlachetnych, a nie rockbandu.

Narzędzie pozwala z niezłym przybliżeniem określić jak radzimy sobie z doborem słów na stronie w porównaniu do naszej konkurencji (wystarczy podać narzędziu fragment tekstu). Narzędzie pozwoli też zauważyć błędy takie jak brak wzmianki o Keithie Richardsie na witrynie o Rolling Stonesach.

Jesteśmy bardzo ciekawi, jak w praktyce sprawdzać się będzie nasze narzędzie. Kilka osób pisało już do nas, donosząc, że po uwzględnieniu wniosków płynących z wyniku LDA, ich witryny zanotowały znaczny skok w wynikach wyszukiwania. Nie świadczy to oczywiście w żaden bezpośredni sposób o narzędziu lub użytym algorytmie, ale daje nadzieję na świetne wyniki.

PS. Planujemy uzupełnić to narzędzie o umiejętność rekomendowania słów, które powinniśmy dodać lub wyrzucić, by poprawić wynik witryny.

[źródło: Latent Dirichlet Allocation (LDA) and Google’s Rankings are Remarkably Well Correlated]

[aktualizacja 17 września 2010, redakcja SprawnyMarketing.pl]: przedstawione w tym tekście wyniki korelacji LDA z rankingiem Google okazały się być obarczone poważnym błędem:

Kiedy Ben Hendricson z ekipy SEOmoz.org przedstawiał dwa tygodnie temu wyniki eksperymentów z narzędziem LDA, wydawało się, że mamy do czynienia niemal z rewolucją. Narzędzie bada tematyczną zgodność treści strony ze słowem kluczowym, próbując odtworzyć metody używane w tym celu przez Google. Eksperyment Hendricsona wykazał niespotykaną dotąd korelację między rankingiem układanym narzędziem LDA a prawdziwym rankingiem z google.com. Branża SEO nie tylko miała dostać do ręki świetne narzędzie pozycjonerskie, ale także pewność, że SEO copywriting jest znacznie istotniejszym czynnikiem rankingowym, niż dotychczas przypuszczano. Przedwczoraj Hendricson przyznał jednak, że pomylił się w obliczeniach, a korelacja wynosi nie 0,32, ale 0,17. Co z tego wynika?

Że <strong>LDA nie odzwierciedla rankingu Google lepiej niż inne samodzielne metody</strong> (jak np. zliczanie unikalnych IP witryn zawierających linki do pozycjonowanej witryny, czy metoda TF*IDF. Po uwzględnieniu poprawnego współczynnika korelacji, trzeba powiedzieć, że <strong>LDA jest co najwyżej najlepszą z dostępnych metod odzwierciedlających ranking na podstawie treści witryny</strong>, jest za to słabsza od metod opartych o linki:

<img class=”alignnone size-large wp-image-4748″ title=”lda_tf_idf_chart_fixed_2″ src=”https://sprawnymarketing.pl/wp-content/uploads/2010/09/lda_tf_idf_chart_fixed_2-530×326.png” alt=”” width=”530″ height=”326″ />

Powyżej <strong>zaktualizowany wykres zestawiający współczynniki korelacji</strong> różnych metod.

Ben Hendricson deklaruje, że „modelowanie tematyczne jest wciąż obiecującym terenem, chociaż nie tak dużym jak wcześniej sądziłem”, a także „korelacja na poziomie 0,17 jest wciąż ekscytująca, chociaż nie tak ekscytująca, jak 0,32”. Wyjaśnia także obszernie jak doszło do pomyłki i <strong>kilkukrotnie przeprasza czytelników za prowadzenie w błąd</strong>.

Z późniejszego dopisku Bena wynika, że <strong>być może znaleziony został kolejny błąd sztucznie zawyżający korelację</strong>, więc może ona okazać się jeszcze niższa. Ben obiecuje sprawdzić to dogłębnie i opisać.

Osobiście, choć nieco zawiedziony, mogę tylko wyrazić szacunek dla ekipy SEOmoz.org i Bena Hendricsona za dzielne wzięcie na siebie odpowiedzialności za błąd i jego samodzielne ujawnienie.

12 min

12 min

Warszawa

Warszawa

Przypominamy, że wielkimi krokami zbliża się konferencja I ♥ Marketing & Technology, która odbędzie się już 22–24 października 2024 roku oraz organizowane przez nas 33 szkolenia z zakresu marketingu.

Jeśli chcesz być zawsze na bieżąco, zamów prenumeratę magazynu sprawny.marketing!

"ich praktyczne w pozycjonowaniu zastosowania" – a bardziej po polsku ;)

Ciekawe narzędzie, niebawem postaram się przetestować. Choć sama złożoność artykułu mogła wstępnie powalić, to można wysnuć z niego wiele przemyśleń.

@ "ich praktyczne w pozycjonowaniu zastosowania" – a bardziej po polsku ;)

To jest 100% po polsku :-). Zasady polskiej składni są dosyć luźne i generalnie trudno popełnić błąd. W praktyce, ostatnie (i pierwsze) słowo jest tym, na które chce się zwrócić uwagę czytelnika. Gdyby zdanie brzmiało "(…) i ich praktyczne zastosowania w pozycjonowaniu" (a brzmiało tak przed ostatecznym sczytaniem tekstu, ale zmodyfikowałem je do obecnej postaci), to na pierwszy plan wybiłoby sie "w pozycjonowaniu", czyli rzecz oczywista, umieszczona tylko dla pełnej jasności.

Chyba, że chodziło ci o jakiś inny błąd :-).

Osobiście bardziej martwię się tłumaczeniem terminów matematycznych, nie wszystkie zdają się mieć (znajdowalne w internecie) polskie odpowiedniki (np. "cosine similarity"), więc tłumaczyłem je "na czuja". Oby czytelnie, chociaż z drugiej strony, przeciętny pozycjoner ma wyciągnąć z tego tekstu dwie główne rzeczy: 1) dobór słów kluczowych jest prawdopodobnie ważniejszy, niż dotąd sądzono, 2) pojawiają się narzędzia, które wykonają za nas wszystkie obliczenia i warto z nich skorzystać.

pierwszy raz cieszę się z przetłumaczenia na sprawnym artykułu z seomoza bo jak kilka dni temu czytałem ten artykuł w oryginale to niewiele zrozumialem :D

Jakoś nie przemawia do mnie szyk przestawny, niczym z Yody. Ale rozumiem celowość zabiegu ;)

Inverse Document Frequency to nie jest odwrotna częstość w dokumencie, tylko we wszystkich dokumentach znajdujących się w indeksie (im więcej stron zawiera słowo, tym mniejsze znaczenie tego słowa przy wyszukiwaniu).

@ Inverse Document Frequency – masz rację, poprawne polskie tłumaczenie tego terminu brzmi "odwrotna częstość w dokumentach".

i jak się właśnie dowiedzielismy z seomoza w obliczeniach korelacji LDA wdał się "mały" błąd przez co całość nie wygląda już tak cudownie

Ktoś chyba za bardzo chciał zabłysnąć na konferencji i mu się przez przypadek wartości obliczeń podwoiły :D

Tak czy inaczej to otoczenie decyduje, a nie jednostka o jej wlasnej lub nabytej tozsamosci.

To zupelnie jak w zyciu i nareszcie internet zaczal galopowac swiadomie w ta/ te strone.

Bo spoleczenstwo to wszystko i to przydatnosc i nieposzlakowana przeszlosc pozwala udzielic zaufania.

Stronę z dużą ilością, unikatowego i tematycznego tekstu, który został napisany przez (seo)copywritera pozycjonuje się łatwiej, niż stronę, której optymalizacja tekstowa opiera się na dodaniu słów kluczowych. Łatwiej, bo zapotrzebowania na linki będzie mniejsze. Szkoda że większość klientów/właścicieli stron nie może tego zrozumieć.

Dobry artykuł – moim zdaniem za mało uwagi poświęca się podstawowym metodom, z których bezpośrednio wywodzą się algorytmy wyszukiwarek: Information Retrival (bardzo tutaj polecam wspomnianą publikację: Introduction to Information Retrieval). Bez statycznej analizy ciężko byłoby wyszukiwarkom efektywnie odnaleźć relewantne dokumenty (szeregowanie to już inna sprawa).

Zastanawiam się czemu ich narzędzie nie obsługuje kilkuwyrazowych fraz – VSM normalnie je obsługuje!

BTW: do "cosine similarity" pasuje termin metryka kosinusowa, ale i to niewiele zrozumiały termin :)

Thank you for the great writeup. The item in reality was once the amusement bank account them. Seem complicated in order to a lot more helped bring reasonable by you! Nevertheless, exactly how should we keep up some sort of communications?