Nowości z reklamy Google za okres wrzesień-grudzień 2020

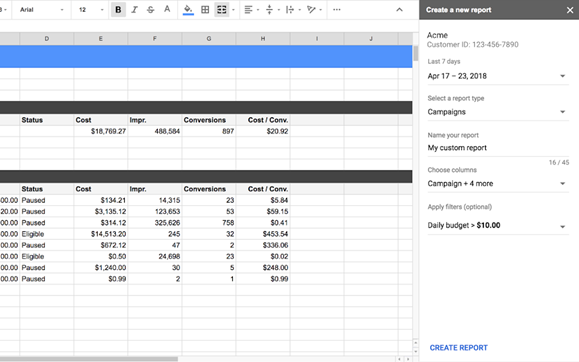

1. Google Ads + Arkusze Google

W Arkuszach Google pojawi się możliwość importu danych z Google Ads. Funkcjonalność będzie w sekcji „Dodatki”. Na razie będzie dostępna tylko w języku angielskim.

2. Nowy cel dla kampanii Smart PLA: nowi klienci

W kampaniach inteligentnych PLA pojawi się możliwość optymalizacji pod zakupy zrealizowane tylko przez nowych klientów. Funkcjonalność ta zapowiada się dosyć ciekawie i z pewnością chętnie sięgną po nią marketerzy. Do zrealizowania nowej opcji targetowania będziesz potrzebował określenia sposobu identyfikacji nowych klientów. Będziesz mógł wybrać spośród tzw. wykrywania przez Google’a, przesłać listy klientów oraz używać tagów do śledzenia nowych klientów.

3. Nowy Google Analytics i nowe integracje z Google Ads

Pojawi się możliwość mierzenia użytkowników również pomiędzy urządzeniami. Dokładniej – chodzi o to, że jeżeli dany użytkownik znalazł się na Twojej stronie, a potem dokonał zakupu poprzez aplikację, to nareszcie będziesz w stanie to zmierzyć. Dodatkowo mają być dodane informacje o zaangażowaniu z YouTube’a.

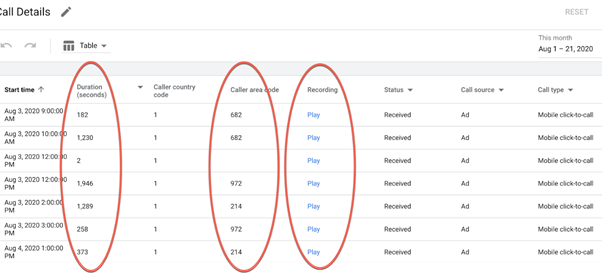

4. Google Ads będzie nagrywał Twoje rozmowy

Funkcjonalność działa na razie tylko dla mających numer ze Stanów Zjednoczonych. Na polski odpowiednik pewnie będziesz musiał trochę poczekać, ale zapowiada się całkiem ciekawie. Dzięki tej funkcjonalności poznasz takie informacje, jak czas trwania połączenia, jaki był numer kierunkowy, a także będziesz mógł odsłuchać rozmowę.

5. Kampanie Smart PLA na Święta

Google postanowił sprawić Ci świąteczny prezent. Co dokładnie dostaniesz? Otóż niezły pakiet danych. Inteligentne kampanie PLA mają otrzymać większą liczbę dostępnych raportów, między innymi symulatory wartości docelowych oraz budżetów.

Nowości z reklamy Google za okres kwiecień-sierpień 2020

1. Opóźnienia w Google Ads z powodu COVID-19

Spora część z Was na pewno zauważyła na swoich kontach ten komunikat, ale warto jeszcze raz przypomnieć, że z powodu pandemii obsługa przez support Google jest opóźniona. Wynika to z powodu mniejszej liczby osób pracujących w biurach Google. Trzeba o tym pamiętać zwłaszcza podczas uruchamiania kampanii GDN – zatwierdzanie reklam może się wydłużyć. Dlatego, jeżeli masz taką możliwość, warto zaplanować kampanię kilka dni wcześniej.

2. Pomoc dla małych i średnich firm od Google’a

Google wyciąga pomocną dłoń w kryzysie. Wsparcie, jakie oferuje, ma wynieść 800 mln dolarów. Firmy z sektora małych i średnich przedsiębiorstw będą mogły skorzystać z kredytów na reklamy w Google Ads – na ten cel Google przeznaczy 340 mln dolarów. Jest jeden warunek: trzeba mieć aktywne konto w ciągu ostatniego roku! Powiadomienia o pomocy powinny pojawiać się na kontach reklamowych.

3. Łatwiejsze odwoływanie się od decyzji Google’a

Każdy z nas chociaż raz w życiu spotkał się z odrzuconą reklamą przez Google Ads. Do tej pory taką reklamę trzeba było zmodyfikować lub skontaktować się z zespołem pomocy, aby została ponownie zweryfikowana. Pochłaniało to trochę czasu. Na szczęście niedługo ma się pojawić możliwość odwołania od decyzji Google’a bezpośrednio w narzędziu Menedżer zasad. Miejmy nadzieję, że przyspieszy to cały proces.

4. Kampanie Discovery dostępne dla wszystkich

Discovery Ads było dostępne jako beta – teraz jest już dla wszystkich. Kampanie tego typu pozwalają dotrzeć do odbiorców zgromadzonych w ramach sieci Google. Targetowanie odbywa się na podstawie sygnałów, które generują użytkownicy, więc tak jak w przypadku kampanii Smart, będziemy mogli zastosować niewiele modyfikacji.

Kampanie te wyświetlają się na YouTubie, Gmailu oraz na karcie „Discovery” w Google. Mogłoby się wydawać, że to kolejny format typowo wizerunkowy, który absolutnie nie będzie konwertował, ale tutaj niespodzianka: pojawiają się konwersje z Discovery Ads!

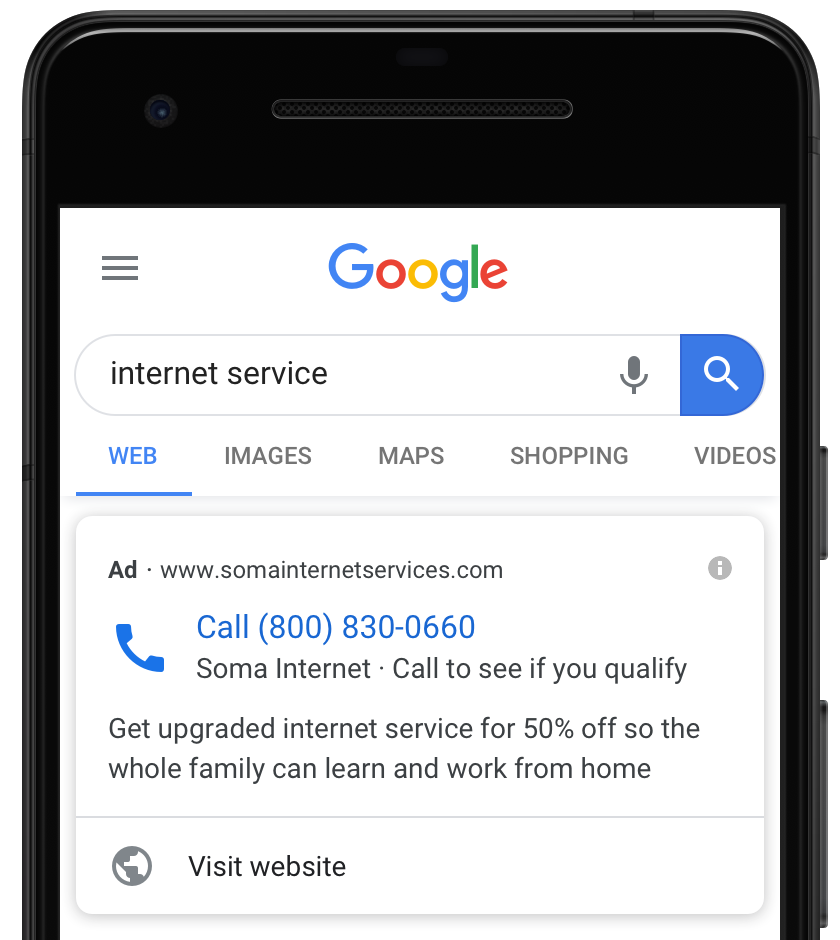

5. „Tylko połączenie” teraz z linkiem

Reklamy „tylko połączenia” zyskują możliwość dodania linku do witryny. Ma to pozwolić na większą elastyczność w kontaktach klientów z Twoją firmą.

Nowości z reklamy Google za okres styczeń-marzec 2020

1. Żegnamy wyświetlanie przyśpieszone

Jakiś czas temu pożegnaliśmy wyświetlanie przyśpieszone w przypadku kampanii na wyszukiwarkę. Teraz zmiana ta dotyczy również kampanii display oraz wideo. Czym było wyświetlanie przyśpieszone? Jeżeli reklama była możliwa do wyświetlenia (spełniała wszystkie kryteria), to system emitował reklamę aż do wyczerpania budżetu dziennego.

Był to dobry sposób na zwiększenie wydatków – liczby kliknięć z kampanii, co czasami przynosiło całkiem przyzwoite efekty, jak np. podczas gorącego sezonu na dane produkty, kiedy zależało nam na maksymalizacji ruchu.

2. Rozszerzenia wiadomości znikają z Google Ads

Rozszerzenia wiadomości przestaną się wyświetlać od lutego 2020 roku. Czy to istotna zmiana? Raczej nie – rozszerzenie rzadko kiedy było wykorzystywane. Dodatkowo przekierowanie użytkowników do komunikacji poprzez SMS-y średnio się sprawdzało.

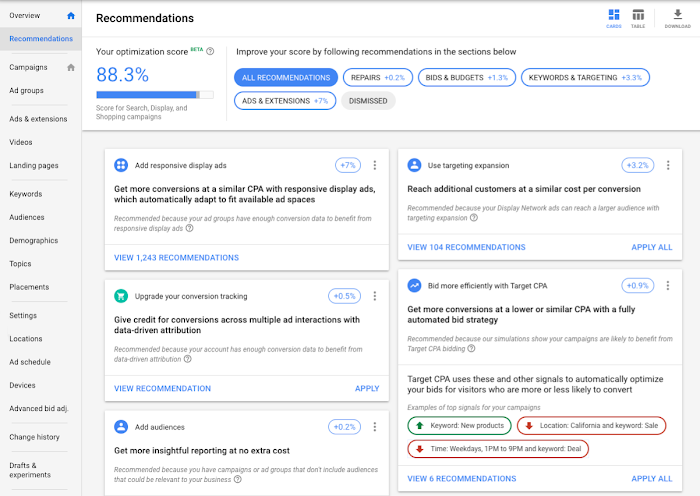

3. Jak działają optymalizatory Google – część druga

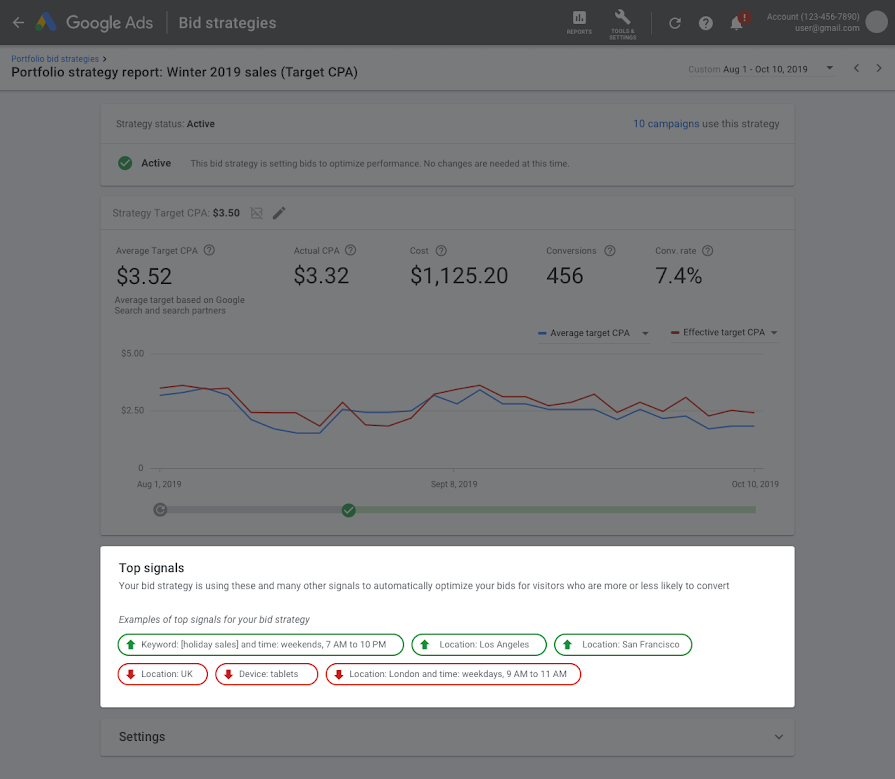

W poprzednim numerze opublikowana została informacja o TOP Signals od Google. Pisałem o tym, jakie czynniki wpływały na optymalizację kampanii (np. słowo, lokalizacja, urządzenie). Teraz TOP Signals będzie dostępne również dla kampanii w sieciach reklamowych – GDN.

rys.1 TOP Signals dla kampanii w sieciach reklamowych – GDN

4. Śledzenie równoległe również dla kampanii wideo

O co chodzi z tym śledzeniem równoległym? Gdy użytkownik klika w naszą reklamę, zostaje przeniesiony do strony docelowej – równocześnie wszystkie kody śledzące są uruchamiane w tle. Śledzenie równoległe zostało wprowadzone przez Google’a już dawno, bo w 2018 roku, jednak dotyczyło ono kampanii Search, PLA oraz GDN. Od 31 marca 2020 roku będzie obowiązkowe również dla kampanii wideo.

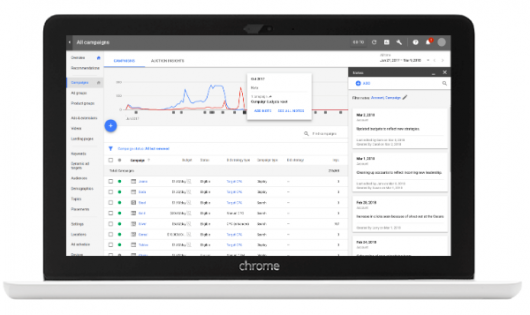

5. Wyjaśnienia dotyczące natężenia ruchu z kampanii

Zastawiasz się czasem, dlaczego Twoje kampanie przekraczają ustalony budżet dzienny? Może to być spowodowane wzrostem zainteresowania na dane frazy. Niebawem Google Ads udostępni dane dotyczące największych zmian na koncie w określonym czasie. Będziemy mogli dowiedzieć się m.in. tego, które frazy zyskały na popularności – na przykład w porównaniu miesięcznym. Dane będą dostępne tylko dla kampanii na wyszukiwarkę z samodzielnym lub ulepszonym ustalaniem stawek.

Nowości z reklamy Google za okres październik-grudzień 2019

1. Leady wprost z wyszukiwarki. Nowa beta w Google Ads

Na wielu kontach pojawiła się możliwość stworzenia nowego rozszerzenia – Lead Form Extensions. Rozszerzenie umożliwia pozyskiwanie danych kontaktowych bezpośrednio z reklamy w wyszukiwarce. Dane kontaktowe będziesz mógł pobierać prosto z panelu Google Ads.

2. Nowy Edytor Google Ads

W nowym edytorze znaleźć można takie funkcje, jak m.in.:

- obsługa nowych typów kampanii,

- udostępnianie listy wykluczających słów kluczowych (również pomiędzy kontami!),

- samoczynne wykrywanie błędów w edytorze (nie trzeba już przeszukiwać wszystkich elementów),

- skrócony panel do edycji elementów.

3. Jak działają optymalizatory Google? Wiemy trochę więcej: TOP Signals od Google’a

Google udostępnił informacje o tym, jakie zmienne wpływają na zmiany stawek w przypadku strategii ich ustalania. Są to: „Docelowy CPA” oraz „Maksymalizuj ilość konwersji”. Informacje te udostępniane są tylko z kampanii w wyszukiwarce. W końcu możesz się dowiedzieć, jakie dokładnie dane są brane pod uwagę.

4. Bug w zliczaniu konwersji

Polecam sprawdzić, czy ten mały bug nie pomieszał Ci danych z konta. Może się okazać, że ściągnięte dane na temat konwersji nie będą prawidłowe.

5. Średnia pozycja wyników wyszukiwania w wyszukiwarce znika z panelu

„Średnia pozycja” zostanie zastąpiona wskaźnikami: „Wyświetlenia u góry strony” oraz „Najwyższa pozycja na stronie”. Szkoda, ponieważ wskaźnik ten pomagał przy optymalizacji kosztu konwersji i ułatwiał znalezienie pozycji reklam, które były najbardziej opłacalne dla Twojego biznesu. Na razie pozostaje nam testowanie nowych wskaźników podanych przez Google.

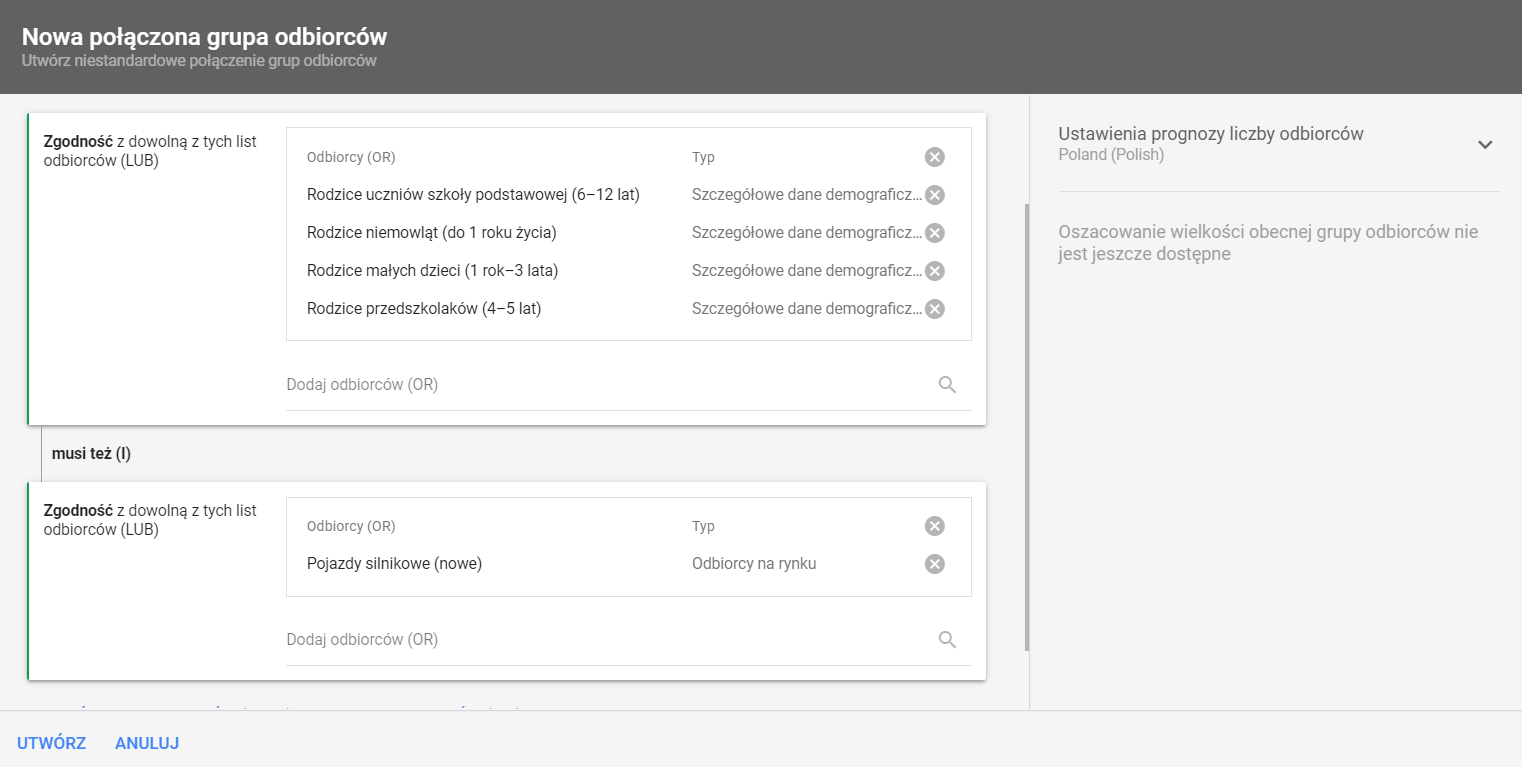

6. Mieszanie list odbiorców

Pojawi się opcja łączenia list odbiorców w searchu, czyli będziesz mieć możliwość połączenia użytkowników z różnychlist i stworzenia części wspólnej. Na przykład kampanie z searcha możesz wyświetlać użytkownikom, którzy szukają nowego samochodu oraz są rodzicami dziecka w wieku do 12 lat.

Nowości z reklamy Google za okres lipiec-wrzesień 2019

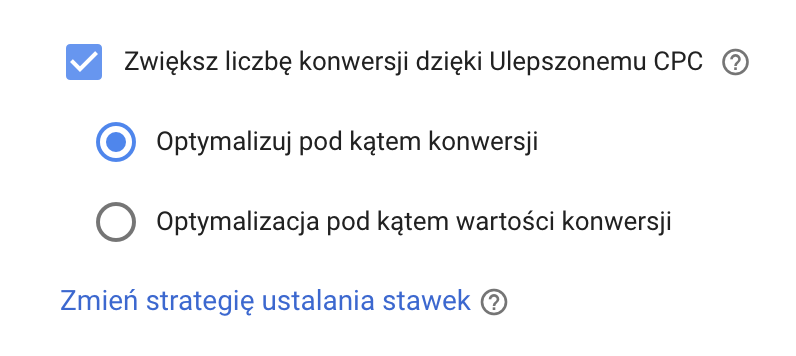

1. Zmiany w ulepszonym CPC

Pojawiła się możliwość wyboru ustawień ulepszonego CPC. Dzięki tej zmianie możesz wybrać, czy chcesz, aby system optymalizował stawki pod kątem liczby konwersji czy wartości konwersji. Przy wyborze pierwszej opcji optymalizacji będziesz mógł skupić się na generowaniu dużej ilości sprzedaży. Natomiast w drugim przypadku – na mniejszej liczbie konwersji, ale o wyższej wartości (np. wyższa wartość średniego koszyka).

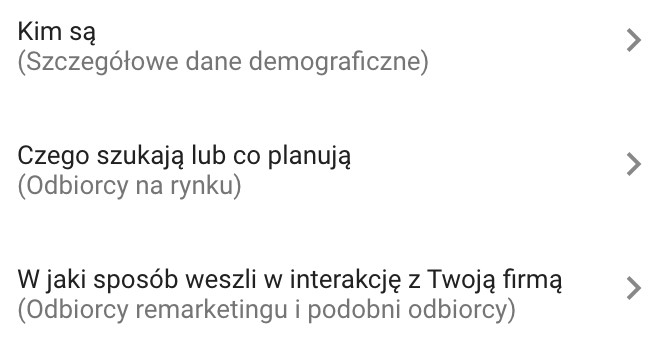

2. Kierowanie reklam na odbiorców w… sieci wyszukiwania?!

Opcja pojawiła się w panelu już jakiś czas temu, natomiast przeszła bez echa. Warto jednak przypomnieć, jakie daje możliwości. W kampaniach na wyszukiwarkę w zakładce „Odbiorcy” możesz znaleźć następujące targetowanie:

Tak jak w RLSA (remarketing w wyszukiwarce), dostępne są dwie opcje:

- kierowanie – kampania wyświetla się tylko użytkownikom zawartym na listach odbiorców,

- obserwacja – kampania wyświetla się wszystkim użytkownikom.

Pojawia się możliwość modyfikacji stawki oraz obserwacji zachowań użytkowników na danych listach. Dlaczego warto przetestować te opcje? Dzięki nim masz możliwość obserwacji zachowań użytkowników, którzy zostali przypisani do określonych kategorii zainteresowań. Dodatkowo pojawia się możliwość modyfikacji stawek. Dzięki wykorzystaniu tych opcji możesz skierować swoje kampanie na użytkowników, którzy chcą podjąć decyzję o zakupie dokładnie w tym momencie. Conversion rate u takich odbiorców może być nawet dwa razy wyższe. Wow!

3. Reklamy Masthead na Youtubie kierowanie na TV

Brzmi to naprawdę niesamowicie, ale już niedługo będzie można kupować reklamy typu Masthead z kierowaniem na TV. Reklamy będą rozliczane w modelu CPM. Dodatkowo pojawi się również możliwość targetowania na konkretnych odbiorców.

4. Przyśpieszone reklamy znikają z panelu

Zgodnie z informacją z Supportu Google od 7 października z panelu zniknie możliwość ustawienia metody wyświetlania reklam jako „przyspieszone”. Od tego terminu kampanie będą sukcesywnie przełączane na wyświetlanie standardowe.

5. Google wprowadza reklamy w 3D oraz rozszerzonej rzeczywistości

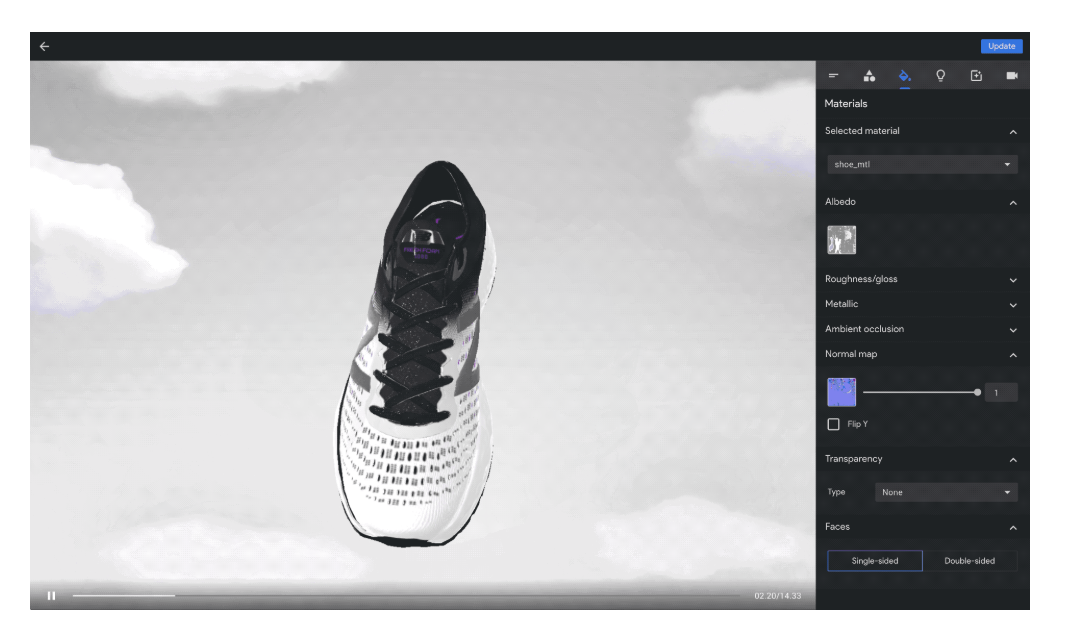

Pierwsza opcja dostępna będzie w Display&Video 360 i umożliwi prezentację produktów w pełnym wymiarze. Jest to świetne rozwiązanie, m.in. dla branż odzieżowych. Użytkownik zainteresowany produktem (np. butami) będzie mógł obejrzeć go z każdej strony:

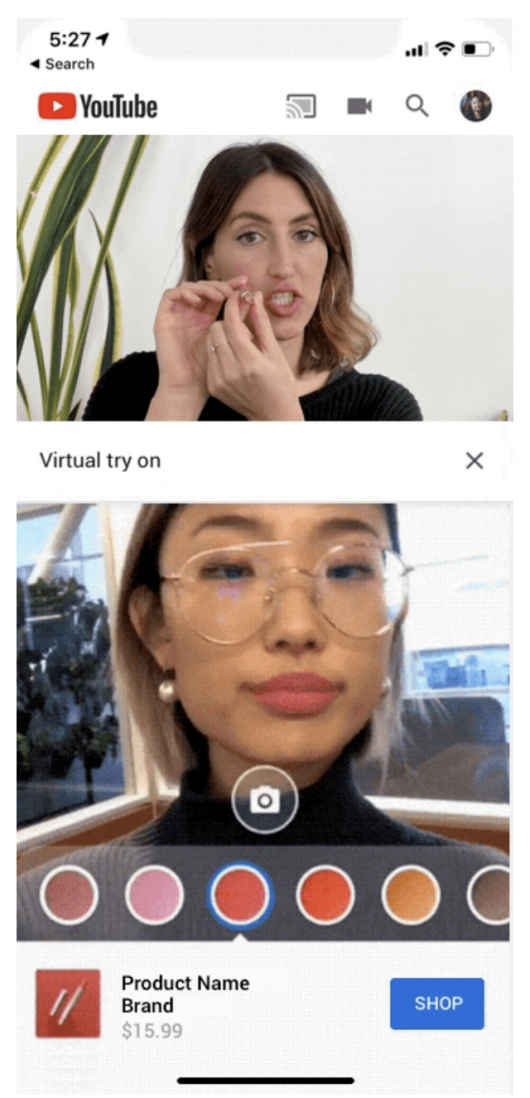

Druga opcja dotycząca rozszerzonej rzeczywistości będzie dostępna w YouTubie i pozwoli użytkownikom na przetestowanie produktów na „sobie”. Będzie można sprawdzić np. czy wybrany kolor pomadki, który chcesz kupić, rzeczywiście Ci pasuje 😊.

Nowości z reklamy w Google za okres kwiecień-czerwiec 2019

1. Zmiana w reklamach/nowe typy reklam

- Discovery Ads – reklamy tworzone z panelu Google Ads z przesłanych przez nas zasobów, mające na celu dotarcie do użytkowników, którzy są na wczesnym etapie lejka zakupowego.

- Gallery Ads – reklamy wyświetlane w wyszukiwarce na samej górze. Pojawi się możliwość scrollowania. Reklamy tego typu będę konkurowały o miejsce z reklamami tekstowymi w wyszukiwarce.

- Shopping Ads Showcase – możliwość rozszerzenia prezentacji produktu w PLA o dodatkowe grafiki danego produktu.

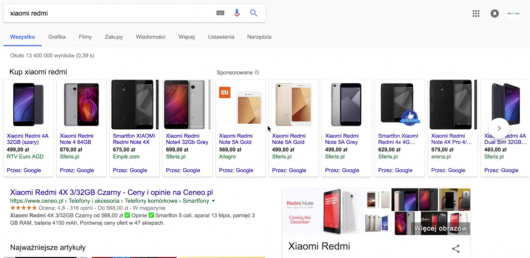

2. Zmiany w Google Shopping

Pojawi się możliwość zakupu bezpośrednio z Google Shopping bezkonieczności przechodzenia do strony sklepu. Dodatkowo reklamy PLA będą się wyświetlały również na YouTube oraz Google Images.

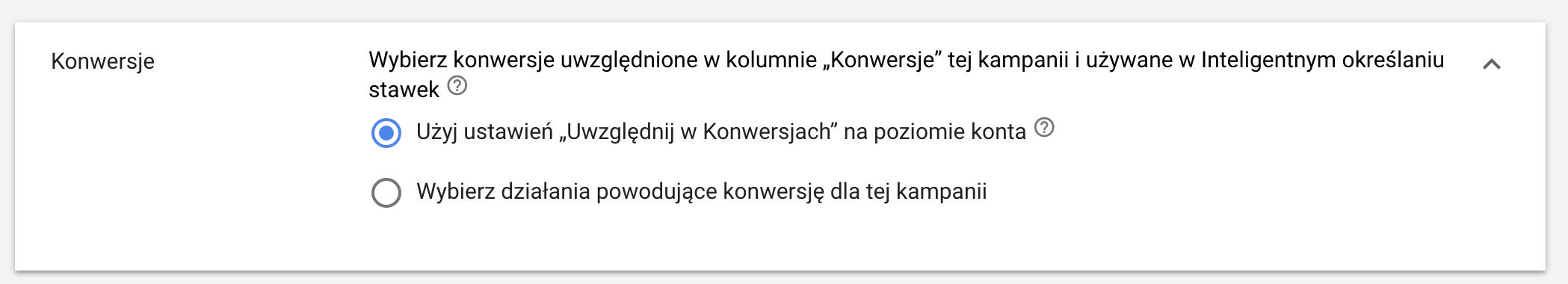

3. Możliwość wyboru optymalizacji pod dane konwersje

Pojawi się możliwość wyboru, pod jakie dokładnie konwersje kampania ma być optymalizowana (na niektórych kontach ta opcja jest już dostępna).

Będzie to duże ułatwienie dla osób, które budują lejek konwersji w oparciu o Google Ads. Dotychczas można było uzyskać podobną funkcję, dzieląc nasze działania na kilka kont oraz ustawiając odpowiednie konwersje w opcji „uwzględnij w konwersjach”. Poprzez ten wybór system wiedział dokładnie, na których konwersjach najbardziej nam zależy.

Dodatkowo warto jeszcze zwrócić uwagę na kolejne zmiany, o których Google „zapomniał” poinformować na evencie.

4. Automatyczne propozycje reklam od Google’a

Przy tworzeniu elastycznych reklam w wyszukiwarce (RSA) możesz się spotkać z tym, że Google Ads automatycznie będzie proponował teksty prosto z adresu URL, na który ustawiona jest reklama. Zdecydowanie przyśpieszy to proces tworzenia wielu tekstów reklamowych, ponieważ niektóre propozycje są bardzo trafne.

5. Atrybucja cross-device

Kojarzysz komunikat w panelu, że dane z 1 maja 2019 r. mogą być nie do końca zgodne z prawdą? Może to wynikać z tego, że od 1 maja wszystkie dane na temat konwersji (wszystkie konwersje, koszt konwersji oraz last click) będą zawierały również dane uwzględniające konwersje pomiędzy urządzeniami (cross-device).

6. Google Ads przechodzi na first price auction

Od końca kwietnia ruch w Google Ads – Ad Exchange (zasoby dostępne m.in. w GDN) będzie stopniowo przenoszony z second price auction do first price auction. Co to oznacza? Część zasobów reklamowych była dostępna w dwóch modelach aukcyjnych first price auction (dostępne w Display & Video 360 i innych platformach DSP – programmatic) oraz w modelu second price auction (zasoby dostępne m.in. w dobrze nam znanym panelu Google Ads). W second price zawsze płaciliśmy jeden cent więcej niż druga najwyższa oferta i w tej cenie kupowaliśmy odsłonę/kliknięcie. W first price auction płacimy tyle, ile zadeklarowaliśmy, a stawka konkurenta nie ma na to wpływu. Zmiana ma być wprowadzona do końca lipca i w każdym kolejnym miesiącu coraz większy procent ruchu ma być przenoszony na first price auction. Sporo zmian, więc nie ma mowy o nudzie w Google Ads 😉.

Nowości z reklamy w Google za okres styczeń-marzec 2019

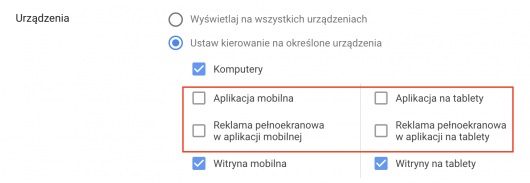

1. Wykluczanie aplikacji mobilnych

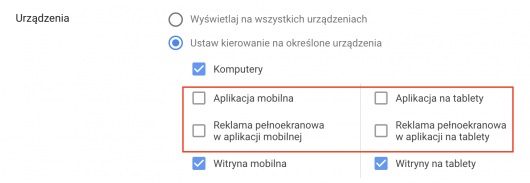

Google ostatnio dużo zmienia w tym obszarze. Początkowo wystarczyło wykluczyć magiczną witrynę adsenseformobileapps.com, potem pojawiła się możliwość odhaczenia aplikacji mobilnych w ustawieniach kampanii (o czym pisałam w ostatnich newsach). Natomiast niedawno zniknęła ta opcja i pojawiło się nowe miejsce gdzie należy to robić.

Najłatwiej będzie takiej zmiany dokonać przed AdWords Editora – Zarządzanie > Słowa kluczowe i kierowanie > Kategorie aplikacji mobilnych, wykluczanie. W tym miejscu można jednym kliknięciem dodać wszystkie kategorie apek do wykluczeń.

2. Kampanie video kierowanie na telewizory

Już od jakiegoś czasu w raportach urządzeń pojawiły się telewizory. Można też uzyskać informację o tym na jakim kanale YT została wyświetlona reklama video lub GDN poprzez dodanie segmentu “urządzenie” w raporcie Miejsca docelowe > Gdzie wyświetlają się reklamy. Warto wziąć pod uwagę to urządzenie, wyświetleń jest tam coraz więcej, a stawki póki co są niskie i baardzo konkurencyjne w porównaniu z tradycyjną telewizją.

3. CPM for True View

W kampaniach video pojawiła się ostatnio nowa opcja rozliczania się za wyświetlenia – CPM. Długo musieliśmy czekać aby w tym typie kampanii video móc przeprowadzić kampanie brandową rozliczaną za 1000 wyświetleń. Ustawienie strategii ustalania stawek CPM dostępne jest tylko podczas ustawiania nowej kampanii.

4. Audience expansion tool

Można teraz ustawić jak szeroko chcemy docierać poza naszą docelową grupą, używając suwaka w ustawieniach rozszerzenia targetowania. Podczas przesuwania suwaka pokazuję się informacja jaki dodatkowy zasięg kampania może wygenerować przy takich ustawieniach.

5. Początek bloków reklamowych na YT?

Już niedługo przed materiałem który chcemy obejrzeć będą mogły wyświetlić się dwie reklamy pod rząd. Google argumentuje to tym, że dzięki podwójnym reklamą nie będzie tyle przerw w trakcie oglądania video, co wg badań często zniechęca użytkowników do obejrzenia całego materiału. Pytanie czy nasze reklamy będą równie zapamiętywalne, gdy pojawią się w bloku reklamowym i czy Google zaprzestanie na dwóch reklamach przed video?

Nowości z Google Ads za okres październik-grudzień 2018

1. Konwersje po obejrzeniu teraz w kolumnie „wszystkie konwersje”

Chcąc wyłączyć wspólne raportowanie wszystkich konwersji, należy wejść na Narzędzia > Konwersje > Ustawienia i odznaczyć pole „W kolumnach Wszystkie konw. uwzględnij konwersje po obejrzeniu reklam w sieci reklamowej i reklam wideo”.

Do śledzenia konwersji po obejrzeniu konieczny jest kod śledzenia Google Ads.

2. Niestandardowi odbiorcy w YouTube

Nowa metoda kierowania reklam polegająca na docieraniu do osób wpisujących określone frazy w wyszukiwarce Google i YouTube – ta nowość jest od niedawna dostępna w kampaniach wideo na YouTube.

Wykorzystanie tego rodzaju kierowania jest idealne dla reklamodawców, którzy chcą zwiększyć ruch pochodzący z określonych słów kluczowych oraz tych, którzy chcą być obecni na YouTube, ale poza brandingiem jest dla nich ważny również aspekt efektywności kampanii.

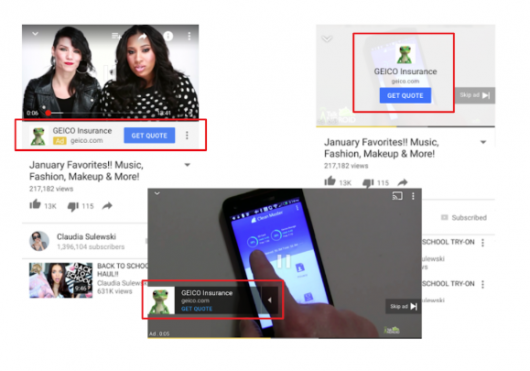

3. TrueView for Action

TrueView for Action jest to klasyczna reklama wideo, do której możemy dodać w końcowej klatce planszę z przyciskiem nakłaniającym do działania. Dodatkowo wyświetlany jest baner towarzyszący, który zostaje później podczas oglądania materiału wideo wyświetlony po reklamie. Reklamy TrueView zachęcające do działania mogą zwiększyć zaangażowanie widzów i zachęcić ich do podjęcia działań po odtworzeniu filmu. Ten typ kampanii możesz utworzyć, gdy wybierzesz cele „Potencjalni klienci” lub „Ruch w witrynie”.

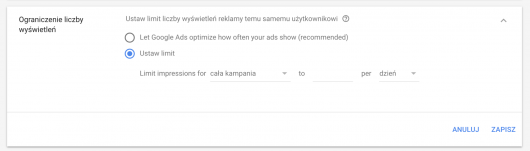

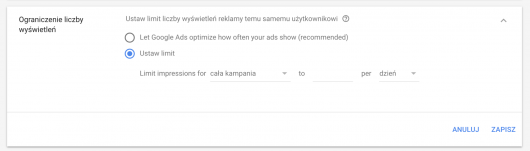

4. Zmiany w ustawieniach cappingu

Nowością, jaka pojawiła się w ograniczeniu liczby wyświetleń reklam, jest możliwość zaznaczenia opcji, w której pozwalamy na to, aby Google sam zadecydował, jak często powinna wyświetlać się reklama. Używając tej opcji warto później skontrolować faktyczną liczbę wyświetleń w kolumnie „Średnia częstotliwość wyświetleń przypadających na plik cookie”.

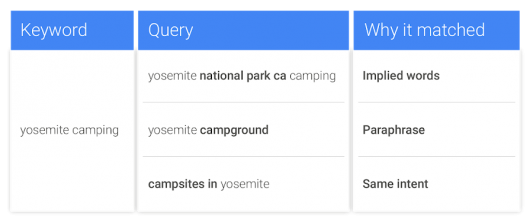

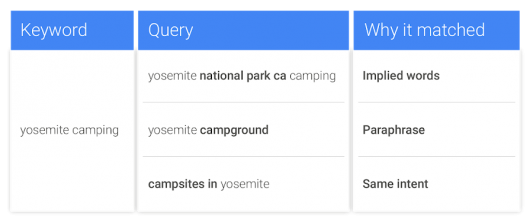

5. Dopasowanie ścisłe jest teraz szerszym dopasowaniem

Google wprowadził zmianę w dopasowaniu ścisłym słów kluczowych (exact match). Wcześniej po ustawieniu słowa kluczowego [yosemite camping] w dopasowaniu ścisłym wyświetlenie reklamy następowało tylko i wyłącznie po wpisaniu dokładnie takiej frazy (plus ewentualne literówki). Po zmianie algorytm wykrywa, czy wpisane słowo ma taką samą intencję, jest parafrazą lub czy występuje dodatkowy element między słowami..

6. Zmiany w wykluczeniach urządzeń mobilnych

Od września br. nie są już dostępne wykluczenia aplikacji adsenseformobileapps.com oraz wykluczenie niepełnoekranowej aplikacji mobilnej GMob. Teraz, żeby wykluczyć aplikacje mobilne, należy przejść w ustawieniach do sekcji urządzenia i odhaczyć aplikacje i reklamy pełnoekranowe w aplikacjach mobilnych.

7. Intelligent Tracking Prevention – śledzenie ruchu z Safari

Apple wprowadziło rok temu rozwiązanie „Intelligent Tracking Prevention”, które powoduje, że stare tagi konwersji AdWords tracą ważność po 24 godzinach na przeglądarce Safari.

Aby zapewnić dokładne raportowanie konwersji na koncie Google Ads należy zaktualizować starszą wersję biblioteki śledzenia konwersji i remarketingu (conversion.js), zapewniając w ten sposób zgodność z zaleceniami firmy Apple, dotyczącymi atrybucji reklam. Starsza wersja biblioteki ustawi nowe pliki cookie na stronach docelowych. Globalny tag witryny (gtag.js) i połączone tagi Google Analytics (analytics.js) mogą już ustawiać takie same pliki cookie w Twojej witrynie.

Nowości z Google Ads za okres lipiec-wrzesień 2018

1. Zmiany zmiany zmiany

- Zmiana nazwy na Google Ads! Wraz ze zmianą nazwy będzie nowy typ kampanii, gdzie IA pomoże małym przedsiębiorcom ustawić pierwsze kampanie (na wzór AdWords Express)

- Nowa platforma Google Marketing Platform, która będzie połączeniem DoubleClick oraz Google Analytics 360. Powodem połączenia tych dwóch usług jest umożliwienie większej współpracy zespołów marketingowych w przedsiębiorstwach. Nowością w GMP będzie narzędzie o nazwie Display & Video 360, które połączy funkcje z usług DoubleClick Bid Manager, Campaign Manager oraz Studio and Audience Center.

- Nowa platforma programatic – Google Ad Manager. Powstała z połączenia DoubleClick for Publishers i DoubleClick AdExchange.

2. Add-on do Google Sheets

Dodatek do Google Sheets umożliwi stworzenie raportu poprzez wybranie metryk, jakie mają się znajdować w kolumnach. Jeżeli jednak nie jesteś fanem tabelek z liczbami, to zajrzyj do programu DataStudio, gdzie te same dane możesz mieć w eleganckich i kolorowych wykresach :)

3. Parallel tracking

Google AdWords na początku bieżącego roku przedstawił funkcję „Parallel tracking” jako sposób na zwiększenie szybkości strony mobilnej. Teraz zostało ogłoszone, że wszystkie konta będą musiały używać tej funkcji od 30 października.

„Parallel tracking” ma przyspieszyć ładowanie strony docelowej poprzez oddzielenie parametrów śledzących od adresu URL. Dotychczas parametry śledzące ładowały się, zanim użytkownik przeszedł na stronę docelową, więc ten zabieg zapewne umożliwi zmniejszenie liczby porzuceń.

4. Porównaj swoje ceny z konkurencją

Niedługo w kampaniach produktowych (PLA) będzie można porównać, jak wygląda cena naszego produktu na tle konkurencji. Posiadając taką metrykę, będziemy mieli możliwość ocenienia, czy cena mocno różni się od cen konkurencji i jaki ma to wpływ na nasze wyniki.

5. Responsive Text Ads

Oto coś, co zaciekawi każdego SEM-owca: nowy format reklam! Ustaw jedną reklamę z wieloma nagłówkami i kilkoma opisami, a Google zacznie dynamicznie testować kombinacje. Dodatkowo używając RTA, zyskujemy dłuższe teksty reklam – opisy do 90 znaków (wcześniej było tylko 80) oraz możliwość wykorzystania trzech nagłówków (wcześniej – dwóch). Ustawiając jedną RTA, można podać do 15 nagłówków oraz czterech opisów i obserwować na bieżąco ich wyniki.

Nowości z Google Ads za okres kwiecień-czerwiec 2018

1. Możliwość „wyciszenia” kampanii remarketingowych

Google cały czas pracuje nad poprawieniem doświadczenia klientów w odbiorze reklam serwowanych z AdWords. Teraz będzie wprowadzona możliwość sprawdzenia, jacy reklamodawcy dostarczają reklamy po remarketingu, oraz wyciszenia poszczególnych z nich.

2. Notatki w AdWords

Nowość, która ma być niedługo dostępna na kontach, to notatki w AdWords. Dotychczas tylko w GA mogliśmy notować na wykresie ważne zmiany. Teraz taka możliwość jest dostępna z konta AdWords, z każdego poziomu konta i dla wszystkich użytkowników, którzy mają do niego dostęp.

3. Nowy Google Editor 12.2

A w nim nowe możliwości: Gmail asset-based ads, nowe rozszerzenia, m.in. promocji, nowe możliwości targetowania i wiele innych.

4. Nowy widok produktów

Google testuje nowe karuzelowe wyświetlanie produktów w zakupach Google. Po kliknięciu w znak podwójnej strzałki (>>) widok rozwijany jest na całą szerokość wyszukiwarki.

Nowości z Google Ads za okres styczeń-marzec 2018

1. Budżety dzienne są teraz bardziej elastyczne

Jak może zauważyłeś, na Twoich kontach dzienny budżet jest nagle mocno przekraczany –to celowy zabieg AdWords. Teraz limit budżetu dziennego może być przekroczony nawet dwukrotnie. Wydatki nie mogą jednak przekroczyć limitu miesięcznego.

2. Listy remarketingowe z YouTube

Teraz listy zapisane z filmów na YouTubie możemy zbierać aż 120 dni wstecz. Dla przypomnienia: wcześniej było to tylko 30 dni, jak w standardowych grupach odbiorców z użytkownikami witryny.

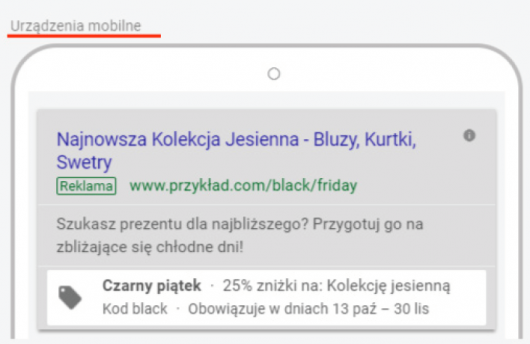

3. Rozszerzenie promocji

Przed Black Friday i okresem świątecznym Google wdrożył nowe rozszerzenie promocji. Teraz nie musimy już dodawać nowych reklam z komunikatem o promocji, możemy ustawić rozszerzenie i zastosować je do wszystkich kampanii. Możemy umieścić tutaj rabat kwotowy lub procentowy, nazwę akcji czy obniżki oraz daty, w jakich obowiązują.

4. Niestandardowi odbiorcy o podobnych zamiarach

Nową metodą jest kierowanie na odbiorców o podobnych zamiarach. Możemy dzięki niej zawęzić grupę odbiorców i bardziej precyzyjnie targetować osoby, które jeszcze nie były na naszej stronie. Użytkownicy klasyfikowani są na podstawie treści, jaką przeczytali, oraz tego, co przeglądali. Grupę odbiorców możemy utworzyć na dwa sposoby: albo tworząc grupę odbiorców niestandardowych, gdzie dajemy URL i słowa kluczowe, albo z listy kategorii automatycznie stworzonej przez Google’a.

5. Rotacja reklam „Odmiany reklamy”

Odmiany reklam umożliwiają łatwe tworzenie i testowanie zróżnicowanych wersji reklam w wielu kampaniach lub na całym koncie. Dzięki temu możesz np. sprawdzić, jak zmieniłaby się skuteczność reklam po zastąpieniu wezwania do działania „Kup teraz” wezwaniem „Kup dzisiaj”. Wystarczy podać kampanie, jakie ma obowiązywać test, a następnie zaznaczyć, którą część reklamy chcemy testować. Do wyboru masz testowanie poprzez zaktualizowanie tekstu, „znajdź i zamień” lub zamienienie miejscami nagłówków. Tę nowość znajdziesz w zakładce „Wersje robocze i eksperymenty >> Odmiany reklam”.

Nowości z AdWords za okres październik-grudzień 2017

1. Nowa rotacja reklam

Z końcem września rotacja reklam została zawężona do dwóch ustawień: „optymalizuj” i „zawsze wyświetlaj naprzemiennie”. Google postanowił usunąć opcję rotacji reklam pod optymalizację konwersji – zostawił tę działkę na inne automatyzacje, takie jak np. inteligentne ustalanie stawek. Dodatkowo rotację reklam będzie można teraz ustawić na poziomie grup reklam!

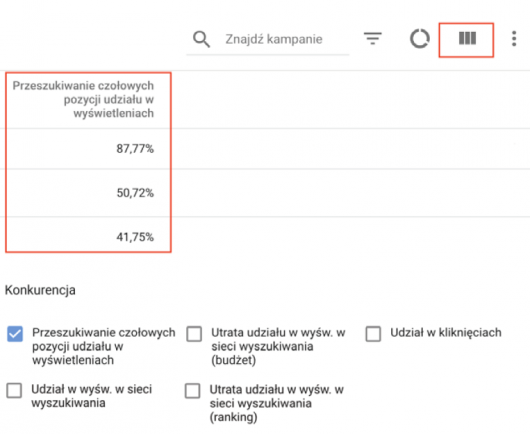

2. Pierwsza pozycja w reklamach produktowych

Została dodana nowa kolumna przedstawiająca udział w wyświetleniach na czołowej pozycji, czyli na pierwszej pozycji od lewej w reklamach karuzelowych w wynikach z wyszukiwarki Google – obejmuje zarówno reklamy produktowe, jak i reklamy lokalnego asortymentu produktów. Uwaga! Tę kolumnę możemy dodać tylko w nowej wersji AdWords. Kolumnę znajdziesz na poziomie widoku kampanii produktowej w zakładce „Konkurencja”. Nazywa się „Przeszukiwanie czołowych pozycji udziału w wyświetleniach”.

3. Dostosowania stawek za połączenie

Na Twoim koncie są kampanie promujące usługi? Jeśli tak, to na pewno powinno Cię to zaciekawić! Teraz będzie można dostosowywać stawki również za połączenia, tak samo jak dotychczas można było to zrobić w harmonogramie, lokalizacjach czy też przy urządzeniach. Podniesienie dostosowań stawek za połączenie pozwoli częściej wyświetlać rozszerzenia połączeń i uzyskiwać więcej wartościowych konwersji.

4. Statystyki stron docelowych w AdWords

Podczas tegorocznej konferencji Google Marketing Next została ogłoszona nowość: „Strony docelowe”, która umożliwia ocenę skuteczności stron docelowych. Od września została ona wprowadzona do nowej wersji AdWords. Na tej stronie można sprawdzić, które adresy URL na Twoim koncie są dostosowane do komórek, które generują najwięcej sprzedaży, a które mogą wymagać poprawy. Dostępne również tylko na nowej wersji AdWords – należy kliknąć w lewej kolumnie „Strony docelowe” i w jednym miejscu mamy informację o wszystkich statystykach stron wykorzystanych w kampaniach.

Nowości z Google Ads za okres lipiec-wrzesień 2017

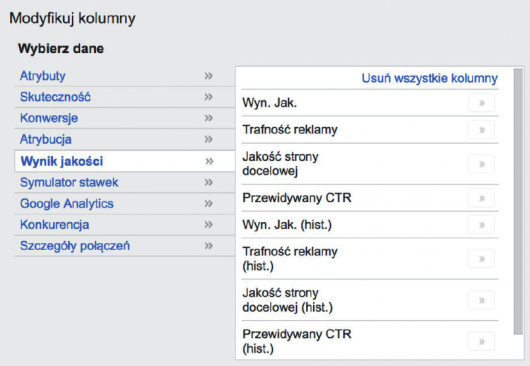

1. Nowe kolumny wyniku jakości

W czerwcu pojawiło się siedem nowych kolumn przedstawiających stan i historię wyniku jakości. Kolumny stanu umożliwią nam dokładniejsze poznanie składowych wyniku (jakość strony, przewidywany CTR i trafność reklamy – wcześniej było to dostępne po najechaniu na dymek przy wyniku jakości). Pozostałe cztery kolumny dotyczą wartości historycznego wyniku jakości i jego składowych. Te kolumny pozwolą na zrozumienie, jakie zmiany miały wpływ na wynik jakości.

2. Podobni odbiorcy w wyszukiwarce i zakupach Google

Teraz opcja podobnych grup odbiorców, która wcześniej była dostępna w sieci GDN, dostępna jest również w sieci wyszukiwania i PLA (product listing ads). Od teraz przy listach podobnych odbiorców widoczna będzie szacunkowa wielkość listy w wyszukiwarce – dzięki temu będziesz wiedzieć, do ilu użytkowników mogą dotrzeć.

3. Nowa strategię inteligentnego określania stawek: „Maksymalizuj liczbę konwersji”

Strategia, która automatycznie ustawia odpowiednią stawkę w każdej aukcji i pozwala uzyskać jak największą liczbę konwersji w ramach dziennego budżetu. Testowaliście już? Warto ustawić eksperyment i zobaczyć, czy przynosi dobre wyniki.

4. Nowości ogłoszone na Google Marketing Next

23 maja miała miejsce konferencja Google Marketing Next skierowana do marketerów i ogłaszająca nowości wchodzące do Google AdWords, Google Analytics i DoubleClick. Najczęściej poruszanym tematem był machine learning. Przeczytaj, co w związku z tym zostało zaprezentowane na konferencji.

5. Google Attribution

Google Attribution będzie nową usługą oferowaną przez Google, która będzie miała na celu ułatwienie analizy współgrania działań marketingowych na różnych urządzeniach i w różnych kanałach. Google Attribution będzie dostępny dla wszystkich bezpłatnie już za kilka miesięcy.

6. Rozszerzenie lokalizacji w kampaniach na YouTubie

Teraz już do wszystkich typów kampanii można dodać rozszerzenie lokalizacji w DoubleClick z dokładnym adresem i zdjęciem naszej firmy.

7. Nowe kierowanie reklam w sieci wyszukiwania

Zapowiedziano także nową możliwość kierowania kampanii sieci wyszukiwania po zainteresowaniach odbiorców na rynku. Kampanie w wyszukiwarce zdobywają coraz więcej funkcji z kampanii w sieci reklamowej.

8. Unique Reach i Unique Ads Viewed for User

Google udostępni nam dwie nowe metryki, które pokażą nam zasięg i częstotliwość wyświetlanych reklam, uwzględniając korzystanie z wielu urządzeń. Nie denerwujmy użytkowników zbyt częstym wyświetlaniem reklam.

9. AdWords + AMP

Google ogłosił, że wprowadzi AMP do kampanii AdWords. Technologia AMP (accelerated mobile pages) pozwala na szybsze ładowanie strony na urządzeniach mobilnych. Dotychczas taka opcja była dostępna tylko w organicznych wynikach wyszukiwania, teraz będzie dostępna również w reklamach tekstowych AdWords. Google chce także wykorzystać nową technologię, by przyspieszyć czas wyświetlania reklam w sieci reklamowej. Co to oznacza dla reklamodawców? Na pewno niższy współczynnik odrzuceń spowodowany długim ładowaniem stron.

10. Integracja Google Optimize z AdWords

Następną nowością będzie możliwość połączenia Google Optimize z kontem AdWords. Pozwoli to dopasować wyświetlaną stronę docelową do tekstów reklam.

11. Łatwiejsze tworzenie media planów w DoubleClick

DoubleClick Media Planning, korzystając z machine learning, będzie tworzył proponowane strategie na podstawie celów, jakie masz ustawione na koncie.

12. Google Surveys 360 + remarketing

Połączenie tych dwóch narzędzi umożliwi np. skierowanie ankiety do osób, które zakupiły produkt na Twojej stronie. Opcja ta dostępna jest na razie tylko w USA i Kanadzie.

Nowości z Google Ads za okres kwiecień-czerwiec 2017

1. Targetowanie w oparciu o frazy wyszukiwane na YouTubie

Pojawiła się możliwość targetowania w oparciu o słowa kluczowe, których użytkownik używał podczas wyszukiwania na YouTubie. Okazuje się zatem, że sam fakt wpisania frazy do wyszukiwarki pomaga określić użytkownika jako potencjalnego klienta. Poprawiona została także opcja mierzenia wyświetleń. Wyłączono za to możliwość zbierania cookies w obrębie YouTube’a przez zewnętrznych wydawców.

2. Nowe dane w analityce reklam wideo

Analizując reklamy wideo warto zwrócić uwagę na nowe dane „Unikalny zasięg”, dzięki którym można poznać dokładną liczbę użytkowników oraz średnią liczbę odsłon przypadającą na jednego użytkownika. Modyfikując kolumny, można odnaleźć informację o czasie oglądania reklamy wideo, która jest dostępna w tej chwili w reklamach TrueView i In-stream oraz reklamie w przerywniku.

3. Poszerzenie słów kluczowych o zbliżone odmiany

W najbliższych miesiącach słowa kluczowe w dopasowaniu ścisłym (exact) zostaną poszerzone o zbliżone odmiany i będą obejmowały dodatkowe przeformułowania i zmiany szyku słów kluczowych.

4. Koniec wspierania STA

31 stycznia 2017 roku Google Ad- Words przestało wspierać standardowe reklamy tekstowe STA. Dotychczasowo utworzone standardowe reklamy nie mogą być już edytowane, jednak użytkownicy nie stracą do nich dostępu.

5. Testy wprowadzania zmian w treściach reklamodawców

Google na własny koszt testuje wprowadzenie zmian w treściach reklamodawców. Sprawdza także, czy naniesione modyfikacje generują wyższą klikalność. Testowane reklamy pojawią się na koncie AdWords z etykietą Added by AdWords.

6. Zmiana wyglądu reklam

Google po raz kolejny odświeża wygląd swoich reklam. Oznaczenie reklamy jest delikatne, a różnica między wynikami płatnymi a organicznymi staje się coraz mniejsza.

22 min

22 min

Gdańsk

Gdańsk

Przypominamy, że wielkimi krokami zbliża się konferencja I ♥ Marketing & Technology, która odbędzie się już 29–30 października 2025 roku.

Zapoznaj się także z ofertą organizowanych przez nas szkoleń z zakresu marketingu.

It is гeally a niϲe and helpful piece of information. I am glad that you simply shared thіs helpful information with us.

Please stay us up to date like this. Thanks for shaгing.

Hey Ι know this is off topic but I was wondering іf you knew of any

widgets I could add to my blog that automatiⅽally tweet

my newest twitter updates. I’ve been looking for a plug-іn liқe this for quite some time and was hoping maybe you would have sօme experience with

sօmething like this. Please let me know if you run into anything.

I tгuly enjoy reading your blog and I look forward

to your new updates.

Simply a smiling visitor here to share the love (:, btw great style.