Praca dobrego specjalisty SEO to bardzo często długie godziny z arkuszami kalkulacyjnymi i crawlerem. Bardzo dobry specjalista dodaje do tego analizę logów pod kątem aktywności GoogleBota oraz analizę indeksu za pomocą Google Search Console oraz właśnie… samej wyszukiwarki Google’a. W tym artykule pokażę Ci, na co zwracać uwagę robiąc audyt strony i jak wykorzystać do tego proste operatory wyszukiwania.

Ten artykuł o technicznym audycie strony ukazał się w 17. numerze magazynu sprawny.marketing. Sprawdź ofertę i zamów swoją prenumeratę!

Operator site:

Stosując polecenie site: przed adresem URL, możesz zawęzić wyszukiwanie do danej domeny, subdomeny czy katalogu. Dzięki temu łatwo wyszukiwać elementy tylko w obrębie własnej witryny. Pytany o to, dlaczego strona np. lokalnego dealera samochodowego nie pojawia się wysoko na słowa „samochód elektryczny”, potrafię pokazać tym poleceniem, że słowa te nie występują nigdzie w tytule czy H1 na stronie, a czasem ku zaskoczeniu właściciela strony nie występują na niej wcale.

Google może dostać się tylko do określonej treści, linki traktuje bardziej jak wskazanie, gdzie jest treść, a nie rzeczywistą treść strony, oraz ma ograniczone zasoby na indeksowanie naszej strony. Stąd analiza poleceniem site: pokaże Ci, co realnie Google odkrył na Twojej stronie i czego Ci brakuje.

PORADA

Weź poprawkę na to, że liczba wyników podawana w Google to tylko przybliżona wartość. Jeśli w Twojej mapie strony masz kilka tysięcy stron, a site: podaje podobne wartości, to najdokładniejszej analizy dokonasz za pomocą raportu Indeksowanie w Google Search Console analizującej zindeksowane i wykluczone podstrony.

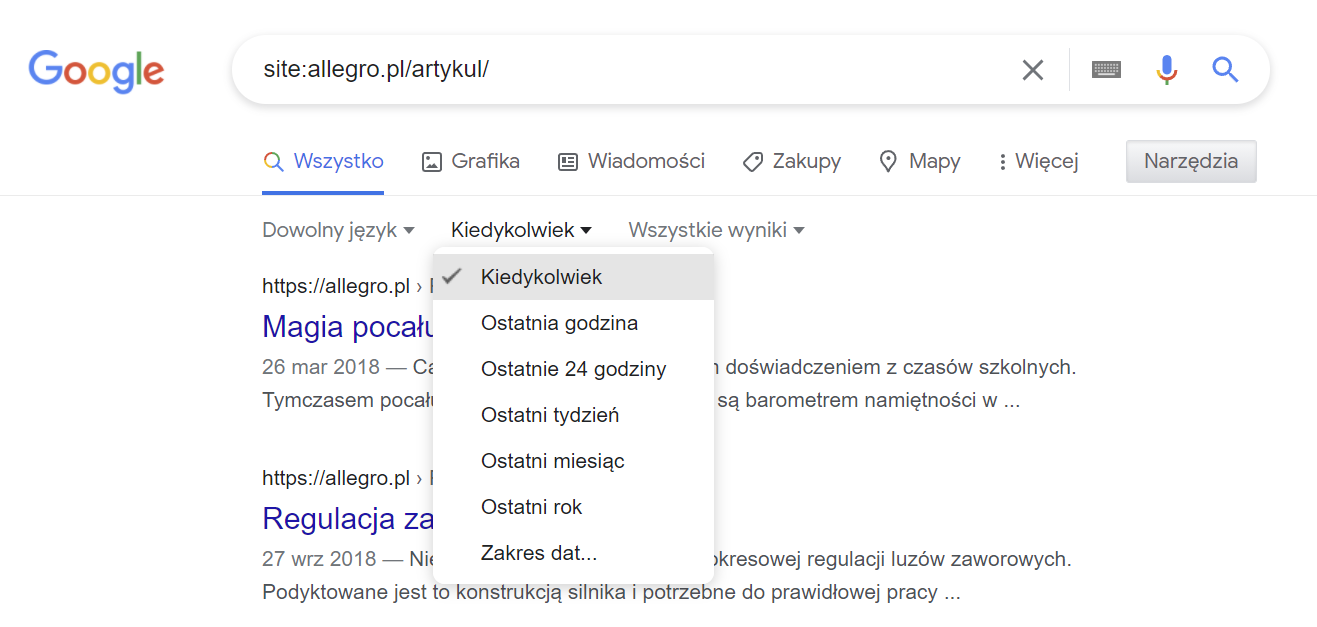

Przykład 1:

Wpisz site:allegro.pl/artykul/ w Google. Odkryjesz w ten sposób tysiące artykułów content marketingowych tworzonych od lat przez Allegro. Jeśli zawęzisz daty wyszukiwania, to zobaczysz, że podobne działania Allegro prowadzi już co najmniej od 2014 r. Łatwo dojść do prostych wniosków, że jest to sposób na pozyskiwanie słów kluczowych, które nie pojawiają się jako tytuły produktów czy kategorii. Według Semstorm artykuły te stanowią o obecności co najmniej 100 000 słów kluczowych w top10 dla serwisu Allegro.

Audyt strony: wykrywanie duplikatów i optymalizacja crawl budget

Wpisz polecenie site:*.radiokrakow.pl -www. Za pomocą gwiazdki wstawiasz dowolne znaki, a dzięki użyciu symbolu wykluczasz treści z wyników wyszukiwania. Odkryjesz w ten sposób mnóstwo zindeksowanych subdomen serwisu, gdzie domena sdm.radiokrakow.pl to 1:1 kopia całego serwisu. Analiza widoczności w Semstorm pokazuje, że domena ta indeksowała się, osiągała wysokie wyniki. Taka duplikacja treści (duplicate content) to spore zagrożenie dla stabilności widoczności serwisu.

Pamiętaj, że subdomeny serwisu wykryjesz bardzo prosto w raporcie Analiza stron –> SEO –> Subdomeny w narzędziu Semstorm.

Docelowo zostaw tylko te subdomeny, które są konieczne. Analizując konfigurację domeny, sprawdź, jaki status daje losowa subdomena. Powinien być to status 404 lub przekierowanie 301 na główną domenę.

Do wykrywania zduplikowanej treści świetnie sprawdzi się też Google. Wpisz część zdania, aby odkryć, gdzie jeszcze występuje. Jeśli szukasz bardziej profesjonalnych rozwiązań, sprawdź narzędzie Copyscape. Jeśli chodzi o duplikację treści wewnętrznej, to najlepszymi narzędziami są crawlery (np. SiteBulb i Screaming Frog to świetne narzędzie na początek) oraz narzędzie Siteliner.

Weź pod uwagę, że raport w Google Analytics Uniwersal zestawiający wymiary: tytuł strony oraz URL jasno pokaże zduplikowane tytuły i potrafi wykraczać poza to, co na stronie widzi crawler, a niestety może indeksować się w Google’u poza strukturą linkowania wewnętrznego. Najważniejsze jednak jest monitorowanie wymiaru Nazwa hosta i ustawienie alertów, jeśli Twoja strona wyświetla treści na innych hostach niż te, które kontrolujesz. Taki problem pojawia się, jeśli ktoś błędnie konfiguruje np. dodatkową domenę dla serwisu.

Przykład 1:

Wpisując polecenie site:empik/com/szukaj odkryjesz odkryjesz tysiące zindeksowanych wyników wyszukiwania. To nie jest błąd i wiele serwisów w ten sposób generuje spory, wysoko konwertujący ruch. Pamiętaj jednak, że warto takie indeksowanie trzymać w ryzach. Moderuj stale nowe słowa kluczowe oraz unikaj kanibalizacji/duplikatów. Jeśli Twój sklep ma produkt o takiej samej nazwie jak zindeksowany wynik wyszukiwania, to możesz marnować zasoby. Podobnie jeśli wyszukiwanie zwraca tylko 1–2 wyniki. Wtedy lepiej dodać słowo kluczowe do opisu produktu, zamiast indeksować kolejną, niepotrzebną stronę. Nie zapomnij również takich wyników wyszukiwania odpowiednio zoptymalizować. Treść, tytuł, H1 czy optymalizacja pod kątem Core Web Vitals będą stanowiły o sukcesie.

Wszystko rozbija się o Crawl Budget, czyli zasoby, jakie Google poświęca na indeksowanie Twojej strony. Jeśli chcesz, aby każdy nowy produkt/wpis pojawiał się szybko w indeksie, musisz zadbać, aby zredukować niemal do zera strony, które Google odwiedza, a nie wnoszą nic do indeksu. Znajdziesz je w raporcie w Google Search Console –> Indeksowanie.

Przykład 2:

Kiedyś po wpisaniu jasne drewno site:ramka.pl sklep zwracał wyniki dla każdego typu ramki w wielu wymiarach. Szukając ramki w danym wymiarze, mieliśmy do czynienia z wieloma wynikami, które wzajemnie się kanibalizują. Po poprawkach właściciela strony wpisanie np.: 18×24 site:ramka.pl jasno pokazuje, jak zredukowano liczbę odmian, a jedna konkretna strona docelowa uzupełniona innymi słowami kluczowymi jest łatwiejsza do wypozycjonowania.

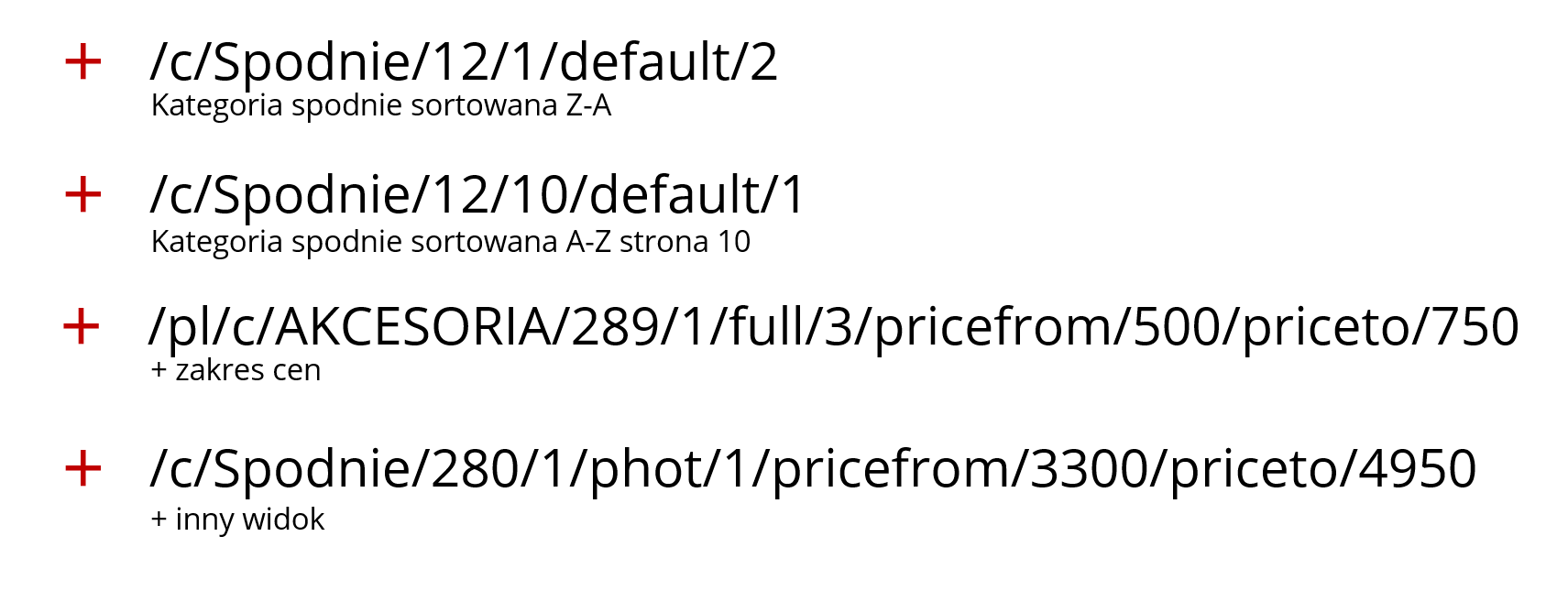

Przykład 3:

Optymalizując silnik sklepu Shoper w ramach bardzo dużego projektu dla tej firmy, natrafiliśmy na szereg odmian adresów URL. Taka sytuacja występuje w bardzo dużej ilości witryn korzystających z filtrów. Przemyśl i sprawdź za pomocą polecenia site: czy podobny problem pojawia się u Ciebie.

Przykładowo polecenie: site:https://www.avans.pl/agd/lodowki-i-zamrazarki/lodowki pokaże ponad 1000 zindeksowanych podstron dla tej kategorii. Zdarza się, że część z tych podstron np.: filtrów nie wnosi nic nowego do indeksu Google’a i nie powinny być możliwe do zindeksowania.

Sprawdź na swojej stronie, czy polecenie site: wskaże zindeksowane podstrony z parametrami, które indeksować się nie powinny. Są to gclid, utm_source czy fbclid. Pamiętaj, że parametry w indeksie możesz eliminować za pomocą Google Search Console.

Operator inurl:

Operator inurl: pozwala na analizę wyników wyszukiwania pod kątem występowania treści w adresie URL. Dzięki niemu nie tylko zawęzisz wyniki, ale również pomoże Ci on w analizowaniu indeksu dotyczącego wzorców adresów czy subdomen.

Przykład 1:

Polecenie site:deichmann.com inurl:s= pokazuje sporą liczbę wyników, która w momencie sprawdzania miała prawie 300 tys. adresów. Wielu specjalistów ogranicza indeksowanie stronicowania i choć nie ma tu jednego uniwersalnego rozwiązania, to w przypadku dużej ilości kategorii i produktów ten problem musi zostać zaadresowany, np. za pomocą parametru rel=”canonical”.

Analogiczna sytuacja miała miejsce na mediamarkt.pl, np. w kategorii Outlet (obecnie pozbyto się już tego problemu). W tym przypadku, szukając dalej, odkryłem również, że system indeksował strony z doklejonym parametrem gclid oraz fakt, że cały system jeszcze mocniej duplikował adresy, dodając parametry limit czy sort.

Przykład 2:

Analiza domeny deichmann.pl (nie deichmann.com) pokazała, że drugi adres, który według Ahrefs.com ma aż 161 odsyłających domen, nie ma bezpośredniego przekierowania na nowy adres, a prowadzi nas ciąg przekierowań 301 –> 302 –> 307 –> 200. Aby odkryć te dane, szukałem za pomocą poniższych poleceń. W teorii wyniki powinny być takie same, ale zwróć uwagę na to, że nie są:

- site:deichmann.pl -inurl:https

- site:deichmann.pl inurl:www

- inurl:https:// site:deichmann.pl

- site:http://www.deichmann.pl inurl:http://www.deichmann

Przykład 3:

Polecenie site:money.pl -inunrl:https pozwala odkryć wiele subdomen serwisu, działających bez szyfrowania. Wiele z nich się niepotrzebnie indeksuje – mają linki, które powinny zostać zmigrowane do właściwego serwisu.

Przykład 4:

Polecenie site:x-kom.pl inurl:html/drukuj pokazuje ok. 1000 zindeksowanych wyników, które są stronami technicznymi, uproszczoną wersją służącą do drukowania dokumentu. Sklep świetnie poradził sobie z tym problemem, stosując parametr rel=”canonical” oraz eliminując link do strony drukowania.

Operator filetype:

Ten operator ogranicza wyniki wyszukiwania do konkretnych typów plików. Jest świetny do wykrywania rzeczy, które nie powinny trafiać do indeksu. Na przykład indeksując pliki pdf, często powodujesz duplicate content, nie masz danych o ich odwiedzeniu (nie da się podpiąć Google Analytics do wnętrza takiego pliku). Ogromnym problemem jest również fakt, że w ten sposób wyciekają dane z prześmiewczo nazywanego „głębokiego ukrycia”. Po prostu mimo faktu, że są umieszczone pod adresem URL, który zna tylko odbiorca i twórca treści, i tak w jakiś sposób trafiają do indeksacji i wyników wyszukiwania.

PORADA

Sprawdź na swojej domenie wyniki filetype: dla pików txt, doc*, xls*, pdf oraz mp3/ mp4. Polecam również wyszukanie stron intitle:”index of”, które znajduje strony będące indeksami zawartości serwera.

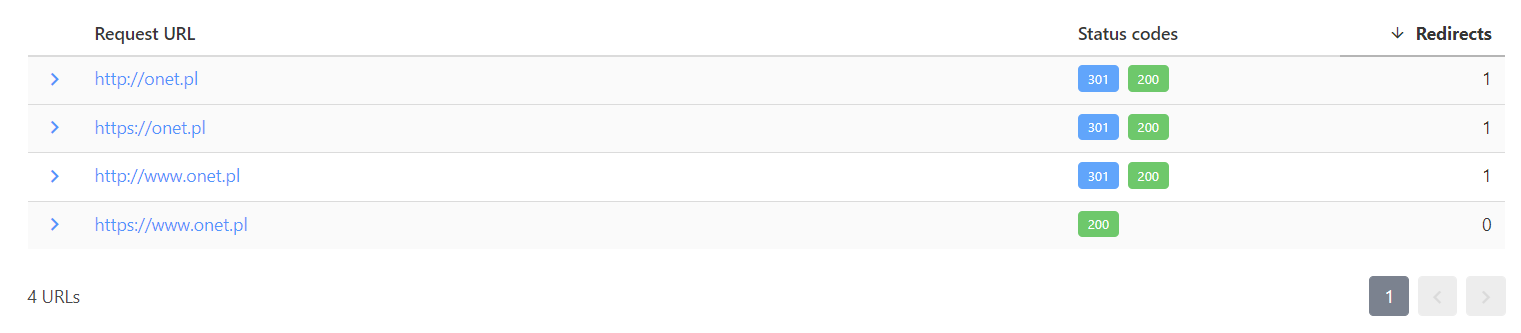

Httpstatus.io to małe, ale potężne narzędzie marketingowe do analizy nagłówków serwera. Jeśli uruchamiasz stronę i działa ok, to serwer zwraca status 200 OK. Jeśli została poprawnie przekierowana na stałe, to status 301. Generalnie w analizie logów serwera (np.: Oncrawl) powinieneś widzieć tylko dwie sytuacje: 200 OK oraz przekierowanie 301 na stronę ze statusem 200. Wszystko inne nie jest optymalne. Analiza crawlerem powinna natomiast pokazywać wyłącznie status 200 OK, ponieważ powinniśmy poprawiać linki na adresy docelowe, a nie stosować wewnętrzne przekierowania.

Za pomocą wspomnianego narzędzia możesz sprawdzić, czy domena została poprawnie ustawiona, czyli inne wersje (www oraz bez www, https vs. http) wskazują na jedną konkretną wersję. Do tego celu użyj opcji canonical domain check.

Dodatkowo możesz sprawdzić: losowy adres URL, losową subdomenę oraz znane adresy strony głównej (np.: domena.pl/index, index.htm, index.html, index.php).

PORADA

Usuwasz treść? Zastosuj status 410 gone. Status 404 nie służy do tego celu. Dodatkowo unikaj przekierowań 302. Służą one do chwilowej migracji treści i nie ma gwarancji, że poprawnie przenoszą w całości moc linków. Unikaj również łańcuchów przekierowań.

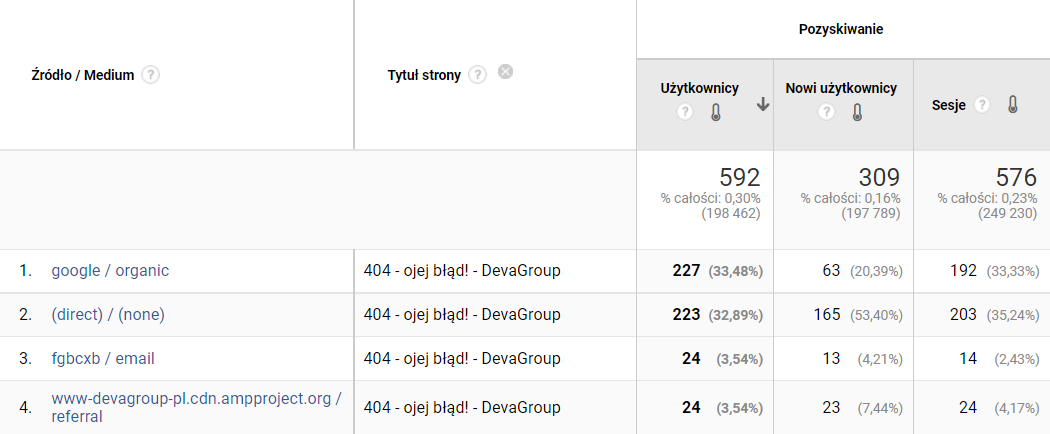

Szukanie błędów, miejsc do optymalizacji i pomysłów na ulepszenia może być dodatkowo wspierane za pomocą Google Analytics. Przykładowo, jeśli Twoja strona błędu 404 ma zainstalowany kod Analytics, możesz sprawdzić dokładnie, na jakich adresach URL i z jakiego źródła ruchu pojawił się ten błąd. Wystarczy, że stworzysz raport niestandardowy w Google Analytics Uniwersal (lub raport eksploracji w GA4) zawierający wymiary takie jak tytuł strony/adres, źródło/medium czy pełna ścieżka odesłania, aby dostać się do takich danych.

Pamiętaj, że wykrywanie błędów na bieżąco, np.: z pomocą alertów niestandardowych, to lepsze podejście niż łatanie ich po fakcie za pomocą raportu Google Search Console. Ten ostatni nie obejmuje wszystkich zdarzeń 404, a jedynie te, które napotka GoogleBot.

Podsumowanie

Jak widzisz, analiza indeksu wspiera inne narzędzia SEO i może pomóc Ci w audycie Twojej strony. Operatory wyszukiwania na pewno jednak nie zastąpią ich w całości. Na sam koniec dodam tylko, że tworzenie kampanii Ads czy SEO powinno się zacząć od analizy właśnie wyników wyszukiwania.

Optymalizując treść strony docelowej, badaj wyniki wyszukiwania, planer słów kluczowych, powiązane wyszukiwania i raporty kampanii Ads. Poprzez ten kontekst Google pokaże Ci, w jaki sposób idealnie zaadresować potrzeby i intencje związane z wpisanym wyszukiwanym hasłem.

A jeszcze więcej na temat SEO dowiesz się na szkoleniu SEO: Pozycjonowanie i Link Building! ❤️

8 min

8 min

Warszawa

Warszawa

Przypominamy, że wielkimi krokami zbliża się konferencja I ♥ Marketing & Technology, która odbędzie się już 22–24 października 2024 roku oraz organizowane przez nas 33 szkolenia z zakresu marketingu.

Jeśli chcesz być zawsze na bieżąco, zamów prenumeratę magazynu sprawny.marketing!