Pozyskiwanie linków bywa frustrujące: „czy link z witryny X wart jest starań? A może więcej korzyści przyniesie link z witryny Y?” Popularna wiedza o cechach mocnego linka często nie uwzględnia antyspamowych algorytmów Google. Tymczasem wyszukiwarki nie zliczają niektórych linków, obniżają wartość niektórych spośród pozostałych, a później patrzą całościowo na wszystkie linki, by ewentualnie dodatkowo jeszcze ograniczyć ich wartość. Poniżej opisujemy 10 technik wykrywania spamu – sprawdź, co wyszukiwarki wykryją w twoich linkach.

Zastrzeżenie:

Nie jestem pracownikiem żadnej wyszukiwarki, zatem poniższe stwierdzenia należy traktować jak przypuszczenia. Teoretycznie jest możliwe, że wyszukiwarki stosują tylko niektóre przedstawione tu techniki, lub wręcz nie stosują żadnej z nich. Z pewnością korzystają dodatkowo z innych, niewymienionych przeze mnie, a bardziej złożonych technik. Poświęciłem mnóstwo czasu na studiowanie artykułów naukowych i wniosków patentowych, warto więc, bym podzielił się co ciekawszymi technikami.

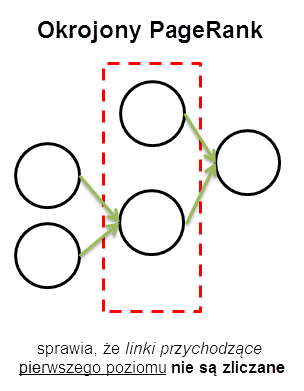

1. Okrojony PageRank

Podstawy koncepcji okrojonego PageRanku wyjaśniono w artykule Linked-based Characterization and Detection of Web Spam. Chodzi o PageRank obliczany z pomięciem wkładu mocy witryn linkujących bezpośrednio do pozycjonowanej witryny. W jaki sposób pomaga to w wykrywaniu spamu? Witryny pozycjonowane naiwnymi technikami (jak np. masowe użycie artykułów sponsorowanych) czerpią swój PageRank głównie z linków „pierwszego poziomu”. Tymczasem dobrze pozycjonowane witryny czerpią moc także z linków głębszych poziomów. Jeśli zatem PageRank witryny jest dużo wyższy, niż jej okrojony PageRank, jest to dla wyszukiwarek mocna wskazówka jej spamerskości.

2. Udział linków z witryn własnych/ogólnodostępnych w profilu linków

Linki można podzielić na trzy grupy według pochodzenia:

- linki z witryn własnych (czyli uznanych przez wyszukiwarki za powiązane z witryną pozycjonowaną, np. na podstawie numerów IP, whois domen, dużej częstości jednoczesnego linkowania do nich),

- linki z witryn ogólnodostępnych – pozostałe linki, które jednak pochodzą z witryn, z których każdy może łatwo zalinkować, np. blogi, fora, katalogi artykułów, księgi gości itd.

- linki z witryn nie-ogólnodostępnych.

Nie wszystkie linki z pierwszej grupy są złe, nie wszystkie z ostatniej – dobre. Linki z witryn własnych mogą być doskonale naturalne. Z drugiej strony, linki z witryny nie-ogólnodostępnej mogą być kupione. Generalnie jednak warto mieć świadomość tej klasyfikacji, może to pomóc w ocenie wartości linków.

Jak widać z powyższego wykresu, profil linkowy jednej witryny to przede wszystkim linki z witryn własnych i ogólnodostępnych. Natomiast inna witryna przyciąga znacznie więcej linków z witryn nie-ogólnodostępnych. Jeśli wszystkie pozostałe wskaźniki obu witryn są identyczne, to druga witryna wygląda znacznie mniej spamersko.

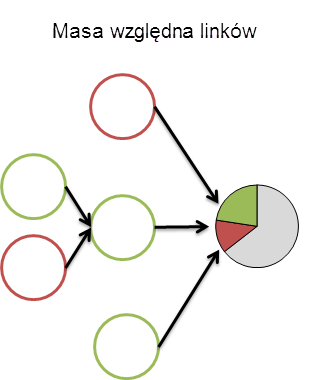

3. Masa względna

Masa względna to procentowy udział danego typu linków w całym profilu linków danej witryny. Przykładem ilustracji mogą być powyższe wykresy kołowe.

Temat masy względnej jest szerzej omówiony w artykule Link Spam Detection Based on Mass Estimation. Analiza mas względnych pozwala ustalić próg, przekroczenie którego jest traktowane jako oznaka spamu. Na powyższym wykresie czerwone okręgi symbolizują spamerskie witryny. Odpowiadają one za część mocy, którą otrzymała witryna pozycjonowana (docelowa). Jeśli udział mocy przekazanej przez witryny spamerskie przekracza ustalony próg, obniżeniu ulec mogą albo (bezpośrednio) pozycje witryny docelowej, albo wartość spamerskich linków. Oczywiście, nasz wykres prezentuje niespotykaną w rzeczywistości sytuację zero-jedynkową (witryna linkująca jest albo „całkowicie spamerska”, albo „wolna od wszelkich podejrzeń”).

Tego rodzaju analizy mogą posłużyć także tobie, do planowania taktyki działań link-builderskich. Warto zastanawiać się, jaką część linków chcemy pozyskać z komentarzy, katalogów, artykułów, przejętych witryn, witryn własnych, linków kupionych itd. Oczywiście, algorytmy wyszukiwarek nie są tu jakoś nadzwyczajnie sztywne i na karę trzeba sobie zasłużyć.

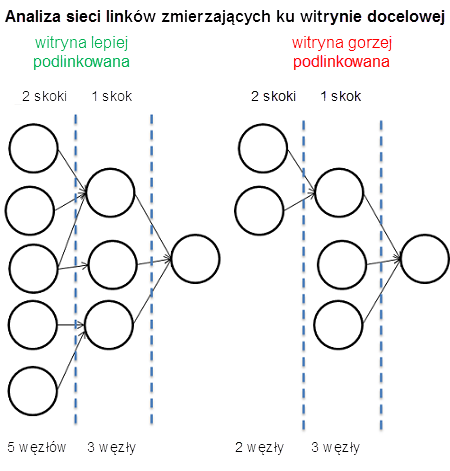

4. Analiza sieci linków, szerokości poziomów sieci i umiejscowienia jej wierzchołka

Kolejna metoda szacowania wartości linków opiera się na analizie sieci linków zmierzających ku witrynie docelowej (piramidy linków), a więc liczebności witryn („źródeł PageRanku”) znajdujących się w odległości jednego, dwóch, trzech itd. linków (skoków/poziomów). Ważne jest też, w jakiej „odległości” (liczonej skokami/poziomami) od witryny docelowej znajduje się wierzchołek, tj. w odległości ilu skoków liczba witryn jest największa.

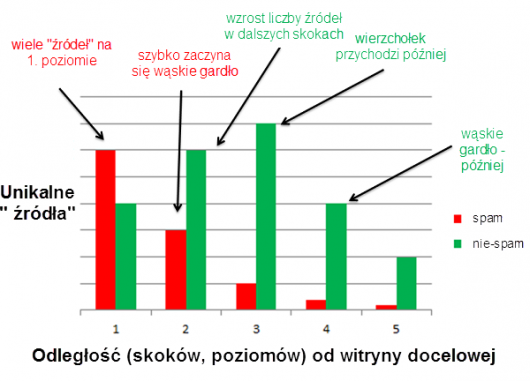

Poniżej widać natomiast rozkład witryn („źródeł”) będących w piramidzie linków (sieci linków) pozycjonowanej witryny pomiędzy poszczególne poziomy odległości od niej. Widać tu jak na dłoni różnice między witryną linkowaną technikami spamerskimi i linkowaną poprawnie.

Jak widać, spamerskie witryny szybciej osiągają wierzchołek. Witryny spamerskie mają więcej linków pierwszego poziomu (wskazujących je bezpośrednio), natomiast w miarę oddalania się od nich, szybko ubywa witryn-„źródeł” w ich piramidach (sieciach). Taki rozkład może służyć wyszukiwarkom jako sygnał spamerskości witryny. Liczba unikalnych „źródeł” maleje wraz ze wzrostem odległości tym szybciej, że piramidy/sieci spamerskich witryn często zawierają te same „źródła” wielokrotnie, powtarzające się na różnych poziomach.

Sądzę, że jest to jedna z przyczyn, dla których różnorodność unikalnych domen jest dobrze skorelowana z wysokimi pozycjami. Nie uważam, by związek ten opierał się tylko na prostym zliczaniu linkujących domen, raczej na zliczaniu „źródeł” w powiązaniu z analizą okrojonego PageRanku.

5. TrustRank, Anti-TrustRank, SpamRank itd.

Model TrustRanku był już wielokrotnie omawiany i stał się podstawą takich miar jak mozTrust. Naczelnym założeniem jest, że wszystkie kolejne „źródła” dają jednocześnie moc „skażoną” (spamerską) i zaufaną – obie przekazywane są do pozycjonowanej witryny za pomocą linków. Jeśli jesteś blisko źródła bijącego przede wszystkim mocą spamerską, jest bardziej prawdopodobne, że jesteś spamerem, i odwrotnie. Znaczenie mają zarówno linki przychodzące, jak i wychodzące.

Nie będę tu wchodził w szczegóły, ponieważ wiele już o tym napisano, sformułuję tylko 4 naczelne zasady:

- zdobywaj linki z zaufanych witryn,

- nie bierz linków z witryn spamerskich,

- linkuj do zaufanych witryn,

- nie dawaj linków witrynom spamerskim.

Z pomocą takiej techniki można użyć pozycjonerskich forów do walki ze spamerami; wystarczy je przecrawlować i zacząć analizę od linkowanych tam adresów…

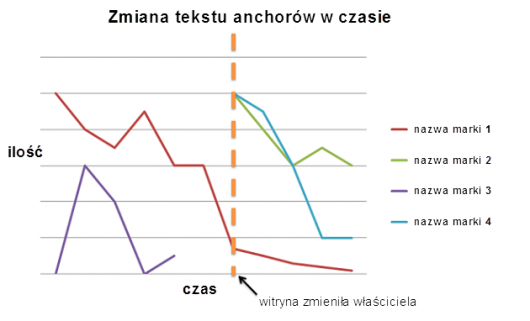

6. Zmiana anchor teksów w czasie

Monitorowanie zmian tekstów zakotwiczeń w czasie może służyć wykrywaniu manipulacji. Spójrzmy na analizę przykładowej witryny, która – należąc pierwotnie do kogoś innego – została później przejęta przez spamera ze względu na wysoką moc SEO wychodzących z niej linków.

O tej domenie wyszukiwarki wiedzą, że w przeszłości przyciągała linki o anchorach zarówno zawierających nazwę marki, jak i niezawierających. To nagle ustało, a po pewnym czasie, równie nagle, linki znów zaczęły się pojawiać, ale już z zupełnie innymi anchorami. Tego rodzaju analiza zmian tekstów zakotwiczenia w czasie, w połączeniu z ortogonalnymi technikami wykrywania spamu, pozwala ustalić moment, w którym zmienia się właściciel witryny. Zdobyte do tego momentu przez witrynę linki mogą być odtąd traktowane zupełnie inaczej.

Technikę tę (i kilka innych, ciekawych rzeczy), szczegółowo omówiono w artykule Document Scoring Based on Link-Based Criteria.

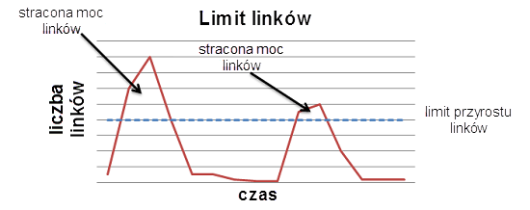

7. Limity przyrostu linków

Pozycjonerzy zdobywający gwałtownie wiele linków dla swoich witryn mogą być rozczarowani efektami, wyszukiwarki stosują bowiem limity mocy, która może przepłynąć do witryny w jednostce czasu. Jednocześnie analizowane są bowiem inne czynniki, pozwalające stwierdzić, czy nagły skok liczby linków jest wynikiem np. udanej akcji wiralowej lub ważnego wydarzenia czy też jednak sztuczek pozycjonerskich.

Moc linków, które przekroczą taki limit, może nie być brana pod uwagę. Bardziej równomierny, naturalny przyrost linków ma mniejsze szanse przekroczyć limit. Więcej szczegółowych informacji na ten temat możesz znaleźć w artykule pt. Information Retrieval Based on Historical Data.

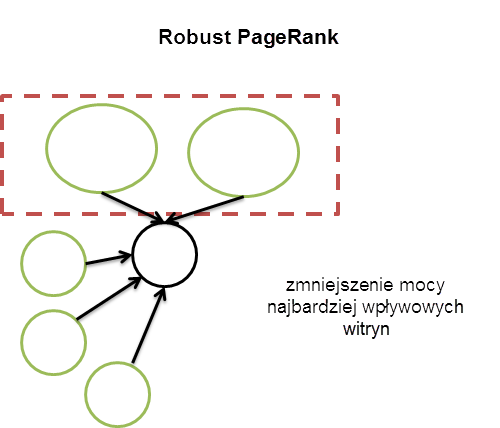

8. Robust PageRank

Robust PageRank to PageRank nieuwzględniający wkładu linków o największej mocy.

Jak widać na powyższym schemacie, dwa najsilniejsze linki zostały „wyłączone”, zmniejszając tym samym PageRank witryny docelowej. Dobre witryny mają zwykle zdywersyfikowane źródła mocy i nie zależą od kilku mocnych linków (takich jak linki z farm linków). Obliczanie Robust PageRanku to jedna z metod ograniczania mocy nadmiernie mocnych witryn. Więcej na jego temat przeczytasz w artykule Robust PageRank and Locally Computable Spam Detection Features.

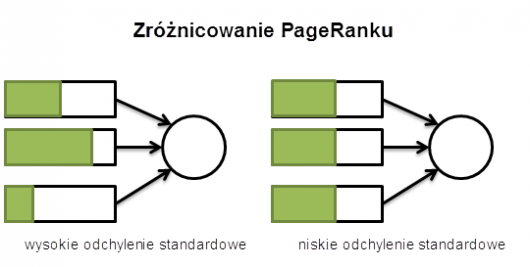

9. Zróżnicowanie PageRanku

Jednolitość PageRanków spływających do witryny docelowej może być oznaką spamu. Naturalne profile linkowe są zwykle mocniej zróżnicowane jeśli chodzi o PageRank. Profile spamerskie mają tendencję do większej jednolitości w tym względzie.

Jeśli zatem korzystasz z jakiejś giełdy, serwisu lub narzędzia by zamówić 15 linków o PR 4 z określonym anchor tekstem, fundujesz sobie małe zróżnicowanie PageRanku. Wykrycie takich technik jest bardzo proste.

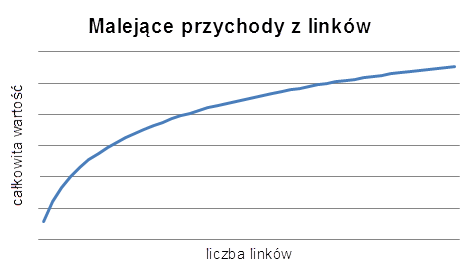

10. Prawo malejących przychodów

Jedną z metod zmniejszania skuteczności sztuczek pozycjonerskich jest wytworzenie efektu malejącego przychodu. Najskuteczniej działa to przeciwko linkowaniu sitewide, tj. z każdej podstrony serwisu, np. ze stopek czy blogrolli. To sposób na załatanie istniejącej kiedyś dziury, polegającej na nieograniczonej mocy link popularity, który to wskaźnik łatwo było „pompować” właśnie linkami sitewide.

Pierwszy link z danej domeny niesie moc X, a kolejne pochodzące z niej linki zwiększają całościową przekazywaną przez nią moc, ale tylko do pewnego momentu. Po jego przekroczeniu, kolejne linki będą dawać coraz mniejsze przychody. Zwiększenie liczby linków przychodzących z określonej domeny z 1 do 3 przyniesie znacznie większy zysk, niż zwiększenie jej ze 101 do 103.

Algorytmy wykrywania spamu linkowego

Każdy algorytm wykrywania spamu cechuje się jakimś współczynnikiem trafności i jakimś poziomem fałszywych alarmów. Stosowanie kombinacji różnych algorytmów pomaga podnieść trafność i zmnimalizować fałszywe alarmy.

Wykrywanie spamu webowego jest mniej wrażliwe na fałszywe alarmy, niż wykrywanie spamu mailowego, bo prawie zawsze w kolejce czeka wiele witryn, gotowych zastąpić usuniętą lub zdegradowaną. To nie tak, jak ze spamem mailowym, który z natury jest zero-jedynkowy (skrzynka odbiorcza albo folder ze spamem). Ponadto, wyszukiwarki nie muszą wybierać między zaklasyfikowaniem witryny jako „spamerskiej” lub „niespamerskiej”, by poprawić jakość wyników wyszukiwania. Korzystając z algorytmów antyspamowych, takich jak opisane w tym artykule, wyszukiwarki mogą po prostu obniżyć pozycje wątpliwych witryn.

Owe algorytmy tworzone są także z myślą o pogorszeniu ROI spamerskich sztuczek, co czyni spamowanie trudniejszym i kosztowniejszym. Ten artykuł nie jest o tym, jakie linki działają, a jakie nie – trudno to ustalić. Jego celem jest przedstawienie algorytmów, którymi wyszukiwarki rozwiązują swoje problemy, byś wiedział, w jakim stopniu wpływają one na stosowane przez ciebie metody.

[źródło: Better Understanding Link-based Spam Analysis Techniques]

8 min

8 min

Poznań

Poznań

Przypominamy, że wielkimi krokami zbliża się konferencja I ♥ Marketing & Technology, która odbędzie się już 29–30 października 2025 roku.

Zapoznaj się także z ofertą organizowanych przez nas szkoleń z zakresu marketingu.

Juz sie cieszylem, ze Polak odpicowal swietny artykul, a to tylko tlumaczenie :(

Niemniej, ciekawe techniki. Mniej zyciowe, bardziej akademickie, ale mnie i tak rajcuja ;)

Nieźle Maciej!

Czekam na więcej :)

Świetny tekst pokazujący jak przy pomocy dość prostych środków można zrewidować naturalność linków prowadzących do danej strony.

Zastanawia mnie, ile z podanych technik można by znaleźć w dokumentach patentowych złożonych przez potentatów rynku wyszukiwarek.

„Juz sie cieszylem, ze Polak odpicowal swietny artykul, a to tylko tlumaczenie :(”

Cała teraz nadzieja w tobie Krzysiu. Pokaż co potrafisz.

Świetny, profesjonalny tekst. Lektura obowiązkowa dla pozycjonerów – linkerów :)

A mi się podobał artykuł;-). Bardzo treściwy i obszerny.

Niezły wpis, dający do myślenia, wszystko sprowadza się do stworzenia własnego mikro-internetu, którym będziesz pozycjonować strony. Im (ten mikro-internet) będzie większy tym lepiej.

Wciąż są to jednak wskaźniki trudne do zmierzenia i chcąc uniknąć wykrycia spamerskich linków potrzeba by ogromnego panelu do zarządzania pozycjonowanymi stronami (i linkami do niej prowadzącymi), no i sporego zaplecza lub stron 'zaprzyjaźnionych’ (np. należących do innej firmy pozycjonerskiej).

Tekst ciekawy ale za mało danych do analizy. Mam wrażenie że każde zagadnienie potraktowane „po łebkach”… Pozostaje tylko testować i sprawdzać „czy żyje”

..ale żadna z tych technik nie działa samodzielnie, jest mniej lub więcej skorelowana z inną/innymi – i tu zaczyna się cała zabawa, a tego typu regularności można było zauważyć już wieki temu ;-)

Zasada jest prosta: Zwiekszając różnorodnosć linkowania, dywersyfikując – spada możliwość skorzystania z usług któregokolwiek algorytmu antyspamowego.

Tekst rzeczywiście ciekawy, ale tak jak ktoś już napisał – przydała by się głębsza analiza.

Dzwoni, ale w którym kościele?

Jakby co ja się pokusiłem na seo.zgred.pl o małą głębsza analizę ;) no i dałem linka do sprawnego :D

Dzięki, nie omieszkamy się odwdzięczyć przy najbliższej okazji ;)

Dla zinteresowanych Zgredowym punktem widzenia problemu:

http://seo.zgred.pl/google-rozpoznaje-linki-spamerskie-moje-przemyslenia-807

a tak na serio ktoś zakumał o co chodzi ?

tom: każdy „zakumał” ;)

Rzeczywiście artykuł bardziej akademicki, ale dający dużo do myślenia.

Warto było przeczytać ten tekst, chociaż tak jak zauważyło kilku komentujących – ma on charakter bardziej akademicki. Jeśli połączymy go z wpisem na blogu Zgreda otrzymamy całkiem porządną dawkę SEO – wiedzy.

Również skuszony wątkiem, który poruszył niejednego pozycjonera skusiłem się na własny głos w dyskusji na websem.pl – szczególnie, że Zgred poruszył ciekawy wątek rel=me.

Tyle pitolenia, a spam jak działał tak dalej działa.

Marcin Juraszek – boxy komentarzy (Twój jest trzeci od góry) oznaczane kolorem są znakiem zabierania głosu autora/tłumacza. Sam siebie chwalisz? cyt.”Świetny tekst…”

Reszta komentujących ma normalne boxy ale nie Ty. Taka wtopa i wstyd…

@Hejsztagenn

Kolorem oznaczone są komentarze osób, które mają konto w danej „instalacji” WordPressa. Marcin Juraszek ma takie konto na Sprawnym, bo publikował u nas (na razie jeden artykuł: https://www.sprawnymarketing.pl/artykuly/seo-pozycjonowanie-html5/). Wtopę zaliczyłeś więc Ty, kolego, zdecydowanie spiesząc się z oskarżeniami.

Tak mi przykro :(

Ciekawy tytuł artykułu, przeczytałem z zainteresowaniem, choć niektóre rzeczy, proste w swojej istocie zostały wyjaśnione „zawile wprost” ;)

Niemniej będę zaglądał po więcej wiedzy. Pozdrawiam.

Wielki mądry tłumaczony artykuł, a pod nim klasyczne spamerskie upychanie słów kluczowych.

„Osoby które odwiedziły tą stronę znalazły ją szukając:” i tara, cała lista keyów.

Tekst oparty na samych domniemaniach nie poparty żadnymi testami bazujący na wierze w nieograniczone moce obliczeniowe googla i takowe zasoby ludzkie.

To raczej kompendium pomysłów jak wyszukiwarki mogły by rozpoznawać niechciane witryny z jednym zastrzeżeniem wszystkie doprowadziły by do powstania usługi depozycjonowania.

@Marek „linki obce mogą być uznane za spamerskie – dlatego, że nie ogólnodostępne” koniecznie pójdź śmiać się z takiego stwierdzenia na jakiś blog, który coś takiego napisał.

Srutututu majty z drutu, zgadzam sie z @Markiem za duzo filmow sci-fi sie ktos naogladal albo teorii spiskowych naczytał. Nic tak dobrze nie działa jak miliard linków tak bylo jest i bedzie

Nie widzę tutaj jakiś naukowych testów, a tylko wykresy wyssane z palca.

Jeszcze długo teoria w tej branży nie będzie zbiegać się z praktyką :)

Ciekawe, jasne, zrozumiałe i logiczne w dodatku sprawiedliwe.

Ciekawe jak w rzeczywistości działają te algorytmy :P. Dziwię się, że mimo tylu różnych algorytmów niektóre firmy pozycjonerskie wciąż wykorzystują w ponad 90% własne zaplecze i osiągają sukcesy w pozycjach.