Amerykanie nie lubią jeść soczewicy. Skąd to wiem? W 2022 r. sieć hoteli Accor wdrożyła innowacyjny system o nazwie Orbisk. Dzięki niemu hotelowe restauracje marnują mniej jedzenia. Jak działa?

Zanim obsługa hotelu wyrzuci talerz z niedokończonym jedzeniem do kosza, podstawia go pod specjalną maszynę, która robi zdjęcie talerza. Sztuczna inteligencja identyfikuje składniki na talerzu. Na podstawie tych informacji połączonych z danymi o gościach hotelowych szef kuchni dostaje rekomendacje, których dań robić więcej, a których mniej. Okazało się, że Amerykanie nie zjadają soczewicy, którą z ciekawości nakładali sobie na talerz.

Takich asystentów AI będzie coraz więcej. Zarówno w profesjonalnych zastosowaniach – na pewno słyszałeś o systemach, które pomagają radiologom wynajdować anomalie na zdjęciach rentgenowskich – jak i w zastosowaniach prywatnych. Istnieje aplikacja, która pomaga w odróżnianiu grzybów jadalnych od trujących, no i oczywiście jest nawigacja, która podpowiada Ci, którędy masz jechać.

Wiesz, kiedy taki asystent AI przestaje być pomocny? W dwóch przypadkach. Pierwszy scenariusz jest taki, że nie potrafimy używać narzędzia, które dostajemy. To racjonalny powód. Drugi scenariusz: ignorujemy rady. Uważamy, że wiemy lepiej. Dziś chciałbym dać Ci narzędzia i metody do uporania się z oboma tymi scenariuszami.

Niewłaściwe wykorzystanie narzędzi AI

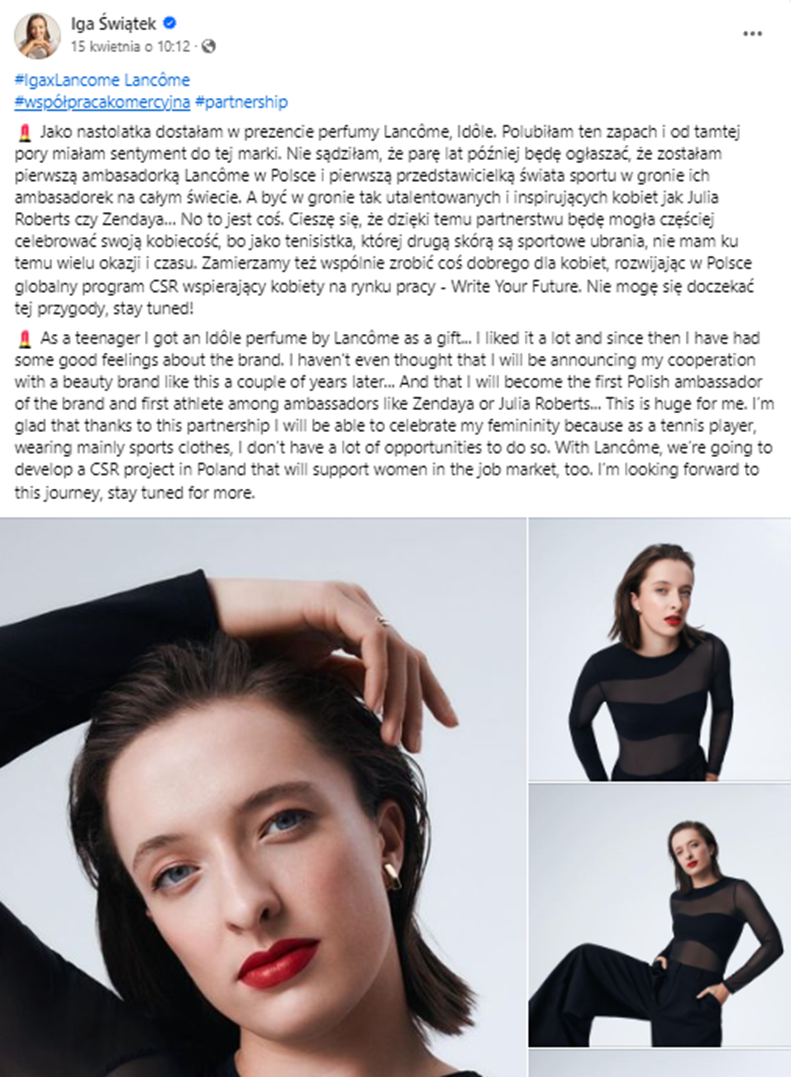

Zacznijmy od używania modeli językowych. Narzekamy, że generują one przewidywalne, miałkie teksty. Jakiś czas temu Iga Świątek opublikowała na Facebooku informację o tym, że została pierwszą w Polsce ambasadorką marki Lancôme. Od razu – jak to w internecie – wysypały się komentarze od znawców różnego rodzaju, instruujące Igę, jak ma żyć, co ma robić i jak ma pisać posty w social mediach. Leave Iga Alone!

Ale to, na co chcę zwrócić uwagę, to powtarzający się motyw: posty Igi wyglądają tak, jakby pisał je ChatGPT. Czy ChatGPT pisze złe posty? Nie, tylko trzeba się nauczyć go używać porządnie.

I nie, to nie jest artykuł o prompt engineeringu – przynajmniej nie takim, jak myślisz. Trafiłem ostatnio na e-book o różnego rodzaju pomocnych promptach. Bardzo prominentną sekcją było tam namawianie Chata GPT, żeby wcielił się w rolę tego czy innego wielkiego umysłu. Przykro mi, ale to nie działa. ChatGPT jest w stanie wcielić się w Steve’a Jobsa tak samo, jak osoba komentującą na LinkedInie jest w stanie wcielić się w Igę Świątek. Taki „znawca” twierdzi, że Iga jest w swoich postach nieautentyczna – i mniej więcej takiej samej wartości są twierdzenia Chata GPT, któremu kazałeś myśleć, że jest Elonem Muskiem.

Najpierw musisz się czegoś… oduczyć!

Skoro nie tędy, to którędy pójść? Porozmawiajmy o dwóch sposobach wchodzenia w interakcję z modelami językowymi. Jeden przyda się do generowania tekstów, a drugi do generowania obrazów.

1. Jak generować wartościowe teksty?

Zacznijmy od tekstów. Tutaj najpierw musimy się czegoś… oduczyć. Modele językowe działają tym lepiej, im więcej materiału dostaną na wejściu. To, co nazywamy miałkim stylem Chata GPT, jest niczym innym, jak regresem do średniej – uśrednionym stylem komunikacji całego modelu językowego. Im bardziej go rozbujamy, tym bardziej się od tej średniej odchyli i wygeneruje dla nas coś wartościowego.

Problem polega na tym, że używamy modeli językowych tak, jakbyśmy używali wyszukiwarki Google’a.

Google przyzwyczaił nas to tego, że łapie w lot nasze intencje, więc wyszczekujemy do niego słowa kluczowe, nawet nie przejmując się konstrukcją pełnych zdań. Chcemy się dowiedzieć, jakie są najlepsze restauracje serwujące chińskie jedzenie w Warszawie? Wpisujemy: „chińska restauracja Warszawa” i oczekujemy, że Google przejmie pałeczkę. Google serwuje nam mniej więcej te same odpowiedzi. I nam to nie przeszkadza. Ale w przypadku modelu językowego, który ma generować posty na media społecznościowe, już zaczyna przeszkadzać.

Ogólna reguła powinna być taka: im więcej słów w zapytaniu, tym bardziej odległy od średniej będzie wynik, który otrzymasz od modelu językowego. Zatem wpis typu „Wygeneruj mi post do social mediów przedstawiający zalety MacBooka Air” wygeneruje papkę w stylu Chata GPT.

Ale zrób prompt: „Myślałem ostatnio o MacBooku Air. Zastanawiałem się, czy go kupić. Niby jest lekki, waży niewiele więcej niż pszczoła w locie, ale z drugiej strony boję się, czy procesor bez wiatraka da sobie radę przy moim stylu pracy. Robię na komputerze prezentacje, ogarniam sprawy firmowe, czasem zdarza mi się zmontować jakiś film w DaVinci Resolve (nie lubię jakoś Final Cut Pro). Weź te moje rozterki, dodaj to, co wiesz o MacBooku Air i napisz post do social mediów, który używa mojego języka, mojego stylu i mówi o zaletach MacBooka Air. Niech post będzie zabawny. Zwróć uwagę na zastosowania, o których pisałem. Wpleć w post słowo makrela”. Podziwiaj wyniki.

2. Jak „namalować” obraz przy pomocy AI?

Takie same „szczeknięcia” próbujemy stosować przy generowaniu obrazów. I niestety, to kwestia przyzwyczajenia. Socjologowie zauważyli, że dzieci w interakcjach z modelami językowymi używają o wiele dłuższych promptów niż dorośli, wychowani na Google’u. A tu dochodzi jeszcze jeden problem. Ale tym razem winna nie jest żadna stara technologia, tylko nasz własny mózg. A konkretnie język, którego używamy. Dlaczego? Ponieważ nie jest stworzony do malowania obrazów. Skąd to wiemy?

David Ogilvy, jeden z najsłynniejszych copywriterów świata, w 1958 r. dostał zadanie zareklamowania Rolls-Royce’a. Nie wiem, czy spotkała Cię kiedyś okazja, aby doświadczyć przejażdżki tym samochodem – jeśli nie, wszystko przed Tobą. Ale gdybyś dostał zadanie opisania go, jakich słów byś użył?

Ludzie, których pytam o to na szkoleniach, odpowiadają „luksusowy, prestiżowy i elegancki”. Ale teraz wyobraź sobie następujący eksperyment. Opisujesz tego Rollsa za pomocą słów „luksusowy, prestiżowy, elegancki”, a potem wpuszczamy na salę nową osobę. I robimy jej wprowadzenie: grupa miała proste zadanie: opisz przedmiot. Opisali go za pomocą słów prestiżowy, luksusowy, elegancki. Twoje zadanie jest równie proste: narysuj ten przedmiot. Jak Ci się wydaje, jaki procent narysuje Rolls-Royce’a? Powyższe słowa równie dobrze opisują dom, płaszcz, obiad w restauracji, bal u księcia w baśni o Kopciuszku i tak dalej.

„Prestiżowy, luksusowy i elegancki” to tzw. słowa wytrychy. Wytrych to klucz, który pasuje do każdego zamka. Tak samo te słowa – pasują do mnóstwa kontekstów. Używamy ich, bo są łatwe – nie musimy się zastanawiać, o czym jest rozmowa i możemy do takiej rozmowy dołączyć, budować relacje z rozmówcą, niczego jednocześnie nie wnosząc. Mówiąc metaforycznie: te słowa nie malują obrazów w głowie odbiorcy.

Ale kiedy próbujemy dogadać się z modelem językowym, który ma dla nas namalować obraz, przestaje to być metaforyczne. Dosłownie używamy słów, które nie malują obrazów w głowie odbiorcy! Jak sobie z tym poradzić?

Narzędziem, którego powinniśmy użyć, jest coś, co pochodzi zarówno z technik storytellingowych, których uczę, jak i z projektowania doświadczeń (UX design). Mapa empatii. Mapa empatii nakłada na nasz mózg swego rodzaju kaganiec, ograniczając słowa, których chcemy użyć jedynie do doznań zmysłowych. W mapie empatii mamy pytania naprowadzające na te doznania zmysłowe:

- Co widzisz? Zwróć uwagę, że w kwestii tego, co możemy zobaczyć, jest bardzo niewiele prymitywnych kategorii. Możemy zobaczyć kolory (czarny, czerwony), kształty (prostokątny, okrągły) oraz relacje między tymi kształtami. Relacje mogą być statyczne (po lewej stronie, po prawej stronie) albo dynamiczne (przed, za, zbliża się, oddala się).

- Pozostałe pytania z mapy empatii dotyczą kolejnych zmysłów: co słyszysz, co czujesz (w sensie zapachu), jakie to jest w dotyku. Tej części mapy empatii nie używasz bezpośrednio przy generowaniu obrazów, ale tu zwrócę uwagę na dwie sprawy. Po pierwsze: inne doznania zmysłowe mogą pomóc w prompcie przy generowaniu kontekstu. Po drugie: warto się ich nauczyć, bo asystenci wirtualni potrafią o wiele więcej niż tylko generowanie obrazu i posługiwanie się precyzyjnym językiem do opisania np. doznań dotykowych pozwoli na lepsze identyfikowanie przedmiotów dla ludzi z wadami wzroku, doskonale przydaje się też w edukacji do multizmysłowej nauki.

Ignorowanie rekomendacji AI

Porozmawiajmy teraz o drugim scenariuszu. Asystent AI daje Ci rekomendację, którą Ty… ignorujesz. Bo wiesz lepiej. Wbrew pozorom skłonienie ludzi do zmiany zdania to bardzo ciężka robota. Co zatem wpływa na efektywność przekonywania asystentów AI? Z jednej strony to kwestia programowania tego asystenta, ale z drugiej – i są na to badania – to Twoja osobowość.

Wyobraź sobie, że Twój samolot ląduje w pięknej Austrii. Zaraz po przyjeździe czeka Cię zawód: nie ma kangurów. Co będziesz robić, jeśli nie możesz podziwiać kangurów? Możesz iść… na grzyby. Ale jako turysta niezaznajomiony z tutejszą florą nie potrafisz odróżnić grzybów jadalnych od trujących. Wchodzi apka AI, cała na biało-czerwono (bo zaprojektowana przez austriackich naukowców z Uniwersytetu w Linzu), która może Ci pomóc. Pokazujesz jej grzybek, a ona mówi, czy jest trujący, czy nie.

No i teraz ważna kwestia. AI nie jest nieomylne. A konsekwencją takiej pomyłki, której nie wyłapaliśmy, jest zjedzenie trującego grzyba. Czyli gra toczy się o dość wysoką stawkę. Jak ustawić interakcje, żeby zmaksymalizować efektywność takiej współpracy?

Efektywność rozumiana jako szybsze podejmowanie decyzji oraz lepsze wyłapywanie błędnych rekomendacji od AI. Benedikt Leichtmann, Christina Hummer oraz ich koledzy i koleżanki starali się zbadać dokładnie ten problem. Mieli dwie hipotezy: poprawę efektywności osiągniemy, sprawiając, żeby ludzie lepiej rozumieli, jak działa AI, jak działają algorytmy sortujące, machine learning itp.

No i druga rzecz: kolejnym czynnikiem poprawiającym efektywność jest pokazanie ludziom, jak AI doszła do konkretnej rekomendacji, np. wyświetlając im obrazki innego grzyba, który jest tego samego gatunku. Co się okazało? Technologiczne ogarnięcie nie ma żadnego wpływu na efektywność asystentów AI. To, co jest skorelowane z efektywnością, to właśnie wizualizacja procesu i pokazanie argumentów.

PORADA

Zatem: jeśli chcesz podejmować lepsze decyzje, każ AI tłumaczyć się z rozumowania i powoływać się na źródła. Mój ChatGPT jako jedną z custom commands ma właśnie to: „If I’m asking questions, provide not only the answer, but also the reasoning behind it and link me to the available sources”.

Ale to jeszcze nie koniec. Efektywność Twojego asystenta AI pójdzie do piachu, jeśli będziesz mu za każdym razem zaglądać przez ramię i kwestionować jego decyzje. Skąd to wiemy?

W artykule „The Effects of Trust and Control on Human-AI Collaboration” (Human Factors, 2023) autorzy opisują eksperyment, który zaprojektowali. Ludzie mieli za zadanie sortować zdjęcia przy pomocy asystentów AI. Do badania wprowadzono dwie zmienne.

- Pierwsza to zaufanie: uczestnicy dostawali informację o tym, że asystent AI jest doskonałej jakości albo że jest nędzny w sortowaniu zdjęć. Była też grupa, która dostawała neutralne informacje na ten temat.

- Druga zmienna to poziom kontroli: ludzie mogli sprawdzać i kwestionować decyzje AI, mogli dawać jej sugestie, których AI nie musiała się trzymać albo mogli zostawić AI w spokoju.

Wyniki są bardzo ciekawe: zaufanie do AI jest najlepszym predyktorem efektywności takiego zespołu. Ludzie, którzy ufali rekomendacjom AI oraz decydowali się ją rzadziej kontrolować, osiągali najlepsze wyniki.

Oznacza to, że poprawianie po AI jest często pozbawione sensu. To, że uważamy, że post wygenerowany przez AI jest nędznej jakości, może być tym, co w analizie danych nazywamy „red herring”, czyli czerwony śledź. To taki kawałek w Twoich danych, który być może świeci jasno, ale nie ma wpływu na wyniki. Czyli może się okazać, że post wygenerowany przez AI, który razi Cię stylem, generuje tyle samo lajków, zasięgu, komentarzy co Twój wycyzelowany i wypieszczony wpis. W takim przypadku nie ma sensu poświęcać czasu na to cyzelowanie. Problem w tym, że łatwiej to powiedzieć, niż zrobić. Dlaczego? Bo Twoja osobowość – a konkretnie jeden jej aspekt – ma wpływ na to, jak traktujesz asystentów AI. A żeby o tym porozmawiać, musimy pofatygować się do Londynu.

Siadasz do stołu. Przed Tobą ktoś rozkłada pięć kart zawierających cyfry – na każdej jest cyfra od 1 do 9. Cztery karty widzisz, ale piąta jest zakryta. Twoje zadanie: odgadnąć, czy cyfra na ostatniej karcie jest wyższa, czy niższa od poprzedniej.

Zanim odpowiesz, dostajesz podpowiedź. Część graczy dowiaduje się, że podpowiedź pochodzi od człowieka (poprzedniego gracza) a część – że od asystenta AI. Badacze mierzą dwa parametry: szybkość podjętej decyzji oraz to, czy posłuchasz rady. Na końcu też pytają Cię, jak bardzo ufałeś udzielanym radom. Zastanawiają się, czy większy wpływ na Twoją decyzję ma czynnik zewnętrzny (człowiek lub maszyna), czy jednak osobowość (którą wcześniej przebadali).

W osobowości sprawdzają dwie rzeczy. Pierwsza to tzw. wielka piątka. Opracował ją niderlandzki psycholog Boelle de Raad. Jest jedną z najpopularniejszych metod klasyfikowania osobowości. Składa się z pięciu osi:

- Otwartość – otwartość na nowe informacje lub tendencja do trwania przy swoim.

- Sumienność – zorganizowanie i dążenie do celu lub chaos i wielokierunkowość.

- Ekstrawersja – energia, szukanie dreszczyku emocji lub introwersja, szukanie spokoju.

- Zgodność – przyjazność, chęć niesienia pomocy lub antagonizm, wrogość.

- Neurotyczność – wahania nastroju czy raczej stabilność.

Drugą rzeczą, którą sprawdzają badacze, jest coś, co nazywa się w psychologii Locus of Control. Po naszemu mówimy o wewnątrzsterowności lub zewnątrzsterowności. Ludzie wewnątrzsterowni są przekonani o swojej sprawczości i rzadziej konsultują swoje decyzje z innymi. Zewnątrzsterowni ludzie częściej pytają o radę i mają tendencję do zwalania winy za porażki na czynniki zewnętrzne.

Okazało się, że po pierwsze: podpowiedzi od AI były wykorzystywane częściej niż od byłych graczy. W ankietach po grze gracze twierdzili też, że bardziej ufają podpowiedziom od AI niż od innych graczy. Wniosek tutaj jest jeden: asystenci AI nie muszą ukrywać, że są sztuczną inteligencją. Udawanie człowieka jest kontrproduktywne jeśli chodzi o stosowanie się do rad.

Po drugie: parametry wielkiej piątki praktycznie w ogóle nie miały znaczenia, jeśli chodzi o szybkość i posłuch w interakcjach z AI. Ludzie z otwartą osobowością mieli szybszą reakcję, ale tylko w interakcjach z ludźmi. Z kolei ludzie z bardziej neurotyczną osobowością mniej ufają podpowiedziom, zarówno od ludzi, jak i od AI.

Tym, co miało największy wpływ na wynik, był Locus of Control. Ludzie wewnątrzsterowni mają tendencję do ignorowania podpowiedzi. Zarówno pochodzących od ludzi jak i od AI. Z innych badań wiemy, że ta tendencja wzrasta, jeśli ludzie uważają się za ekspertów w danej dziedzinie.

I teraz zaskakujący wniosek: jeśli jesteś specjalistą od marketingu i używasz asystenta AI, który pomaga Ci w marketingu, będzie on mniej efektywny od asystenta, który pomaga Ci np. w rozpoznawaniu grzybów (czyli w rzeczy, na której się nie znasz). Prowadzi to do ostatecznego wniosku: asystenci AI są bardziej skuteczni, kiedy im ufamy.

Ale jak możemy im ufać, kiedy nie słuchamy ich racjonalnych argumentów? Musimy iść nieracjonalną ścieżką i ich polubić. Zatem: jeśli już ustawiasz sobie parametry Twojego Chata GPT albo projektujesz takich asystentów dla innych ludzi, zadbaj o warstwę emocjonalną. Co łatwiej powiedzieć niż zrobić, bo prosty prompt typu „Be Cheerful in your answers” działa, kiedy mam dobry humor, ale wkurza mnie, kiedy próbuję rozwiązać poważniejszy problem. Zwłaszcza, że AI potrafi już dziś nie tylko odczytywać, ale także udawać emocje lub dostosowywać się do emocji użytkownika.

I teraz wyobraź sobie, że asystent AI nie tylko wie, jaką potrawę powinieneś przygotować, żeby goście nie wyrzucili jej do kosza, nie tylko wie, który grzyb jest trujący, ale ponieważ mówi Ci to w taki sposób, że odbija stan emocjonalny, w którym jesteś, będziesz bardziej skłonny go posłuchać. A Ty z kolei masz język i nawyki, dzięki którym taki asystent jest o wiele bardziej efektywny.

11 min

11 min

Warszawa

Warszawa

Przypominamy, że wielkimi krokami zbliża się konferencja I ♥ Marketing & Technology, która odbędzie się już 29–30 października 2025 roku.

Zapoznaj się także z ofertą organizowanych przez nas szkoleń z zakresu marketingu.