Kiedy myślimy o strategii link building, rzadko skupiamy się na tym, czym już dysponujemy. Chętniej zwracamy się w stronę blogów, widgetów czy innych technik pozyskiwania linków. Często nie wiemy, że praktycznie pod nosem mamy przynajmniej kilka dodatkowych linków, dostępnych ot tak. Szczególnie jeśli mówimy o witrynach które mają za sobą kilkuletnią historię. Wobec powyższego, rozejrzyjmy się dookoła.

Postawmy następującą hipotezę:

Jeśli dana witryna WWW istnieje wystarczająco długo, to czy w jej profilu linków mogą występować takie strony, które w skutek zmian na przestrzeni lat przestały dostarczać link juice serwując w zamian STATUS CODE 4xx?

Dla opisania naszej metody posłużmy się stroną http://SprawnyMarketing.pl.

Następnie wykonamy kilka czynności podzielonych na cztery kroki, które to pozwolą nam odpowiedzieć na postawione wcześniej pytanie.

KROK 1:

Zaczynamy od sprawdzenia linków przy użyciu MajesticSEO.com (fresh index).

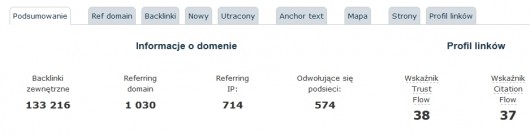

SprawnyMarketing.pl posiada 133,216 linków z 1,030 różnych domen (714 różnych numerów IP).

KROK 2:

W kolejnym kroku musimy stworzyć raport zaawansowany. Po wygenerowaniu pliku CSV o wielkości prawie 50 MB (spakowany do .gz) możemy przejść do kroku kolejnego tj. analizy.

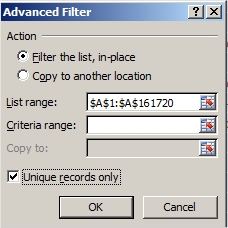

Otwórzmy więc plik w Excel’u i zajmijmy się pierwszą kolumną czyli „Target URL”. Kolumna ta zawiera URL linka w domenie SprawnyMarketing.pl. W tym miejscu musimy odpowiedzieć sobie na pytanie ile unikalnych adresów URL znajduje się w tej analizowanej przez nas kolumnie. Najprostrzym sposobem jest skopiowanie całej kolumny A do nowego arkusza a następnie odfiltrowanie (jak na ilustracji).

Po wykonaniu filtrowania możemy dowiedzieć się następującej rzeczy.

Profil strony SprawnyMarketing.pl posiada wspomniane wcześniej 133,216 linków z 1,030

różnych domen (należących do 714 różnych numerów IP) które to linki prowadzą do 1,035 stron

w domenie SprawnyMarketing.pl

KROK 3:

Teraz kopiujemy odfiltrowane do pliku txt (odfiltrowane URLe znajdziesz w arkuszu UniqueTargetURL) i zapisujemy jako Sprawny.txt. Plik ten będzie plikiem wsadowym do pracy z programem ScreamingFrog. Program ten to nic innego jak zaawansowany crawler zainstalowany na lokalnej maszynie. Nadaje się perfekcyjnie do przeskanowania małych i średnich stron WWW. Przy dużych niestety może mu brakować zasobów (wtedy poleciłbym bardziej zaawansowane narzędzia jak choćby DeepCrawl).

Pytanie na które szukamy odpowiedzi jest następujące:

Ile z 1,035 stron w domenie SprawnyMarketing.pl do których prowadzą linki zwraca status 4xx?

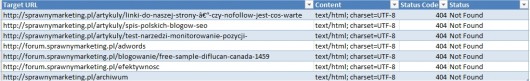

Ładujemy listę Sprawny.txt, ustawiamy Mode > List. Oznacza to nic więcej jak to że chcemy brać pod uwagę wyłącznie zawartość pliku a nie domeny jako takiej. Następnie klikamy Start. Po chwili otrzymamy naszą listę URLi plus wiele przydatnych informacji. My skupimy się w tym artykule nad kolumnami Status Code i Status. Teraz jesteśmy w stanie zauważyć że 7 stron w domenie SprawnyMarketing.pl posiada linki przychodzące ale zwraca Status Code 404 NOT FOUND.

I tutaj moglibyśmy skończyć nasze rozważania, wykonując klasycznie 301 PERMANENT REDIRECTION. Jednak przypuszczam że wielu z Was chciałoby wiedzieć co to są za linki. Mnie osobiście ciekawość nie pozwala zakończyć procesu na tym etapie dlatego…

KROK 4.

Kopiujemy 7 wynikowych URLi których status code to 404 z programu ScreamingFrog do nowego arkusza w Excelu.

Następnie wracamy do pliku CSV z MajesticSEO. Dodajemy kolumnę B w której to wykonujemy prosty VLOOKUP (wyszukaj.pionowo) w następujący sposób.

=VLOOKUP(A:A,’404SprawnyMarketing’!A:D,3,FALSE)

W dokumencie Excel SprawnyMarketing, który dołączam do artykułu, znajdziesz opisany proces w arkuszu MajesticSEOSelective

Dodatkowo możemy pokusić się o ekstrakcje domen kolumny E używając następującej funkcji (za myspotinternetmarketing.com) (SUBSTITUTE = PODSTAW; REPLACE = ZASTĄP; FIND = ZNAJDŹ; ISERROR = CZY.BŁĄD; LEN = DŁ)

=IF($E2=””,””,SUBSTITUTE(IF(ISERROR(FIND(„https://”,$E2)),SUBSTITUTE(IF(ISERROR(FIND(„/”,SUBSTITUTE($E2,”http://”,””))),$E2,REPLACE($

E2,FIND(„/”,SUBSTITUTE($E2,”http://”,””))+7,LEN($E2)+1,””)),”http://”,””),SUBSTITUTE(IF(ISERROR(FIND(„/”,SUBSTITUTE($E2,”https://”,””))),$

E2,REPLACE($E2,FIND(„/”,SUBSTITUTE($E2,”https://”,””))+8,LEN($E2)+1,””)),”https://”,””)),”www.”,””))

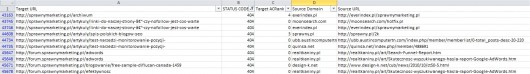

Następnie używając kolumny B należy odfiltrować wszystkie #N/A (czyli takie URL których status jest inny niż 403) pozostawiając wyłącznie te ktore zawieraja w STATUS CODE 404. Oto co otrzymamy:

Skupiłbym się na ostatnich czterech a własciwie trzech jako że pierwszy występuje dwukrotnie. Są to:

- , który przekierowałbym na 301 (np. używajac .htaccess): http://forum.sprawnymarketing.pl/google-adwords-inne-platformy/

- , który przekierowałbym na 301 (np. używajac .htaccess): http://forum.sprawnymarketing.pl/blogowanie/

- http://forum.sprawnymarketing.pl/efektywnosc, który przekierowalbym na 301 (np. używajac .htaccess): http://forum.sprawnymarketing.pl/efektywnosc-reklamy-jak-mierzyc/

Dzięki temu można uzyskać dodatkowy linkjuice (jak wspomniałem wcześniej) „nie wychodząc z domu”. Ale trzeba też uważać co się przekierowuje gdyż niektóre URLe mogą celowo zwracać status code 403 lub 404 jako rezultat otrzymywania linków ze stron niskiej jakości. Szczególnie jeśli jest to 403 – zwykle celowo stawiany na tych URLach których życie definitywnie chcemy zakończyć.

Dzięki tej metodzie możecie wychwycić URLe z błędami do których prowadzą linki np.

- literówki w URL’ach – te można łatwo przekierować,

- znaki niedozwolone jak naprzykład „*” – tutaj będzie trudniej,

- błędy w subdomenach takie jak ww.example.com / w.example.com – też można próbować przekierować.

Opisany w artykule jest jedynie przykład pokazujący metodę. Celowo użyłem SprawnyMarketing.pl aby ilość danych nie przygniatała. Dla ciekawych proponowałbym powtórzyć metode dla stron takich jak CNN.com albo Facebook.com. Napiszcie od siebie, co o tym myślicie?

4 min

4 min

Warszawa

Warszawa

Przypominamy, że wielkimi krokami zbliża się konferencja I ♥ Marketing & Technology, która odbędzie się już 29–30 października 2025 roku.

Zapoznaj się także z ofertą organizowanych przez nas szkoleń z zakresu marketingu.

Proponuję połączyć powyższą metodę z możliwością śledzenia stron błędu 404 z GA. Łącząc te dwie metody można nie tylko odzyskać linki, ale dodatkowo szybciej wyłapywać i przekierowywać użytkowników do treści których poszukują.

Screaming Frog – bardzo przydatny :)

Dobra technika, szczególnie przydatna przy przejęciu nowego dużego klienta lub po większych zmianach na stronie. Dla małej strony z historią też się sprawdzi.

Warto dopisać, że inne kody błędów niż 404 też są godne sprawdzenia i poprawki lub przekierowania 301.

Dokładnie, dla strony firmowej np. z 5 podstronami to szkoda zachodu :P

@Gogler – czy szkoda zachodu to raczej nie, ale można to zrobić bez większej analizy „od ręki”. Czasem okazuje się, że mała strona miała jakąś podstronę z dużą ilością BL i wtedy żeby nie tracić to 301.

lepiej strony uśmiercać 410 zamiast 403 :-)

W przypadku serwisu opartego na WP warto zainstalować wtyczkę Redirection – wiele rzeczy zrobi za nas, no i ominie nas analiza Excela :)

Ciekawa metoda, jednak przy nowych serwisach, które dopiero powstały i dopiero zaczynają zbierać linki raczej się nie sprawdzi.

Warto jednak o niej pamiętać i wykorzystać, gdy liczba linków urośnie.

Jak sie chce to sie zrobi

Zasadniczo można też zobaczyć błędy w GWT i te strony przekierować sobie na istniejące.

Przydatne informacje, dziękuję!

Bardzo ciekawy i przydatny artykuł. Strona jednak musi mieć już pewną bazę linków. Sposób na pewno przydatny przy serwisach z większą ilością linków, jednak wart uwagi nawet dla dopiero rozwijających się stron – tak „na przyszłość”.

a dzisiaj jednak webme…. wymiata cenowo i jakosciowo konkurencje. moz dobry ale jak sie ma adres klienta z usa.

A co myslicie o brokenlinks buildingu – skuteczne czy nie?