Nowości w SEO za okres wrzesień-grudzień 2020

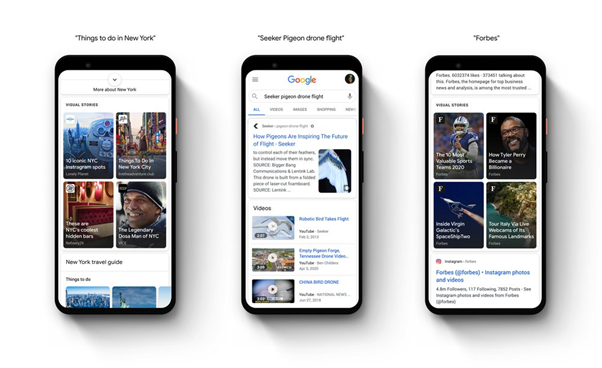

1. Google wprowadza „Web Stories” do Google Discover

Na początku października Google uruchomił tę usługę w kilku testowych krajach – w USA, Indiach oraz Brazylii. Jest to funkcja bardzo podobna w obsłudze do stories z Instagrama czy Facebooka: pozwala „serwować” użytkownikom wizualny i wciągający content.

Docelowo Google planuje wdrażać stories do większej liczby swoich produktów – już teraz oprócz Google Discover możemy znaleźć je w organicznych wynikach. Stories to kolejne tego typu miejsce (po np. wspomnianym Google Discover) dla wydawców, do pozyskiwania dodatkowego ruchu organicznego.

Oprócz wprowadzenia nowej funkcjonalności, Google odsyła nas też do kilku narzędzi, które mogą być przydatne w tworzeniu stories. Są to: wp.stories.google (wtyczka do WordPressa), makestories.io oraz nws.ai).

2. Algorytm BERT a anglojęzyczne zapytania

Algorytm BERT – o którym pisaliśmy w poprzednich wydaniach – i który ma za zadanie lepsze pojęcie kontekstu zapytania, jakie użytkownik kieruje do Google’a, działa już przy prawie wszystkich angielskojęzycznych zapytaniach.

3. Problemy z indeksacją podstron w wyszukiwarce Google

Google potwierdza problemy z indeksacją podstron w swojej wyszukiwarce. Pierwszy problem dotyczył wyników mobilnych, a drugi był związany z adresami kanonicznymi (rel=canonical). Pracownik Google’a, Danny Sullivan, na swoim Twitterze potwierdził problem – a tym samym tymczasowy przestój w indeksacji i aktualizacji podstron w Google’u.

Pozytywny aspekt tej sytuacji póki co jest taki, że Google zdaje sobie już sprawę z powagi sytuacji i pracuje nad rozwiązaniem.

4. Indeksowanie witryn za pośrednictwem protokołu HTTP/2

Od listopada 2020 r. Googlebot rozpoczął indeksowanie niektórych witryn za pośrednictwem protokołu HTTP/2. Protokół HTTP/2 jest znacznie bardziej niezawodny, wydajniejszy i szybszy niż jego poprzednik, ze względu na swoją architekturę i funkcje, które implementuje dla klientów (np. przeglądarki) i serwerów.

Googlebot sam zadecyduje, którą witrynę zaindeksować przez HTTP/2 – jeśli Twój serwer obsługuje H2, a Googlebot indeksuje już dużo z Twojej witryny, możesz już kwalifikować się do uaktualnienia połączenia – w takim przypadku nie będziesz musiał już nic robić.

5. Koniec z nieprzystosowaniem stron do urządzeń mobilnych

Marzec 2021 to potwierdzana przez Google’a data, po której wyszukiwarka wyrzuci ze swojego indeksu wszystkie strony, które nie są przystosowane do urządzeń mobilnych. Co więcej – wszystkie zasoby z takich stron, m.in. zdjęcia, zostaną usunięte z indeksu. Jeśli Twoja strona, lub jej część, nadal nie jest przystosowana do mobile-first indexing, to najwyższy czas się tym zająć!

6. Nowe sygnały w wyszukiwarce Google

Google ogłosił w maju uruchomienie nowych sygnałów w swojej wyszukiwarce. Teraz gigant poinformował, że zaproponowane wcześniej rozwiązanie o nazwie Page Experience Signals zostanie uwzględnione w algorytmach w maju 2021 roku. Warto zatem do tego czasu przygotować swoje witryny pod wskazane sygnały Google.

Page Expireince Signals będzie stanowiło połączenie przedstawionych kilka miesięcy temu Core Web Vitals i poprzednich sygnałów związanych z UX.

7. Testy nowych etykiet

Google zapowiedział przeprowadzenie testu z nowymi etykietami w wynikach wyszukiwania. Ma się na nich pojawić wskaźnik, który wyróżni strony zapewniające doskonałą jakość strony. Jest to bezpośrednie nawiązanie do informacji o sygnałach Page Expierience.

W ten sposób Google dodatkowo zachęca webmasterów do uwzględniania nowych czynników. Oznaczenie strony w wynikach wyszukiwania złą etykietą prawdopodobnie odbije się negatywnie na CTR oraz ruchu organicznym.

8. Zmiana nazwy bloga Google

Google zmienił nazwę swojego bloga z Google Webmasters na Google Search Central. Jednocześnie strona została przeniesiona z adresu: https://webmasters.googleblog.com na adres: https://developers.google.com/search/blog/.

Nowości w SEO za okres kwiecień-sierpień 2020

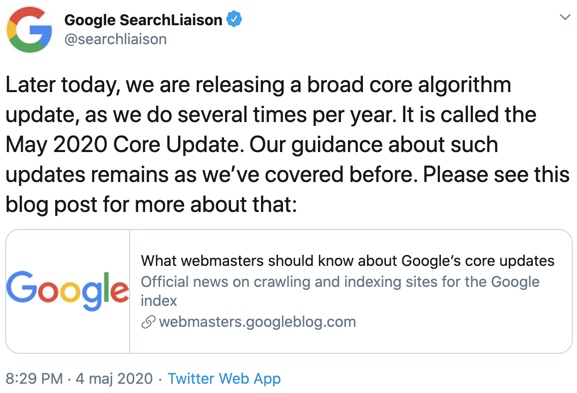

1. Nowy update algorytmu Google

Google zapowiedział kolejną w tym roku dużą aktualizację. Jej wdrażanie trwało w przybliżeniu dwa tygodnie, a efekty mocno wpłynęły na ranking wielu podstron w wynikach wyszukiwania. W ostatnim czasie była to jedna z większych zmian w algorytmie Google’a.

2. Forum Google dla webmasterów – powrót polskiej wersji

Google przywrócił możliwość współpracy społeczności webmasterów na swoim oficjalnym forum w języku polskim. W założeniu ma to być miejsce, gdzie rozwiązuje się problemy dotyczące funkcjonowania narzędzi Google i odpowiada na pytania użytkowników. Osoby z największą wiedzą mogą dołączyć do programu Ekspertów Produktowych Google.

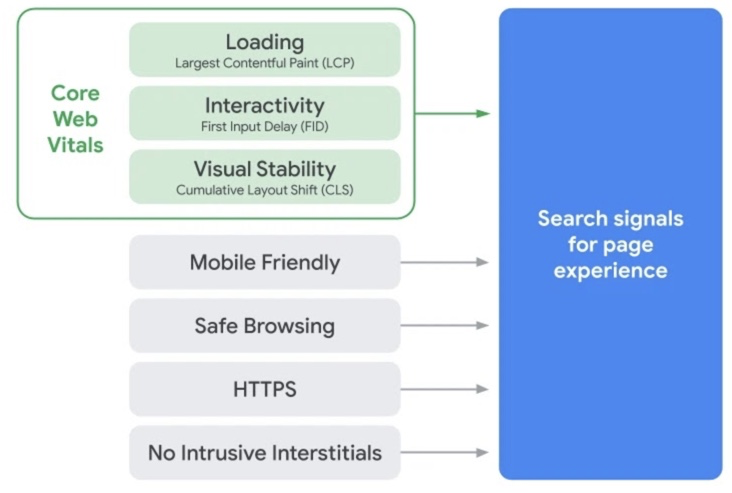

3. Page Experience Ranking

Google wprowadza nową inicjatywę „Web Vitals”, której celem jest zapewnienie ujednoliconych wskazówek dotyczących jakości stron (Core Web Vitals). Zdaniem Google’a są one niezbędne do zapewnienia użytkownikom komfortu. Core Web Vitals składa się z 3 głównych sygnałów:

- wydajność strony, która powinna mieścić się w granicach 2,5 sekundy (Largest Contentful Paint – LCP),

- czas ładowania do pierwszej interakcji na stronie (First Input Delay – FID),

- stabilność wizualna, która informuje o zgodności wyświetlania strony na różnych urządzeniach (Cumulative Layout Shift – CLS).

Na całościowy ranking strony składają się jeszcze stare i dobrze znane czynniki, takie jak: użyteczność mobilna, bezpieczeństwo i HTTPS.

4. Narzędzie Rich Results wychodzi z wersji beta

Narzędzie do testowania uporządkowanych danych zostaje wycofywane przez zespół Google. W jego miejsce wchodzi Test elementów rozszerzonych. Głównymi zaletami nowego narzędzia jest to, że pokazuje ono, które ulepszenia są ważne dla zastosowanego znacznika, lepiej obsługuje dynamiczne ładowanie strukturalne, renderuje wyniki dla wersji mobilnej i stacjonarnej oraz jest dostosowane do raportów Search Console.

Nowości w SEO za okres styczeń-marzec 2020

1. Google otwiera kanał Google Webmasters na YouTube

Najnowsze aktualizacje i wiadomości dotyczące wyszukiwarki Google można sprawdzać na oficjalnym kanale YouTube – Google Webmasters. Będą się pojawiać cyklicznie, co miesiąc. Cała seria przyjęła nazwę Google Search News.

2. Removals – nowy raport w Search Console

W Search Console pojawił się nowy moduł – Removals, który umożliwia właścicielom witryn tymczasowe ukrycie strony przed wyświetlaniem w wynikach wyszukiwania w Google. Nowy raport zawiera także informacje o stronach, które zostały zgłoszone za pośrednictwem innych publicznych narzędzi Google’a.

Narzędzie podzielone jest na trzy główne sekcje:

- tymczasowe usunięcia – ukryje adres URL w wynikach wyszukiwania Google na około sześć miesięcy i wyczyści kopię strony w Google. Istnieje możliwość wyczyszczenia tylko kopii strony w Google na czas ponownej indeksacji;

- nieaktualna treść – zawiera informacje o żądaniach usunięcia złożonych za pośrednictwem publicznego narzędzia Remove Outdated Content;

- filtrowanie SafeSearch – pokazuje historię stron w Twojej witrynie, które zostały zgłoszone przez użytkowników Google jako treści dla dorosłych za pomocą narzędzia Sugestia SafeSearch.

3. Przebudowa panelu wiadomości w Search Console

Od teraz wiadomości będą dostępne za pośrednictwem panelu, do którego można łatwo uzyskać dostęp, klikając ikonę dzwonka u góry dowolnej strony w Search Console. Główną różnicą w stosunku do starego interfejsu jest to, że teraz będziesz mieć dostęp do swoich wiadomości w całym produkcie, bez konieczności opuszczania raportów.

4. Nowa dokumentacja dotycząca mobile-first indexing

Google zaktualizowało swoją dokumentację najlepszych praktyk dotyczących indeksowania na urządzeniach mobilnych o znaczną ilość dodatkowych informacji. Dokument ma pomóc właścicielom witryn w dostarczaniu użytkownikom jak najlepszych wrażeń, niezależnie od tego, czy korzystają z witryny na urządzeniu mobilnym czy stacjonarnym.

5. Dalszy rozwój aktualizacji BERT

W ostatnim numerze informowaliśmy o dużej aktualizacji nazwanej BERT. 9 grudnia 2019 roku pojawiła się informacja o dalszym rozwoju BERT, który wdrażany jest dla kolejnych 70 języków (w tym oczywiście dla języka polskiego).

6. Aktualizacja algorytmu Core Uptade

W styczniu została ogłoszona kolejna duża aktualizacja algorytmu, tzw. Core Update. Tego typu duże aktualizacje mają miejsce kilka razy w roku i w głównej mierze dotyczą oceny jakości treści na stronie.

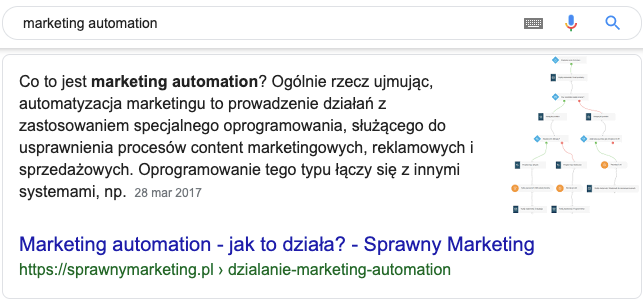

7. Zmiany w SERP-ach

W ostatnim czasie Google testuje kombinacje różnych widoków w wynikach wyszukiwania. Zmienia kolory, miejsce wyświetlania adresu URL, podkreśla favicony, zmienił też sposób wyświetlania stron znajdujących się w featured snippets.

Featured snippet to tzw. pozycja zero i bezpośrednia odpowiedź na wpisaną przez użytkownika frazę:

Obecnie jeśli strona wyświetla się w featured snippets, to nie ma już możliwości na ponowne wyświetlenie się w TOP 10.

Nowości w SEO za okres październik-grudzień 2019

1. Aktualizacja algorytmu Google: „BERT”

„BERT” (Bidirectional Encoder Representations from Transformers) to najnowsza aktualizacja w algorytmie Google, której głównym celem jest lepsze zrozumienie kontekstu zapytań, dzięki uczeniu maszynowemu opartemu na sieci neuronowej.

W pierwszej kolejności aktualizacja będzie dotyczyć zapytań w języku angielskim, a swoim zasięgiem obejmie 10% zapytań, przede wszystkim tych mocno rozbudowanych z tzw. „długiego ogona”.

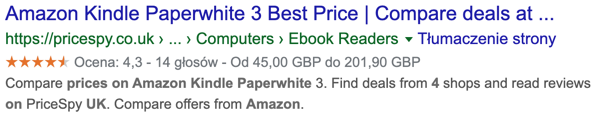

2. Nowe raportowanie wyników produktów w Google Search Console

W narzędziu Search Console pojawiły się nowe widoki raportów. Pierwszy z nich dotyczy wyszukiwania w raporcie skuteczności na temat statystyk danych uporządkowanych dla produktów.

Raport skuteczności Google Search Console zawiera kluczowe dane, takie jak kliknięcia i wyświetlenia, które pomagają webmasterom zrozumieć i zoptymalizować wyniki witryn w wyszukiwarce Google. Dane te można dodatkowo podzielić na segmenty według urządzenia, położenia geograficznego i zapytań.

Drugi raport dotyczy szybkości działania stron. Czas ładowania stron już od dłuższego czasu ma znaczenie nie tylko behawioralne (użytkownik nie zamierza długo czekać na załadowanie się strony), jest także czynnikiem rankingowym dla robotów Google’a.

Raport klasyfikuje adresy URL pod względem prędkości oraz problemu, który powoduje wszelkie spowolnienia. Aby łatwiej było zrozumieć, jaki rodzaj optymalizacji można przeprowadzić dla określonego adresu URL, raport zawiera odsyłacz do narzędzia PageSpeed Insight, które dostarcza informacji o konkretnych możliwościach optymalizacji.

3. Oficjalna wtyczka Google dla stron opartych na WordPressie

Site Kit to oficjalna i prosta w instalacji wtyczka Google dla stron opartych na WordPressie. Pozwala ona szybko sprawdzić, w jaki sposób ludzie znajdują Twoją witrynę, a następnie z niej korzystają. Dzięki dostarczonym informacjom dowiesz się, jak ulepszać i zarabiać na swoich treściach. Dane pobierane są z następujących narzędzi Google’a:

- Search Console,

- Analytics,

- PageSpeed Insights,

- AdSense.

Wszystkie dane dostępne są bezpośrednio w panelu administracyjnym WordPressa. Więcej informacji na oficjalnej stronie Site Kit.

4. Dwa nowe atrybuty linków

Google – oprócz dwóch standardowych oznaczeń, czyli dofollow (atrybut domyślny) oraz nofollow – wprowadził kolejne dwa nowe atrybuty:

- rel=„sponsored” – służy do oznaczania w witrynie adresów URL, które zostały utworzone w ramach reklam, sponsoringu lub innych umów kompensacyjnych.

- rel=„ugc” – ugc to oznaczenie treści generowanej przez użytkownika. Stosowanie wartości atrybutu ugc jest zalecane przy linkach do treści generowanych przez użytkowników, takich jak komentarze i posty na forum.

Atrybut nofollow pozostanie dla linków, które powinny być ignorowane przez roboty Google’a, ale nie zawierają się w kryteriach „sponsored” oraz „ugc”. Nowe atrybuty będą uwzględniane przez roboty Google’a dopiero od 1 marca 2020 r.

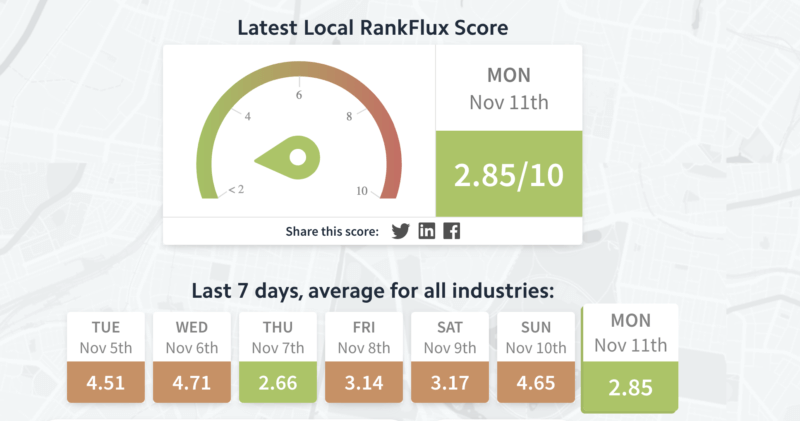

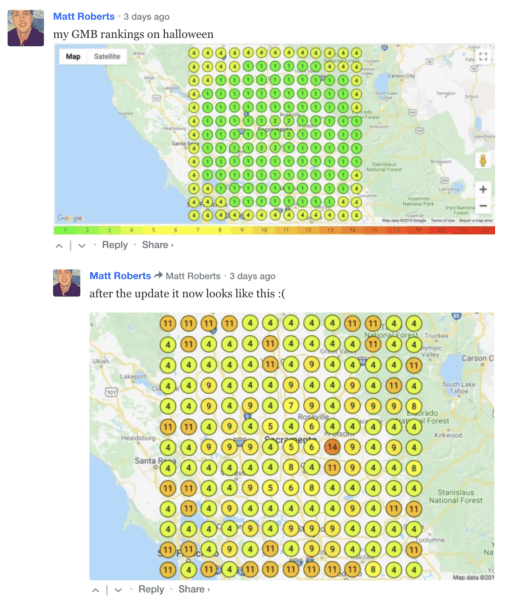

5. Aktualizacja algorytmu „Possum”

Algorytm o nazwie „Possum” odpowiada za wyświetlanie lokalnych wyników wyszukiwania i to właśnie te wyniki zanotowały duże zmiany w pierwszej połowie listopada. Wiąże się to z wprowadzeniem przez Google wersji „Possum 2.0”.

Wstępne analizy i pojedyncze case’y wskazują, że główną zmianą jest jeszcze lepsze dopasowanie wyników lokalnych do lokalizacji, z której wysłano zapytanie do Google’a. Poniżej konkretny przykład od jednego z SEO-wców: pierwszy screen pokazuje pozycje wizytówki na początku listopada, druga mapa – w okolicy 10 listopada.

Warto jeszcze zacytować jedną z wypowiedzi specjalistów od lokalnego SEO:

„Właśnie próbowałem porównać dane z 17 października z nowymi danymi, które dopiero co ściągnąłem. Wcześniej średnia odległość między lokalizacją wyszukiwania a wynikami w pakiecie lokalnym wynosiła 9,98 mil, teraz jest to 4,87 mil” – powiedział Matthew Summers.

Są to oczywiście wstępne analizy nowej aktualizacji algorytmu „Possum”, jednak nie da się ukryć, że aktualizacja ta z pewnością sporo namieszała w wynikach lokalnych, a Google po raz kolejny pokazuje, że stara się tak dostosować wyniki wyszukiwania, aby były one jak najbardziej użyteczne. Dajcie znać, jak to u Was wygląda. Może macie zupełnie inne spostrzeżenia?

Nowości w SEO za okres lipiec-wrzesień 2019

1. Ponad 50% wyszukiwań w Google nie kończy się kliknięciem w żaden wynik

Ponad połowa zapytań w wyszukiwarce Google kończy się na poziomie SERP-ów! W czerwcu 2019 r. po raz pierwszy w historii większość zapytań w Google’u należała do tzw. „Zero-Click Searches”. Oznacza to, że podczas wyszukiwania w Google’u użytkownik nie przeszedł na żadną ze stron. Estymacja została wykonana przez firmę Jumpshot oraz opracowana przez samego Randa Fishkina (były właściciel Moz) ze SparkToro. Dane dotyczą rynku USA i zostały opracowane na podstawie 40mln zapytań desktopowych.

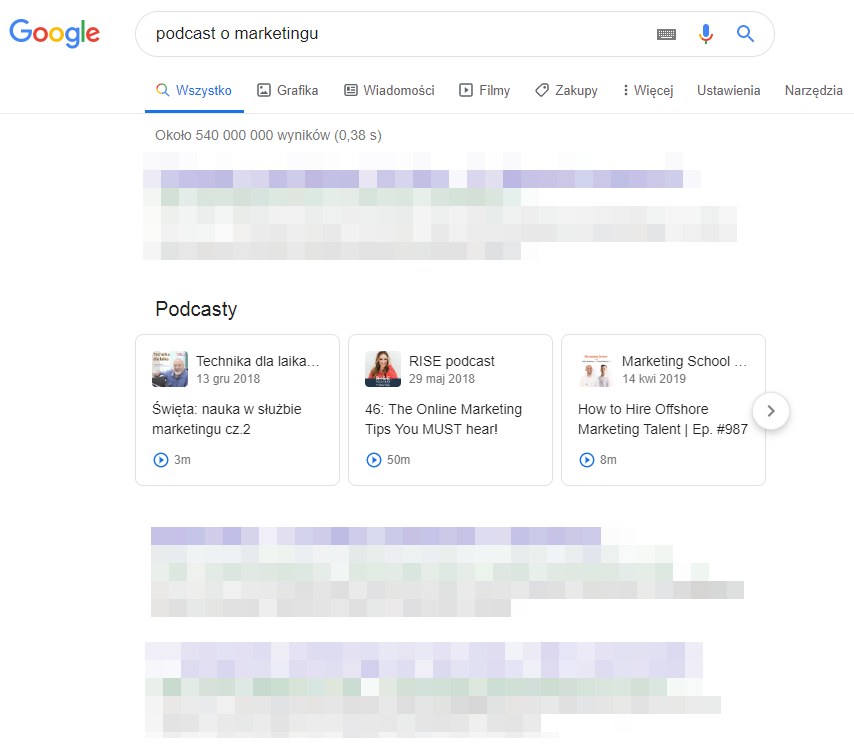

2. Słuchanie podcastów bezpośrednio z wyników wyszukiwania Google

Na początku sierpnia Google poinformował na swoim blogu, że zarówno na desktopie jak i na urządzeniach mobilnych, podcastów będziemy mogli słuchać bezpośrednio z poziomu wyszukiwarki. Co więcej, Google będzie je wyświetlać na podstawie tego, o czym jest w nich mowa. Oznacza to, że Google będzie indeksować słowa wypowiedziane w podcaście i na ich podstawie wyświetlane będą propozycje na SERP-ach. Google potwierdził również, że pod koniec roku podcasty będą dostępne z poziomu asystenta Google’a: pytając o podcast na dany temat, dostaniesz propozycje podcastów powiązanych z interesującym Cię tematem. Jeśli w strategii SEO swojej firmy nie uwzględniasz jeszcze podcastów, to może czas to zmienić?

3. Zmiana wyglądu wyników graficznych w Google

Po testach różnych wyglądów wyników graficznych, Google zaprezentował wersję, która zostanie z nami na dłużej. Aktualnie wybrana grafika i informacje o niej wyświetlać się będą z prawej strony.

Jeśli jeszcze tego nie zrobiłeś, sprawdź, co stało się z Twoim ruchem organicznym z grafiki: zwiększył się czy zmniejszył po takiej zmianie?

4. Google przestaje wspierać noindex w robots.txt

1 września Google poinformował, że przestaje wspierać m.in. dyrektywę noindex w pliku robots.txt. Google tłumaczy, że dla zachowania zdrowego ekosystemu i przygotowania się do potencjalnego przyszłego wdrożenia rozwiązania open source’owego, rezygnuje z obsługiwania nieopublikowanych i niewspieranych reguł (takich jak m.in. noindex) w plikach robots.txt. Dodaje również, że osoby, które korzystały z tego rozwiązania, mogą sięgnąć po inne, alternatywne sposoby na zapanowanie nad crawlowaniem / indeksowaniem treści.

5. Zmiana wyglądu wyników w zakładce „Wiadomości” (News)

Google potwierdził w lipcu tego roku, że wdraża stopniowo nowy wygląd wyświetlania wyników wyszukiwania, tym razem w sekcji „Wiadomości” (News).

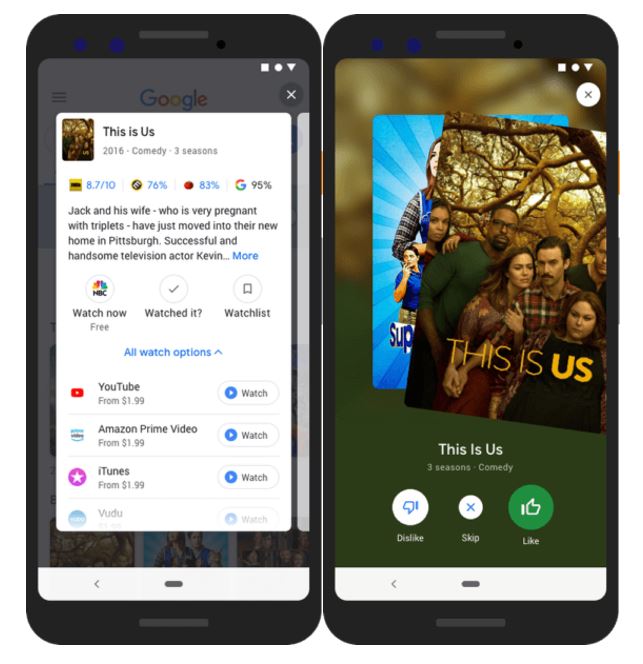

6. Nowe dane strukturalne – karuzela z filmami

Google na początku września poinformował na Twitterze, że wprowadził nowy rodzaj danych strukturalnych, które umożliwią wyświetlanie informacji o filmach w karuzeli w wynikach mobilnych. Informacje prezentowane są w taki sposób:

Nowości w SEO za okres kwiecień-czerwiec 2019

1. Googlebot oparty na nowym silniku

Roboty Google’a, odwiedzając strony internetowe, do tej pory wykorzystywały do renderowania przestarzałą przeglądarkę Chrome w wersji 41. Doszło do mocno wyczekiwanej zmiany – Googlebot funkcjonuje w oparciu o Chrominium w obecnie najnowszej wersji, czyli 74. Co więcej, Googlebot będzie regularnie aktualizował swój silnik renderujący, aby zapewnić obsługę najnowszych funkcji i technologii wykorzystywanych przy budowie stron internetowych. Do tej pory przestarzała przeglądarka, z jakiej korzystały roboty Google’a, oznaczała brak wsparcia większości nowoczesnych technologii, w tym m.in. problem z obsługą JavaScriptu.

W porównaniu z poprzednią wersją Googlebot obsługuje teraz ponad 1000 więcej nowych funkcji, takich jak:

- ES6 i nowsze funkcje JavaScript,

- IntersectionObserver do leniwego ładowania,

- interfejsy API składników sieci Web v1.

2. Nowy raport na temat szybkości w Search Console

Podczas konferencji Google I/O otrzymaliśmy informację o nowym raporcie szybkości w Search Console. Obecnie jest w trybie beta lub eksperymentalnym i tylko niewielka liczba osób ma do niego dostęp. Raport daje zagregowany widok danych dotyczących witryny, w którym można przejść do określonych problemów i zobaczyć konkretne przykłady adresów URL.

3. Kolejny krok Google’a w promowaniu urządzeń mobilnych

Dla wszystkich nowych podstron od dnia 1 lipca 2019 r. będzie obowiązywał domyślny sposób indeksacji zwany Mobile-First Index. Oznacza to, że dostosowanie nowych stron pod urządzenia mobilne będzie jednym z kluczowych czynników. Co w przypadku już istniejących serwisów? Wszystkie strony, które nie otrzymały stosownego komunikatu, wciąż będą indeksowane „w starym” stylu. Jeżeli jesteś na etapie wdrażania strony lub w Search Console pojawił się komunikat dotyczący przejścia na Mobile-First Index, to zachęcamy do sprawdzenia porad dotyczących optymalizacji strony na urządzenia mobilne.

4. Aktualizacja algorytmu „The June 2019 Core Update”

Google pierwszy raz w historii ogłosił z wyprzedzeniem (jednodniowym, ale zawsze ) aktualizację swojego algorytmu. Większe zmiany w algorytmie Google wypuszcza średnio kilka razy do roku, ale nie zapominajmy, że Google prawie codziennie dokonuje chociażby małych poprawek. Jest dość wcześnie, żeby wysuwać pochopne wnioski, ale już pierwsze dane pokazują, że po raz kolejny spore zmiany można zaobserwować w obszarze zdrowia oraz finansów (obszar YMYL – Your Money Your Life). Bardzo duże zawirowania miały miejsce również w obszarze hazardu, na razie największe z wymienionych branż. Wstępną analizę (5 czerwca 2019 r.) zmienności wyników organicznych przygotowała platforma Rank Ranger. Pamiętajmy, że są to bardzo wstępne analizy, a zmiany w organicznych wynikach z pewnością będą jeszcze następowały.

5. Paginacja rel=next i rel=prev

Google przestał obsługiwać znacznik rel = next / prev, który został uruchomiony w 2011 r. Ciekawe jest to, że Google nie wspierał go od kilku lat, o czym wcześniej nie informował! Co to jest rel = next / prev? Rel = next / prev to znaczniki, które służyły do oznaczania kolejności podstron w paginacji (od pierwszej do ostatniej).

W marcu br. jeden z pracowników (John Muller) przyznał na Twitterze, że znaczniki, pomimo sugerowania w oficjalnym poradniku Google’a, nie były wspierane już od kilku lat. Czy coś powinniśmy zmieniać w obrębie naszej witryny w związku z tą informacją? Jeżeli nie obserwowaliśmy w wynikach wyszukiwania czy logach serwera problemów z indeksacją i odwiedzinami przez roboty Google’a to nie ma konieczności przeprowadzania żadnych zmian.

6. Rozbudowa wyników wyszukiwania

Materiały w formie podcastów pomimo tego, że nie są niczym nowym, to obecnie przeżywają duży wzrost popularności. W najbliższym czasie będziemy mogli wyszukiwać i odtwarzać podcasty bezpośrednio w wyszukiwarce Google na urządzeniach z Androidem, iOS i przeglądarce komputerowej. Po wybraniu w wynikach wyszukiwania opcji wyświetlania większej ilości podcastów zostaniemy przeniesieni do interfejsu Google Podcast.

7. Google 3D i AR

Google powiększy wyniki wyszukiwania, wprowadzając funkcję rozszerzonej rzeczywistości, za pomocą obiektów 3D. Dzięki AR (augmented reality) zyskamy możliwość wchodzenia w interakcję z dostępnymi obiektami. Jest to przydatne, gdy będziemy chcieli sprawdzić, jak nowa poduszka może wyglądać na naszej kanapie lub jak tenisówki mogą wyglądać na naszych stopach.

Nowości w SEO za okres styczeń-marzec 2019

1. Aktualizacja PSI

Narzędzie Page Speed Insight służy do analizowania wydajności stron internetowych zarówno pod kątem obsługi na urządzeniach mobilnych, jak i na komputerach. W przypadku gdy wyniki nie są optymalne, wskazuje, które elementy wymagają poprawy. W ostatnim czasie Google przeprojektował swoje narzędzie i obecnie pokazuje o wiele więcej raportów graficznych. Najważniejsza jest jednak zmiana metodologii – do wyników wykorzystywane są dane z innego narzędzia Google o nazwie Lighthouse oraz dodatkowo podpiera się danymi z Chrome User Experience Report (CrUX). W praktyce najczęściej okazuje się, że przed zmianami narzędzie PSI prezentowało zdecydowanie lepsze wyniki. Dlaczego ma to znaczenie? Nowa porcja dokładniejszych danych zaprezentowana w lepszej formie zachęci webmasterów do pracy nad optymalizacją strony. Zwiększenie szybkości witryny jest ważne nie tylko ze względu na wysoką pozycję w wyszukiwarce Google. Szybko działająca witryna poprawia wrażenia użytkownika i może mieć bezpośredni wpływ na współczynniki konwersji w Twojej witrynie.

2. Nowy format danych uporządkowanych – Q&A

Google na początku grudnia poinformował, że będzie wspierał nowy format danych uporządkowanych, nazwany Q&A Pages. Taki wynik wyszukiwania z karuzelą najlepszych odpowiedzi możemy już obserwować od ponad roku, ale dopiero niedawno Google oficjalnie poinformował, że będzie wspierał ten format danych. Już teraz webmasterzy na swoich stronach typu Q&A mogą oznaczać content wspomnianym formatem danych uporządkowanych. Format oprócz typowych stron Q&A (np. Quora.com) pasuje również forów eksperckich, stron z FAQ oraz help and support message boards. PS Pamiętaj, żeby zawsze sprawdzić nowo wdrożone formaty w narzędziu do testowania danych uporządkowanych od Google: https://search.google.com/ structured-data/testing-tool?hl=pl.

3. Narzędzie do testowania danych uporządkowanych wspiera edycję kodu na żywo

Pozostając w temacie danych uporządkowanych, 7 stycznia za pośrednictwem Twittera Google poinformował, że można już wprowadzać na żywo zmiany w kodzie i zobaczyć jak te zmiany wpłyną na wyświetlanie np. rich snippetów.

4. Migracja raportów w Google Search Console

Od niespełna roku mamy już dostęp do nowej wersji Google Search Console, ale dopiero w grudniu 2018 r. mogliśmy zaobserwować, że część raportów w starym GSC nie jest już dostępna, a w zamian dostaliśmy odesłanie do raportów w nowym GSC. Dodatkowo w pierwszej połowie stycznia John Mueller (@JohnMu) potwierdził podczas Webmaster Hangout, że Google planuje nie przenosić części funkcji do nowej wersji GSC, pomimo informacji podawanych jeszcze w lutym 2018 r. Jako przykład John podał zakładkę „Błędy indeksowania”, twierdząc, że warto skupić się na problemach, które rzeczywiście wpływają na działanie strony, a nie pokazywać wszystkie URLe z błędem, które znalazł robot. Warto też dodać, że zespół pracujący przy GSC przygotowuje nową odsłonę raportu linków, która będzie, cytując, „bardziej spójny”. PS Mała rada dla osób korzystających z GSC: jeśli w swoich raportach SEO odsyłacie do poszczególnych sekcji z GSC, sprawdźcie, czy linki do nich są aktualne. Możliwe, że musicie zaktualizować odnośniki już do nowej wersji.

5. Wprowadzenie asystenta Google w Polsce

W styczniu asystent Google otrzymał oficjalne wsparcie i zaczął wykorzystywać nasz rodzimy język. Póki co zostało udostępnione wsparcie dla urządzeń z Androidem, ale w przyszłości asystent będzie również działał na urządzeniach z iOS. Z perspektywy SEO należy pamiętać o kilku najważniejszych elementach na stronach WWW, jeżeli chcemy, by asystent Google wykorzystywał nasze treści: dobry content (czyli wysoka jakość, unikalność i wyczerpanie danego tematu), odpowiednie słowa kluczowe, krótki czas ładowania stron, poprawna obsługa na urządzeniach mobilnych oraz wykorzystywanie danych uporządkowanych. Dodatkowo na specjalnej platformie Actions on Google firmy będą miały możliwość przygotowania własnych unikalnych komend, które następnie będą zintegrowane z asystentem Google.

Nowości w SEO za okres październik-grudzień 2018

1. Google Medic Update

1 sierpnia br. mieliśmy okazję zaobserwować efekty bardzo szerokiej aktualizacji algorytmu Google. Wahania w pozycjach można było zaobserwować na wielu stronach z różnych branż, ale największe fluktuacje zanotowały witryny określane w Google jako YMYL (Your Money or Your Life), czyli strony zawierające informacje na tematy zdrowotne, finansowe, porady osobiste, strony z danymi osobowymi i transakcyjne.

Zdecydowanie najmocniej ucierpiała branża medyczna – stąd sierpniowa aktualizacja została okrzyknięta jako Medic Update (aut. Barry Schwartz @rustybrick).

pływ aktualizacji z podziałem na kategorie tematyczne wg Moz.com

Tego typu aktualizacja algorytmów (Oficjalny komunikat Google: Broad core ranking update via @searchliaison) bierze pod uwagę wiele różnych czynników, w związku z czym trudno wskazać jedną konkretną przyczynę takiej skali ruchu w pozycjach. Jednakże większość specjalistów SEO pytanych o główny czynnik brany pod uwagę w sierpniowej aktualizacji, najczęściej wskazuje szeroko rozumianą jakość strony docelowej.

2. Aktualizacja Search Quality Evaluator Guidelines

Dokument „Search Quality Evaluator Guidelines” jest zbiorem procedur dla zespołu osób ręcznie oceniających nasze strony (tzw. Google Quality Raters). Ostatnia aktualizacja koncentruje się w szczególności na ocenie jakości – wypunktowane zostały następujące wskaźniki określające słabej jakości witryny:

– Jakość treści głównej jest niska.

– Ilość treści głównej jest niska.

– Tytuł treści jest „przesadzony” (Click bait).

– Strona zawiera reklamy odciągające uwagę od treści głównej.

– Brakuje informacji o twórcy/stronie.

– Reputacja strony lub twórcy treści jest niska.

Warto zwrócić uwagę na ostatnią zmianę w paragrafie dotyczącym E-A-T, odnoszącym się do oceny wartości treści na podstawie trzech elementów:

Expertise – czy autor treści może być uważany za „eksperta” z danego tematu.

Authoritativeness – czy autor treści jest autorytetem w swojej branży.

Trustworthiness – czy strona lub treści na stronie są godne zaufania. Dotyczy to również bezpieczeństwa informacji (podstawą jest tutaj certyfikat SSL).

Nowa aktualizacja w dokumencie SQEG została poszerzona o analizę treści pod kątem E-A-T dla stron z branży medycznej. Dlaczego? Google od zawsze podkreśla, że najważniejszym ich zadaniem jest dostarczanie najlepszych treści odpowiadających na intencję użytkownika. Czasem intencje są bardzo poważne, ponieważ dotyczą takich tematów jak zdrowie, finanse, sprawy osobiste czy też prawne. Konsekwencje wynikające ze stosowania się do niektórych porad znalezionych na stronach wskazanych przez Google mogą bezpośrednio i negatywnie wpłynąć na nasze życie.

3. Wyszukiwarka obrazów – kolejna aktualizacja Google

27 września br. podczas konferencji z okazji 20-lecia firmy Google zostaliśmy poinformowani o dużej aktualizacji w wyszukiwarce obrazów. Zauważalny jest na pewno redesign wyszukiwarki obrazów, ale update dotyczy również backendu, tj. algorytmów decydujących o rankingu zdjęć. Większego znaczenia przy ustalaniu pozycji nabrały m.in. czynnik autorytetu domeny, na której zdjęcie się znajduje, świeżość, pozycja na stronie oraz sama treść, która je otacza.

4. Co zrobić, jeśli widzisz spadek ruchu organicznego?

Po pierwsze sprawdź jakie typy podstron zanotowały spadki w określonym czasie – czy były to strony np. Kategorii, strony produktowe, a może podstrony z artykułami. Następnym krokiem powinno być znalezienie wspólnego mianownika dla tych stron – np. ilość treści, jakość treści. Zalecam analogiczną analizę stron konkurencji. Jeśli jeden z naszych konkurentów zanotował wzrosty, to warto przeanalizować jego ostatnie działania i wyciągnąć wnioski.

Odsyłam do checklisty SEO stworzonej przez Aleyde Solis, która pomoże Ci w zidentyfikowaniu przyczyn spadku ruchu organicznego.

https://www.whymywebtrafficdropped.com

Nowości w SEO za okres lipiec-wrzesień 2018

1. Mobile First Indexing

W kwietniu Google rozpoczął wysyłanie komunikatów przez Google Search Console o włączaniu do indeksu mobilnego. Przy okazji wychwycono, że w przypadku niektórych witryn kopia ostatnio zaindeksowanej strony zwraca błąd 404, jako webmasterzy nie mamy się jednak przejmować tym problemem (w oficjalnej odpowiedzi od Google’a czytamy, że są świadomi istnienia tego problemu i pracują nad rozwiązaniem). Ze względu na sporo wątpliwości odsyłam do artykułu, w którym znajdziesz odpowiedzi na najczęściej pojawiające się pytania dotyczące Mobile First Index.

2. Broad Core Update

20 kwietnia miała miejsce aktualizacja algorytmu Google’a (tzw. Broad Core Update). Jeśli w okolicach tych dni Twoja strona zanotowała spadki lub też wzrost pozycji – już wiesz, co jest powodem. Wnioskując po tweetach pracowników Google’a (@searchliaison), jednym z głównych czynników, który wzięto pod lupę, była treść Jeśli zanotowałeś spadki – zalecam analizę słów kluczowych, na których pozycja się pogorszyła, i podstron/treści, które były z nimi powiązane.

3. Meta description – powrót do przeszłości

Pod koniec zeszłego roku Google zwiększył liczbę znaków wyświetlanych w opisie na poziomie SERP do ok. 300-320. W połowie maja, po kilkumiesięcznym teście, wróciliśmy do długości opisów zbliżonych do poprzednich wartości (ok. 150-160 znaków).

4. Google vs. spam

Zastanawiasz się, z jaką skalą spamu Google walczy każdego dnia? Według oficjalnych informacji – w zeszłym roku do webmasterów zostało wysłanych ponad 6 milionów wiadomości z informacją o wykryciu działań niezgodnych z wytycznymi Google’a. Ponadto Google chwali się skutecznością na poziomie 80% wykrywania i usuwania z indeksu zhakowanych stron. A 45 milionów to liczba wysłanych komunikatów ostrzegających o potencjalnych problemach z witryną.

5. Problem z Yoast SEO

Jeśli Twoja strona stoi na WordPressie i korzystasz z wtyczki Yoast SEO (v. 7.0), to mogłeś zanotować spadki w ruchu SEO. Bazując na oficjalnej informacji od twórcy (@jdevalk) – w wersji 7.0 pojawił się błąd mający duży wpływ na SEO Twojej witryny. Jeśli zauważyłeś spadki w okolicach 6 marca, sprawdź ustawienia swojej wtyczki.

Nowości w SEO za okres kwiecień-czerwiec 2018

1. Zmiany w wyszukiwarce grafiki

Google wprowadziło zmiany w wyszukiwarce grafik. W połowie lutego zniknęły dwie funkcje: „Pokaż obraz” (wyświetlenie samego zdjęcia w pełnej rozdzielczości) oraz wyszukiwanie obrazem z poziomu wybranego zdjęcia. Google przyznaje, że zmiany są wymuszone przez niedawno podpisaną ugodę z agencją Getty Images. Po wprowadzeniu tych zmian zauważalny jest już wzrost ruchu na stronach z wyszukiwarki grafik.

2. Szybkość ładowania strony czynnikiem rankingowym

Speed Update w szczególności dotknie witryny z najsłabszymi czasami ładowania. Bazując na oficjalnych informacjach, można wywnioskować, iż nie jest to zbyt silny czynnik rankingowy. Oznacza to, że strony z dobrą treścią odpowiadającą na zapytania użytkowników, mimo problemów z ładowaniem mogą osiągać wysokie pozycje.

3. Bezpieczniej z HTTPS

Z początkiem lipca 2018, zgodnie z zapowiedziami Google’a, przeglądarka Chrome (ver. 68) będzie oznaczać wszystkie strony oparte na protokole http jako niebezpieczne. W związku z tym w trybie pilnym należy przenieść strony na https.

4. Google bez wyników?

Dzięki kilkudniowym testom mogliśmy się przekonać, jak wyglądałaby wyszukiwarka Google bez wyników wyszukiwań. Dla niewielkiej liczby zapytań wyszukiwarka pokazywała użytkownikom bezpośrednie odpowiedzi na zadane przez nich pytania bez odesłań do witryn. Branża SEO z przerażeniem obserwowała tę zmianę – na szczęście według informacji opublikowanej przez Danny’ego Sullivana dane zostały zebrane, a testowe wyniki – wycofane.

5. Limity indeksowania w GSC

Wraz z wprowadzeniem nowej wersji Google Search Console zmieniono limity indeksowania: zgłoszenie pojedynczych adresów ograniczono z 500 (miesięcznie) do 10 (dziennie), a funkcja indeksowania URL z 10 miesięcznie do 2 razy dziennie. Wielka szkoda, gdyż jest to bardzo przydatna i często wykorzystywana funkcja przez SEO-wców.

6. Multifaceted featured snippets

Kolejną nowością na poziomie wyników wyszukiwania są tzw. multifaceted featured snippets. Efektem tej funkcji będzie wyświetlenie więcej niż jednej bezpośredniej odpowiedzi dla zapytań niejednoznacznych. Jest to kolejna zmiana w wyszukiwarce obniżająca pozycje wyników organicznych. Warto nadmienić, że analogiczna funkcja pojawiła się w grudniu zeszłego roku w wyszukiwarce Bing pod nazwą „multi-perspective answers”.

Nowości w SEO za okres styczeń-marzec 2018

1. Dłuższe opisy stron w SERP

Google wprowadza dłuższe opisy stron wyświetlane na poziomie SERP (search engine result page, czyli wyników wyszukiwania). Stary limit metadescription (ok. 165 wyświetlanych znaków) został mocno przesunięty i już teraz można zauważyć dłuższe snippety (od 230 do nawet ponad 300 znaków). Na Twitterze Danny Sullivan (Google) zasugerował, aby nie robić dłuższych opisów niż na 320 znaków.

2. Geolokalizacja wyników

Z końcem października Google zmieniło sposób zwracania rezultatów wyszukiwania. Do tej pory otrzymywane wyniki były ściśle powiązane z nazwą domeny (ccTLD), tzn. odpytując Google.pl, otrzymywaliśmy „polskie” wyniki, zaś po zmianie domeny (np. na Google.de) otrzymywaliśmy wyniki dopasowane do rynku niemieckiego. Od listopada zmiana domeny nie wpływa na zwracane wyniki – ma na nie wpływ geolokalizacja IP. W oficjalnej informacji od Google czytamy, iż zmiana ma dostarczyć użytkownikowi jak najlepsze wyniki, bazując na jego lokalizacji. Zmiana podejścia wyświetlania wyników bardzo mocno wpływa na narzędzia monitorujące pozycje witryny (bardzo istotne jest teraz, aby adres IP proxy odpytującego Google o pozycję był z Polski).

3. Danny Sullivan w Google

Po raz pierwszy w swojej historii Google zatrudnił specjalistę, który od kilkudziesięciu lat (od 1996 roku) zajmuje się pozycjonowaniem i jest rozpoznawalną postacią w świecie SEO (m.in. redaktorem Search Engine Land, współorganizatorem konferencji „SMX”). Ogromne zaskoczenie branży nie dziwi, gdyż nie raz Danny otwarcie krytykował politykę Google’a w zakresie informowania o zachodzących zmianach. Być może dzięki niemu w najbliższym czasie usłyszymy więcej konkretnych odpowiedzi na pytania związane z działaniem algorytmów Google’a oraz nadchodzącymi zmianami.

4. Nadchodzi nowe Google Search Console

Po latach obietnic Google wprowadza nowe Google Search Console. Póki co w wersji beta najistotniejsza zmiana dotyczy rozszerzenia czasu analizy skuteczności naszych działań („Menu > Ruch związany z wyszukiwaniem > Analityka wyszukiwania”) do 12 miesięcy. Finalna wersja nowego panelu Search Console zapowiadana jest na początek 2018 roku.

5. CTR a SEO?

Podczas konferencji „Think Auto” Nick Frost (Head of Google Brain) powiedział, że Google analizuje dane dotyczące kliknięć w wynikach wyszukiwania. Co prawda nie odpowiedział wprost, czy klikalność ma wpływ na nasze pozycje, ale podkreślił, że algorytmy RankBrain analizują między innymi zachowanie użytkowników na stronach wyników wyszukiwania.

Nowości w SEO za okres październik-grudzień 2017

1. Zainwestuj w SSL

W sierpniu Google przesłał poprzez Google Search Console do stron mających formularze na stronach nieszyfrowanych notyfikacje z ostrzeżeniem, że od wersji Chrome 62 (premiera planowana na październik 2017) takie witryny zostaną oznaczone jako niezabezpieczone.

2. Hawk update

Pod tym kryptonimem kryje się aktualizacja algorytmów Google’a skupionych na lokalnych wynikach. Dzięki niej lokalne biznesy z tej samej branży – np. gabinety dentystyczne – znajdujące się w bardzo bliskiej odległości, będą miały szansę wyświetlać się równocześnie na ,,mapkach” w wynikach wyszukiwania. Wcześniej z biznesów znajdujących się bardzo blisko siebie część była odfiltrowywana.

3. Dlaczego https jest istotne?

Jeśli punkt 1. nie przekonuje Cię do certyfikatu SSL, to weź pod uwagę fakt, iż jest to czynnik rankingowy oraz bardzo istotny element uwiarygadniający witrynę. W perspektywie czasu brak strony szyfrowanej może obniżać współczynnik konwersji Twojej strony.

4. Czynniki SEO wg Googlersów

Gary Illyes w dyskusji na Twitterze potwierdził, że czynniki rankingowe są uzależnione od zapytania wpisywanego w Google. Co oznacza, że dla słów kluczowych z różnych branż najważniejsze czynniki rankingujące mogą być zupełnie inne.

5. Przewaga mobile nad desktopem

Minęły dwa lata od momentu, gdy – według Google’a – liczba mobilnych wyszukiwań przekroczyła liczbę zapytań z poziomu desktopu. StatCounter podał, że aktualnie 54% ruchu w USA generowane jest przez urządzenia mobilne. W niektórych branżach, jak np. restauracjach procent ten jest jeszcze większy.

Nowości w SEO za okres lipiec-wrzesień 2017

1. Google wchodzi na rynek ofert pracy

Podczas ostatniej konferencji I/O Google zapowiedziało nowy projekt pt. „Wyszukiwarka łącząca pracodawców z osobami szukającymi pracy”. Czyżby nadchodziły trudne czasy dla wszystkich serwisów ogłoszeniowych z ofertami pracy?

2. Darmowy kreator stron dla małych biznesów

Google oficjalnie udostępniło darmowy kreator stron dedykowany małym biznesom. To proste narzędzie nazwane „Website” według obietnic pozwoli właścicielom małych fi rm tworzyć strony zarówno pod desktop, jak i mobile w przeciągu kilku minut. Ten krok ma pomóc małym firmom zaistnieć w internecie – według Google’a 60% takich firm nie ma strony internetowej.

3. Anchor text w linkach nadal ma znaczenie

Według analizy wykonanej przez ahrefs (narzędzie do analizy linków prowadzących do stron) anchor text w linkach nadal ma znaczenie! Większe niż Google chce, żebyśmy myśleli.

4. Algorytmy Google’a coraz bardziej skuteczne w rozpoznaniu płatnych linków

Gary Illyes z Google’a, podczas konferencji SMX Advanced, po raz kolejny wypowiedział się na temat kupowania linków z blogów. Jego zdaniem „jest to wyrzucanie pieniędzy przez okno”. Dodał także, że „takie linki nie są liczone przez Google’a” (według deklaracji Gary’ego algorytmy Google’a są coraz bardziej skuteczne w rozpoznawaniu i ignorowaniu płatnych linków). Ponadto Google przestrzega przed angażowaniem na dużą skalę takiej formy link buildingu.

5. Wciąż zbyt mało treści nieanglojęzycznych w Google’u

Gary Illyes z Google’a zasugerował tworzenie większej ilości treści w innych językach niż angielskim. W sieci (a tym samym w indeksie Google’a) nadal jest za mało treści nieanglojęzycznych.

6. Mobile coraz bardziej popularne

Według najnowszego raportu firmy Hitwise prawie 60% wszystkich zapytań do wyszukiwarek pochodzi od użytkowników korzystających z urządzeń mobilnych. Według badań są branże (jedzenie i napoje), które osiągają nawet poziom 72%.

Nowości w SEO za okres kwiecień-czerwiec 2017

1. Aktualne czynniki rankingowe wg raportu Search Metrics

Analiza przygotowana przez Search Metrics, oparta o ogromną liczbę badanych stron, pokazuje korelacje między określonymi czynnikami SEO, takimi jak: https (szyfrowana wersja witryny), CTR, liczba linków prowadzących do witryny a jej pozycją (rys. obok). Warto zwrócić uwagę również na czynniki behawioralne, czyli to, jak często wchodzi się na daną stronę i ile spędza się na niej czasu.

2. Wideo na stronie poprawia time on site

Umieszczenie wideo na stronie WWW znacząco wydłuża czas spędzony na niej przez użytkownika (ang. time on site). Jak podaje serwis wistia.com, dodając materiał wideo na swoją stronę internetową, możesz sprawić, że odwiedzający ją będą przebywać tam dwa razy dłużej. Ma to duże znaczenie także z punktu widzenia SEO, ponieważ długość czasu spędzonego na stronie internetowej podnosi jej pozycję w wyszukiwarce.

3. Czy szybkość strony wpływa na SEO?

Zaobserwowano zależność pomiędzy czasem ładowania strony a pozycjonowaniem. Na podstawie analizy prawie 150 tysięcy adresów URL zauważono, że prędkość ładowania witryny ma pozytywny wpływ na SEO.

4. Google crawl budget

Właścicieli stron z bardzo dużym indeksem witryn, posiadających wiele podstron, powinno zainteresować zagadnienie crawl budget. To element, który warto mieć na uwadze po to, by Google jak najczęściej śledziło i indeksowało twoją witrynę.

5. Emoji w wynikach wyszukiwania

Po 2 latach nieobecności w wynikach wyszukiwania Google ponownie można zobaczyć emoji. Emotikony mogą być wyświetlane zarówno w ad – resach URL, jak i w tytule oraz opisach stron internetowych.

6. Dmoz.org znika z sieci

Dmoz.org, czyli najstarszy katalog stron internetowych, znika z sieci. Umieszczenie w nim swoich stron generowało mocne linki. Był to jeden z ostatnich katalogów, które na przestrzeni lat miały wpływ na SEO.

7. Wytyczne dotyczące oceniania stron od Google’a

Od pewnego czasu Google publikuje dokumenty z wytycznymi dla pracowników. W marcu br. udostępniono wytyczne dotyczące oceniania stron, mówiące m.in. o parametrach dla różnego rodzaju witryn. Zapoznanie się z nimi pozwoli dowiedzieć się, jak odpowiednio planować swoje działania

27 min

27 min

Warszawa

Warszawa

Przypominamy, że wielkimi krokami zbliża się konferencja I ♥ Marketing & Technology, która odbędzie się już 16–18 kwietnia 2024 roku oraz organizowane przez nas 33 szkolenia z zakresu marketingu.

Jeśli chcesz być zawsze na bieżąco, zamów prenumeratę magazynu sprawny.marketing!

Z kolei jeśli chcesz mieć dostęp do całej wiedzy sprawny.marketing w jednym miejscu, subskrybuj platformę premium.sprawny.marketing.

Hey there! I’ve been reading your weblog for some time now and finally got the courage to go ahead and give you a shout out from Dallas Texas! Just wanted to say keep up the excellent job!